ICCV 2021 Oral | 重新思考人群计数和定位:一个纯粹基于点的框架

source link: https://bbs.cvmart.net/articles/5216

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

人群计数新范式!本文提出P2PNet:一个纯粹基于点的框架,可来直接预测人群数量和人群个体的位置,并提出一个新的度量标准,称为密度归一化平均精度 (nAP),代码即将开源!

ICCV 2021 论文和代码合集链接如下,也欢迎大家提交issue,分享你的ICCV 2021论文或者开源工作。

ICCV2021-Papers-with-Codegithub.com

Rethinking Counting and Localization in Crowds:A Purely Point-Based Framework

单位:腾讯优图, 腾讯PCG

代码:https://github.com/TencentYoutuResearch/CrowdCounting-P2PNet

论文下载链接:https://arxiv.org/abs/2107.12746

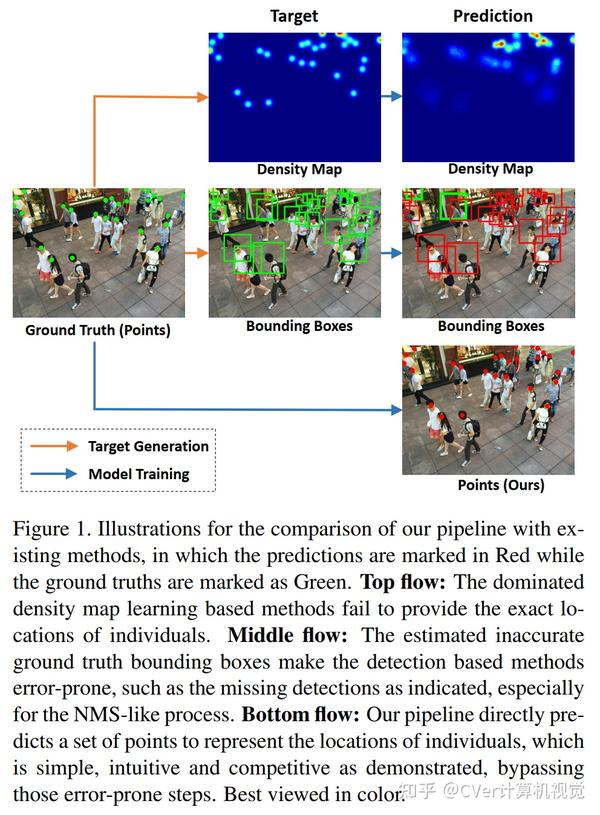

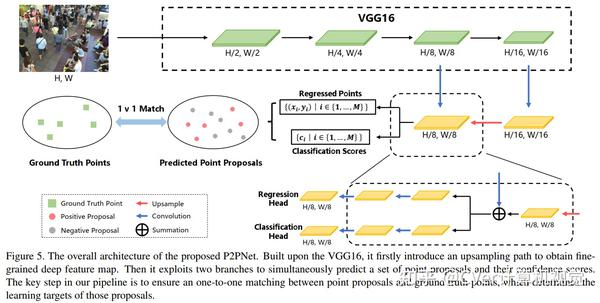

在人群中定位人体更符合后续高级人群分析任务的实际需求,而不是简单地计数。然而,现有的基于定位的方法依赖于作为学习目标的中间表示,即密度图或伪框是违反直觉和容易出错的。在本文中,我们提出了一个纯粹基于点的框架,用于联合人群计数和人体定位。

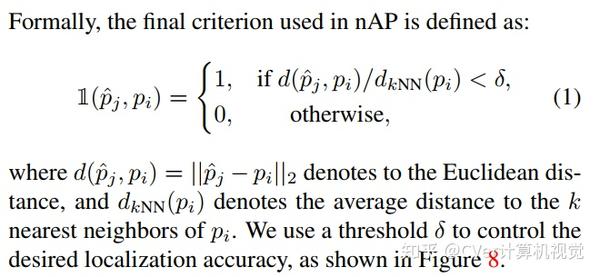

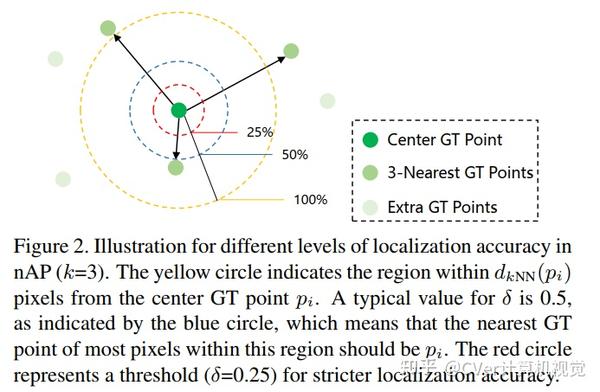

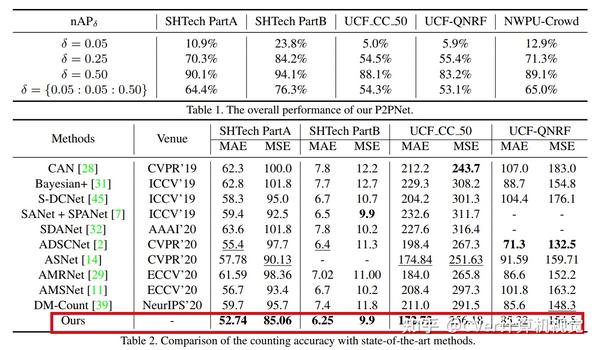

对于这个框架,我们提出了一个新的度量标准,称为密度归一化平均精度 (nAP),而不是仅仅报告图像级别的绝对计数误差,以提供更全面和更精确的性能评估。

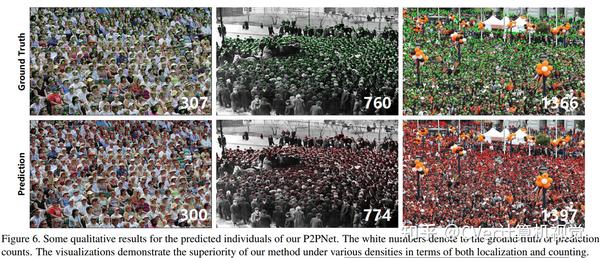

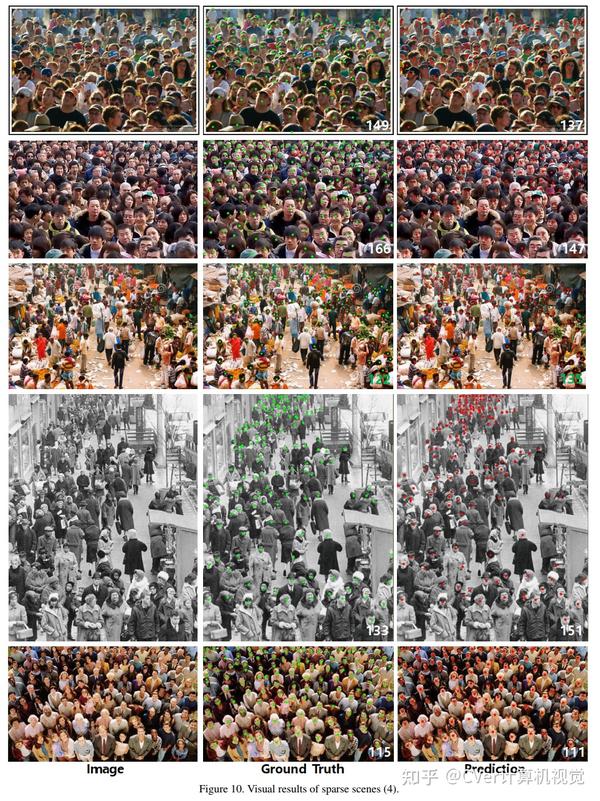

此外,我们在这个框架下设计了一个直观的解决方案,称为点对点网络(P2PNet,Point to Point Network)。 P2PNet 丢弃了多余的步骤,直接预测一组点propoals来表示图像中的头部,与人类注释结果一致。

通过彻底的分析,我们揭示了实现这种新颖想法的关键步骤是为这些proposals分配最佳学习目标。因此,我们提出使用匈牙利算法以一对一匹配的方式进行这一关键关联。

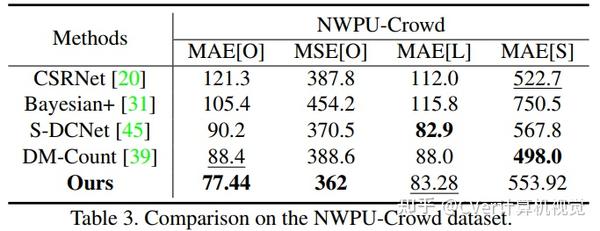

P2PNet 不仅在流行的计数基准上显著超越了最先进的方法,而且还实现了有希望的定位精度。

相关推荐:

目标跟踪 CVPR,ICCV,ECCV 文章及代码实时更新

ICCV2021|性能优于 MoCo v2,DetCo:为目标检测定制任务的对比学习

ICCV2021 最全整理:论文分类汇总 / 代码 / 项目 / 论文解读(更新中)【计算机视觉】

1

0

1994

Recommend

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK