LDA-math-LDA 文本建模

source link: https://cosx.org/2013/03/lda-math-lda-text-modeling/

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

5. LDA 文本建模

5.1 游戏规则

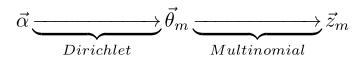

对于上述的 PLSA 模型,贝叶斯学派显然是有意见的,doc-topic 骰子→θm和 topic-word 骰子→φk都是模型中的参数,参数都是随机变量,怎么能没有先验分布呢?于是,类似于对 Unigram Model 的贝叶斯改造, 我们也可以如下在两个骰子参数前加上先验分布从而把 PLSA 对应的游戏过程改造为一个贝叶斯的游戏过程。由于 →φk和→θm都对应到多项分布,所以先验分布的一个好的选择就是 Drichlet 分布,于是我们就得到了 LDA(Latent Dirichlet Allocation) 模型。

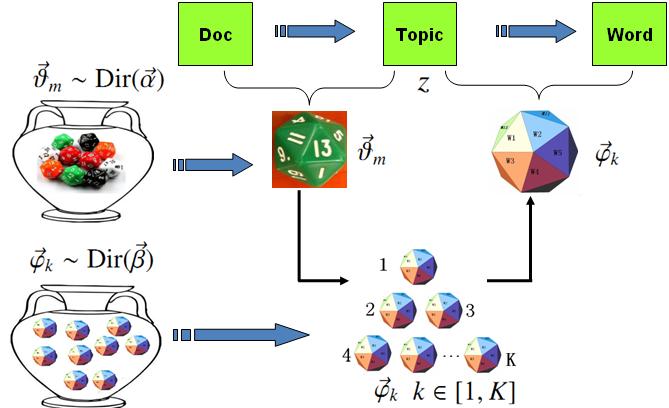

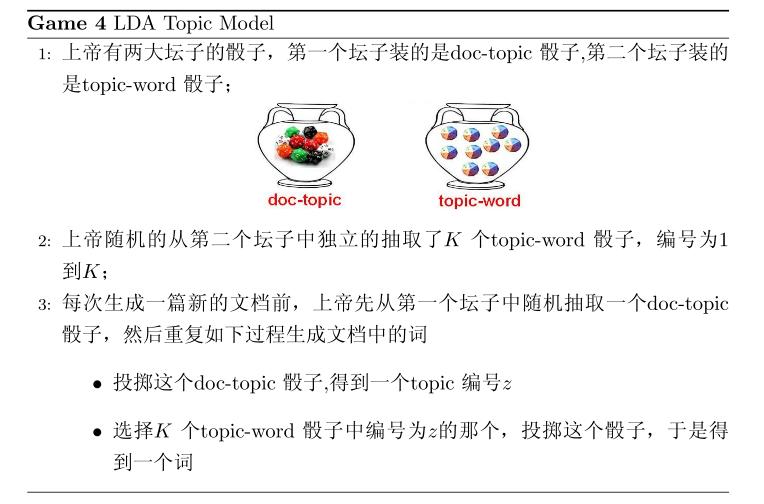

LDA 模型

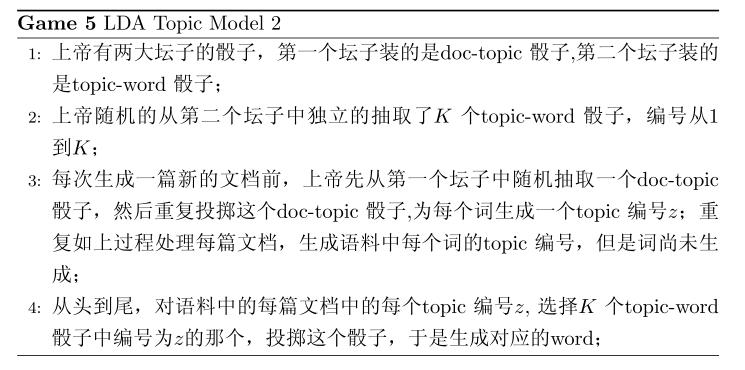

在 LDA 模型中, 上帝是按照如下的规则玩文档生成的游戏的

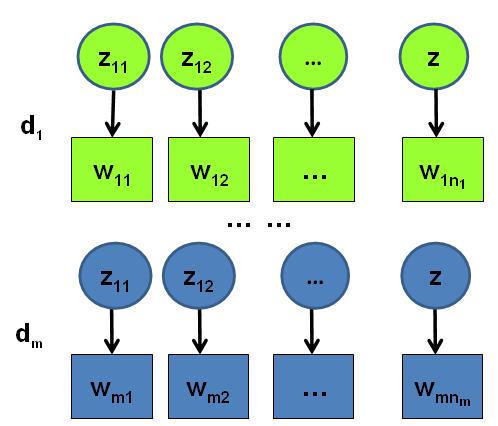

假设语料库中有M篇文档,所有的的 word 和对应的 topic 如下表示

→w=(→w1,⋯,→wM)→z=(→z1,⋯,→zM)

其中,→wm表示第m篇文档中的词,→zm表示这些词对应的 topic 编号。

语料生成过程中的 word 和 topic

5.2 物理过程分解

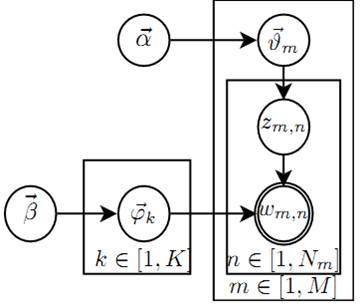

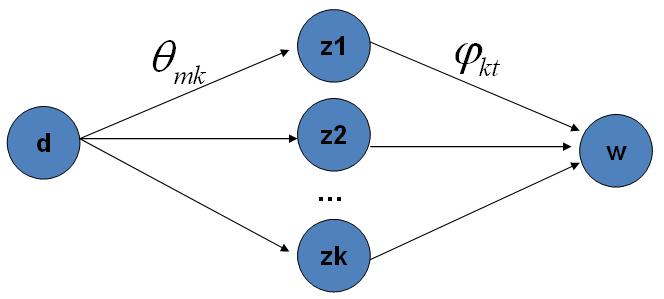

使用概率图模型表示, LDA 模型的游戏过程如图所示。

LDA 概率图模型表示

这个概率图可以分解为两个主要的物理过程:

- →α→→θm→zm,n, 这个过程表示在生成第m 篇文档的时候,先从第一个坛子中抽了一个 doc-topic 骰子→θm, 然后投掷这个骰子生成了文档中第n 个词的 topic 编号zm,n;

- →β→→φk→wm,n|k=zm,n, 这个过程表示用如下动作生成语料中第m篇文档的第n个词:在上帝手头的K个 topic-word 骰子 →φk中,挑选编号为k=zm,n的那个骰子进行投掷,然后生成 wordwm,n;

理解 LDA 最重要的就是理解这两个物理过程。 LDA 模型在基于K个 topic 生成语料中的M篇文档的过程中, 由于是 bag-of-words 模型,有一些物理过程是相互独立可交换的。由此,LDA 生成模型中,M篇文档会对应于 $M$ 个独立的 Dirichlet-Multinomial 共轭结构;K个 topic 会对应于K个独立的 Dirichlet-Multinomial 共轭结构。所以理解 LDA 所需要的所有数学就是理解 Dirichlet-Multiomail 共轭,其它都就是理解物理过程。现在我们进入细节, 来看看 LDA 模型是如何被分解为M+K个 Dirichlet-Multinomial 共轭结构的。

由第一个物理过程,我们知道→α→→θm→→zm表示生成第m篇文档中的所有词对应的 topics,显然→α→→θm对应于 Dirichlet 分布,→θm→→zm对应于 Multinomial 分布, 所以整体是一个 Dirichlet-Multinomial 共轭结构;

前文介绍 Bayesian Unigram Model 的小节中我们对 Dirichlet-Multinomial 共轭结构做了一些计算。借助于该小节中的结论,我们可以得到

p(→zm|→α)=Δ(→nm+→α)Δ(→α)

其中→nm=(n(1)m,⋯,n(K)m),n(k)m表示第m篇文档中第k个 topic 产生的词的个数。进一步,利用 Dirichlet-Multiomial 共轭结构,我们得到参数→θm的后验分布恰好是

Dir(→θm|→nm+→α).

由于语料中M篇文档的 topics 生成过程相互独立,所以我们得到M个相互独立的 Dirichlet-Multinomial 共轭结构,从而我们可以得到整个语料中 topics 生成概率

p(→z|→α)=M∏m=1p(→zm|→α)=M∏m=1Δ(→nm+→α)Δ(→α)(∗)

目前为止,我们由M篇文档得到了M个 Dirichlet-Multinomial 共轭结构,还有额外K个 Dirichlet-Multinomial 共轭结构在哪儿呢?在上帝按照之前的规则玩 LDA 游戏的时候,上帝是先完全处理完成一篇文档,再处理下一篇文档。文档中每个词的生成都要抛两次骰子,第一次抛一个 doc-topic 骰子得到 topic, 第二次抛一个 topic-word 骰子得到 word,每次生成每篇文档中的一个词的时候这两次抛骰子的动作是紧邻轮换进行的。如果语料中一共有N个词,则上帝一共要抛 2N次骰子,轮换的抛 doc-topic 骰子和 topic-word 骰子。但实际上有一些抛骰子的顺序是可以交换的,我们可以等价的调整2N次抛骰子的次序:前N次只抛 doc-topic 骰子得到语料中所有词的 topics, 然后基于得到的每个词的 topic 编号,后 $N$ 次只抛 topic-word 骰子生成N个 word。于是上帝在玩 LDA 游戏的时候,可以等价的按照如下过程进行:

以上游戏是先生成了语料中所有词的 topic, 然后对每个词在给定 topic 的条件下生成 word。在语料中所有词的 topic 已经生成的条件下,任何两个 word 的生成动作都是可交换的。于是我们把语料中的词进行交换,把具有相同 topic 的词放在一起

→w′=(→w(1),⋯,→w(K))→z′=(→z(1),⋯,→z(K))

其中,→w(k)表示这些词都是由第k个 topic 生成的,→z(k)对应于这些词的 topic 编号,所以→z(k)中的分量都是k。

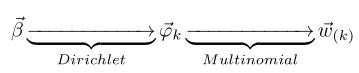

对应于概率图中的第二个物理过程→β→→φk→wm,n|k=zm,n,在k=zm,n的限制下,语料中任何两个由 topick生成的词都是可交换的,即便他们不再同一个文档中,所以我们此处不再考虑文档的概念,转而考虑由同一个 topic 生成的词。考虑如下过程→β→→φk→→w(k),容易看出, 此时→β→→φk对应于 Dirichlet 分布,→φk→→w(k)对应于 Multinomial 分布, 所以整体也还是一个 Dirichlet-Multinomial 共轭结构;

同样的,我们可以得到

p(→w(k)|→β)=Δ(→nk+→β)Δ(→β)

其中→nk=(n(1)k,⋯,n(V)k),n(t)k表示第k个 topic 产生的词中 word t的个数。进一步,利用 Dirichlet-Multiomial 共轭结构,我们得到参数→φk的后验分布恰好是

Dir(→φk|→nk+→β).

而语料中K个 topics 生成 words 的过程相互独立,所以我们得到K个相互独立的 Dirichlet-Multinomial 共轭结构,从而我们可以得到整个语料中词生成概率

p(→w|→z,→β)=p(→w′|→z′,→β)=K∏k=1p(→w(k)|→z(k),→β)=K∏k=1Δ(→nk+→β)Δ(→β)(∗∗)

结合 (*) 和 (**) 于是我们得到

p(→w,→z|→α,→β)=p(→w|→z,→β)p(→z|→α)=K∏k=1Δ(→nk+→β)Δ(→β)M∏m=1Δ(→nm+→α)Δ(→α)(∗∗∗)

此处的符号表示稍微不够严谨, 向量→nk,→nm都用n表示,主要通过下标进行区分, k下标为 topic 编号, m下标为文档编号。

5.3 Gibbs Sampling

有了联合分布p(→w,→z),万能的 MCMC 算法就可以发挥作用了!于是我们可以考虑使用 Gibbs Sampling 算法对这个分布进行采样。当然由于 →w是观测到的已知数据,只有 →z是隐含的变量,所以我们真正需要采样的是分布 p(→z|→w)。在 Gregor Heinrich 那篇很有名的 LDA 模型科普文章 Parameter estimation for text analysis 中,是基于 (***) 式推导 Gibbs Sampling 公式的。此小节中我们使用不同的方式,主要是基于 Dirichlet-Multinomial 共轭来推导 Gibbs Sampling 公式,这样对于理解采样中的概率物理过程有帮助。

语料库→z中的第i个词我们记为zi, 其中i=(m,n)是一个二维下标,对应于第m篇文档的第 n个词,我们用¬i表示去除下标为i的词。那么按照 Gibbs Sampling 算法的要求,我们要求得任一个坐标轴i 对应的条件分布p(zi=k|→z¬i,→w)。假设已经观测到的词wi=t, 则由贝叶斯法则,我们容易得到

p(zi=k|→z¬i,→w)∝p(zi=k,wi=t|→z¬i,→w¬i)

由于zi=k,wi=t只涉及到第m篇文档和第k个 topic,所以上式的条件概率计算中, 实际上也只会涉及到如下两个 Dirichlet-Multinomial 共轭结构

- →α→→θm→→zm

- →β→→φk→→w(k)

其它的M+K−2个 Dirichlet-Multinomial 共轭结构和zi=k,wi=t是独立的。

由于在语料去掉第i个词对应的(zi,wi),并不改变我们之前讨论的M+K个 Dirichlet-Multinomial 共轭结构,只是某些地方的计数会减少。所以→θm,→φk的后验分布都是 Dirichlet:

p(→θm|→z¬i,→w¬i)=Dir(→θm|→nm,¬i+→α)p(→φk|→z¬i,→w¬i)=Dir(→φk|→nk,¬i+→β)

使用上面两个式子,把以上想法综合一下,我们就得到了如下的 Gibbs Sampling 公式的推导

p(zi=k|→z¬i,→w)∝p(zi=k,wi=t|→z¬i,→w¬i)=∫p(zi=k,wi=t,→θm,→φk|→z¬i,→w¬i)d→θmd→φk=∫p(zi=k,→θm|→z¬i,→w¬i)⋅p(wi=t,→φk|→z¬i,→w¬i)d→θmd→φk=∫p(zi=k|→θm)p(→θm|→z¬i,→w¬i)⋅p(wi=t|→φk)p(→φk|→z¬i,→w¬i)d→θmd→φk=∫p(zi=k|→θm)Dir(→θm|→nm,¬i+→α)d→θm⋅∫p(wi=t|→φk)Dir(→φk|→nk,¬i+→β)d→φk=∫θmkDir(→θm|→nm,¬i+→α)d→θm⋅∫φktDir(→φk|→nk,¬i+→β)d→φk=E(θmk)⋅E(φkt)=ˆθmk⋅ˆφkt

以上推导估计是整篇文章中最复杂的数学了,表面上看上去复杂,但是推导过程中的概率物理意义是简单明了的:zi=k,wi=t的概率只和两个 Dirichlet-Multinomial 共轭结构关联。而最终得到的 ˆθmk,ˆφkt 就是对应的两个 Dirichlet 后验分布在贝叶斯框架下的参数估计。借助于前面介绍的 Dirichlet 参数估计的公式 ,我们有

ˆθmk=n(k)m,¬i+αk∑Kk=1(n(k)m,¬i+αk)ˆφkt=n(t)k,¬i+βt∑Vt=1(n(t)k,¬i+βt)

于是,我们最终得到了 LDA 模型的 Gibbs Sampling 公式

p(zi=k|→z¬i,→w)∝n(k)m,¬i+αk∑Kk=1(n(k)m,¬i+αk)⋅n(t)k,¬i+βt∑Vt=1(n(t)k,¬i+βt)

这个公式是很漂亮的, 右边其实就是p(topic|doc)⋅p(word|topic),这个概率其实是doc→topic→word的路径概率,由于 topic 有K个,所以 Gibbs Sampling 公式的物理意义其实就是在这K条路径中进行采样。

doc-topic-word 路径概率

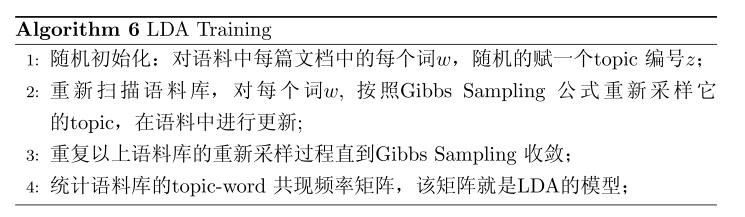

5.4 Training and Inference

有了 LDA 模型,当然我们的目标有两个

- 估计模型中的参数→φ1,⋯,→φK和→θ1,⋯,→θM;

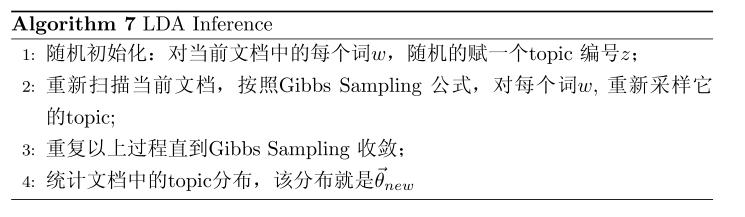

- 对于新来的一篇文档docnew,我们能够计算这篇文档的 topic 分布→θnew。

有了 Gibbs Sampling 公式, 我们就可以基于语料训练 LDA 模型,并应用训练得到的模型对新的文档进行 topic 语义分析。训练的过程就是获取语料中的(z,w)的样本,而模型中的所有的参数都可以基于最终采样得到的样本进行估计。训练的流程很简单:

对于 Gibbs Sampling 算法实现的细节,请参考 Gregor Heinrich 的 Parameter estimation for text analysis 中对算法的描述,以及 PLDA 的代码实现,此处不再赘述。

由这个 topic-word 频率矩阵我们可以计算每一个p(word|topic)概率,从而算出模型参数→φ1,⋯,→φK,这就是上帝用的K个 topic-word 骰子。当然,语料中的文档对应的骰子参数 →θ1,⋯,→θM在以上训练过程中也是可以计算出来的,只要在 Gibbs Sampling 收敛之后,统计每篇文档中的 topic 的频率分布,我们就可以计算每一个p(topic|doc)概率,于是就可以计算出每一个→θm。由于参数→θm是和训练语料中的每篇文档相关的,对于我们理解新的文档并无用处,所以工程上最终存储 LDA 模型时候一般没有必要保留。通常,在 LDA 模型训练的过程中,我们是取 Gibbs Sampling 收敛之后的n个迭代的结果进行平均来做参数估计,这样模型质量更高。

有了 LDA 的模型,对于新来的文档docnew,我们如何做该文档的 topic 语义分布的计算呢?基本上 inference 的过程和 training 的过程完全类似。对于新的文档, 我们只要认为 Gibbs Sampling 公式中的ˆφkt 部分是稳定不变的,是由训练语料得到的模型提供的,所以采样过程中我们只要估计该文档的 topic 分布→θnew就好了。

LDA 对于专业做机器学习的兄弟而言,只能算是一个简单的 Topic Model。但是对于互联网中做数据挖掘、语义分析的工程师,LDA 的门槛并不低。 LDA 典型的属于这样一种机器学习模型:要想理解它,需要比较多的数学背景,要在工程上进行实现,却相对简单。 Gregor Heinrich 的 LDA 模型科普文章 Parameter estimation for text analysis 写得非常的出色,这是学习 LDA 的必看文章。不过即便是这篇文章,对于工程师也是有门槛的。我写的这个科普最好对照 Gregor Heinrich 的这篇文章来看, 我用的数学符号也是尽可能和这篇文章保持一致。

这份 LDA 科普是基于给组内兄弟做报告的 ppt 整理而成的,说是科普其实也不简单,涉及到的数学还是太多。在工业界也混了几年,经常感觉到工程师对于学术界的玩的模型有很强的学习和尝试的欲望,只是学习成本往往太高。所以我写 LDA 的初衷就是写给工业界的工程师们看的,希望把学术界玩的一些模型用相对通俗的方式介绍给工程师;如果这个科普对于读研究生的一些兄弟姐妹也有所启发,只能说那是一个 side effect :-)。

我个人很喜欢 LDA ,它是在文本建模中一个非常优雅的模型,相比于很多其它的贝叶斯模型, LDA 在数学推导上简洁优美。学术界自 2003 年以来也输出了很多基于 LDA 的 Topic Model 的变体,要想理解这些更加高级的 Topic Model, 首先需要很好的理解标准的 LDA 模型。在工业界, Topic Model 在 Google、Baidu 等大公司的产品的语义分析中都有着重要的应用;所以 Topic Model 对于工程师而言,这是一个很有应用价值、值得学习的模型。我接触 Topic Model 的时间不长,主要是由于 2 年前和 PLDA 的作者 Wangyi 一起合作的过程中,从他身上学到了很多 Topic Model 方面的知识。关于 LDA 的相关知识,其实可以写的还有很多:如何提高 LDA Gibbs Sampling 的速度、如何优化超参数、如何做大规模并行化、LDA 的应用、LDA 的各种变体…… 不过我的主要目标还是科普如何理解标准的 LDA 模型。

学习一个模型的时候我喜欢追根溯源,常常希望把模型中的每一个数学推导的细节搞明白,把公式的物理意义想清楚,不过数学推导本身并不是我想要的,把数学推导还原为物理过程才是我乐意做的事。最后引用一下物理学家费曼的名言结束 LDA 的数学科普:

What I cannot create, I do not understand.

— Richard Feynman

LDA 数学八卦

LDA-math 的汇总, “LDA 数学八卦. pdf” 我整理贴出来了, 希望对大家理解 LDA 有帮助。 文章标题挂上 “八卦” 两字, 因为八卦意味着形式自由、不拘束、可以天马行空,细节处理上也难免有不严谨的地方;当然我也希望八卦是相对容易理解的。

敬告各位友媒,如需转载,请与统计之都小编联系(直接留言或发至邮箱:[email protected]),获准转载的请在显著位置注明作者和出处(转载自:统计之都),并在文章结尾处附上统计之都微信二维码。

Recommend

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK