大语言模型击败扩散模型!视频图像生成双SOTA,谷歌CMU最新研究,一作北大校友

source link: https://www.51cto.com/article/769960.html

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

大语言模型击败扩散模型!视频图像生成双SOTA,谷歌CMU最新研究,一作北大校友

语言模型击败扩散模型,在视频和图像生成上实现双SOTA!

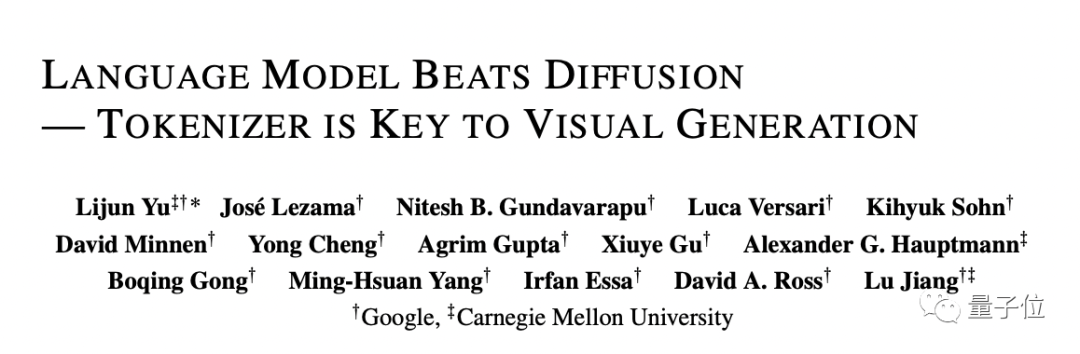

这是来自谷歌CMU最新研究成果。

据介绍,这是语言模型第一次在标志性的ImageNet基准上击败扩散模型。

而背后的关键组件在于视觉分词器(video tokenizer) ,它能将像素空间输入映射为适合LLM学习的token。

谷歌CMU研究团队提出了MAGVIT-v2,在另外两项任务中超越了之前最优视觉分词器。

大语言模型击败扩散模型

已经形成共识的是,大语言模型在各个生成领域都有出色的表现。比如文本、音频、代码生成等。

但一直以来在视觉生成方面,语言模型却落后于扩散模型。

团队认为,其主要原因在于缺乏一个好的视觉表示,类似于自研语言系统,能有效地对视觉世界进行建模。与自然语言不同,人类会对视觉世界尚未演化出最佳的词汇。而这也限制了大语言模型的视觉生成能力。

基于这样的判断,这篇研究主要完成了三项工作:

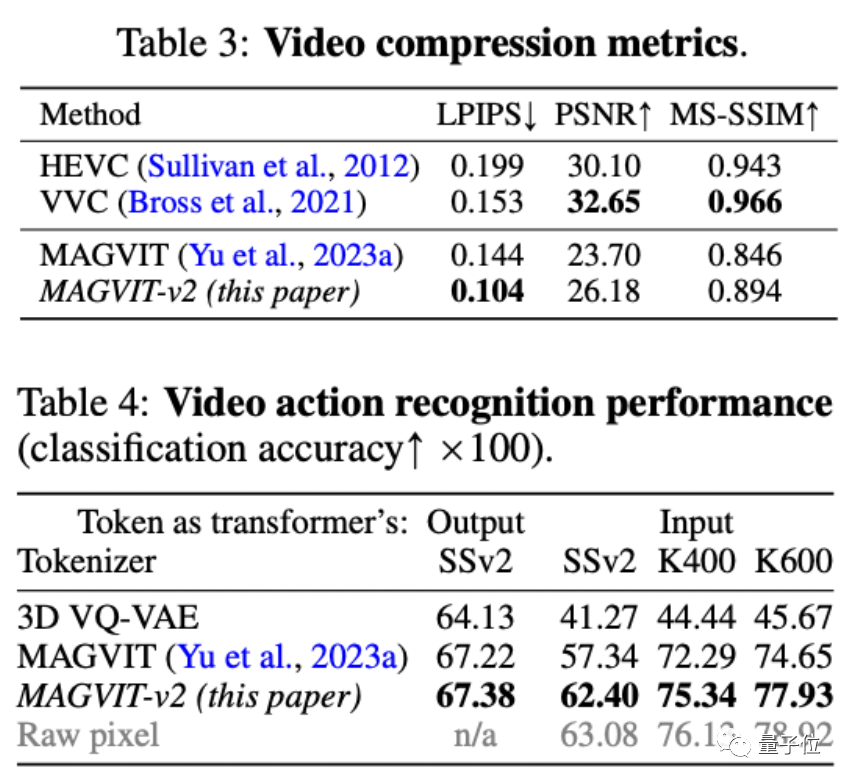

- 提出一种新的视觉tokenizer,在视觉生成、视频压缩以及动作识别都优于此前最优表现。

- 一种全新无查找(lookup-free)的量化方法,可通过学习大量词汇来提高语言模型的视觉生成质量;

- 首次有证据表明,在相同训练数据、等效模型大小和类似训练预算的条件下,语言模型在ImageNet上击败扩散模型。

据作者介绍,这也是视觉分词器首次成功地实现了与标准编解码器相媲美的效果。

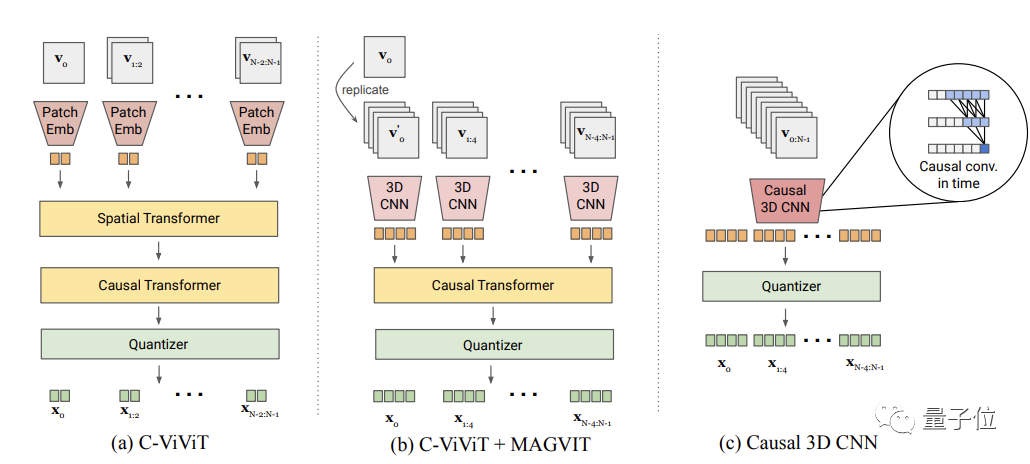

在原有SOTA视觉tokenizerMAGVIT (Masked Generative Video Transformer)基础上,该方法主要完成了两种设计:无查找量化(Lookup-Free Quantization ,LFQ)以及图像-视频联合tokenizer。

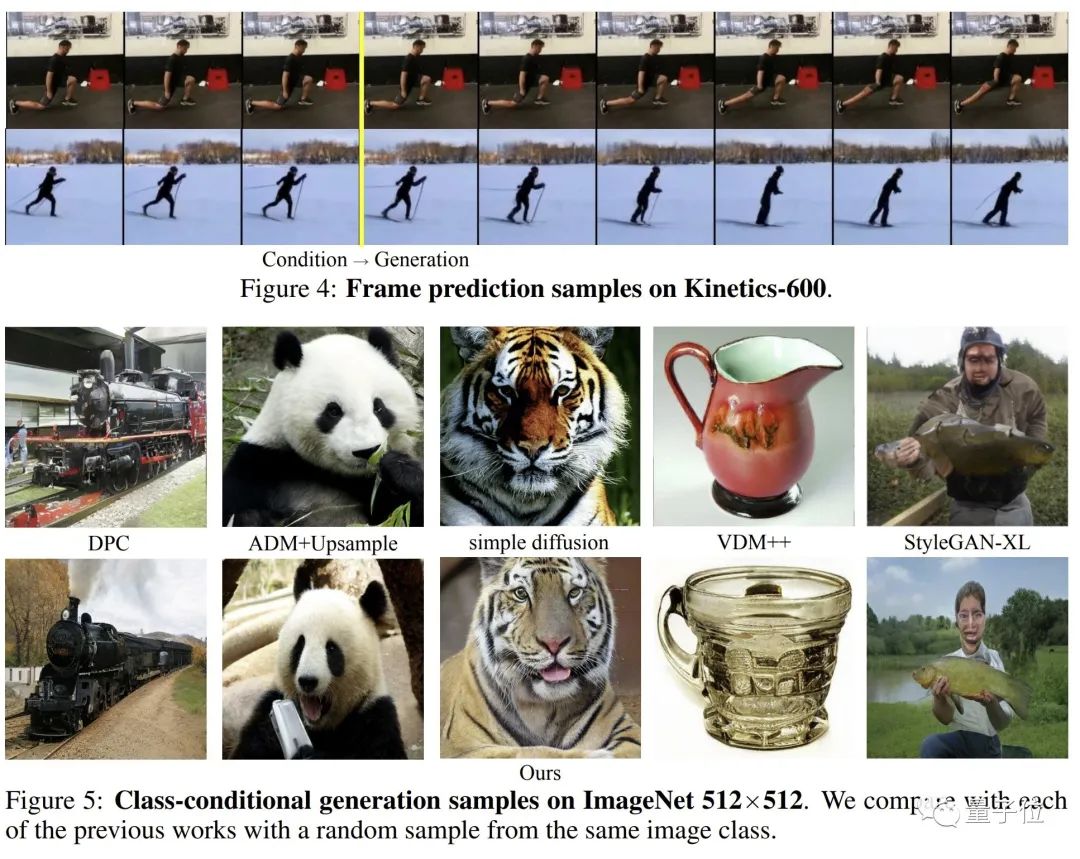

最终在视频/图像生成,ImageNet 512×512和Kinetics-600,都优于Diffusion Model。

而在视频压缩、动作识别上,也优于以往的结果。

一作是北大校友

一作于力军目前是CMU计算机科学学院语言技术研究所博士生,师从Alexander G. Hauptmann教授,同时也是谷歌学生研究员。研究兴趣在于多模态基础模型,特别是多任务视频生成。

在来到CMU前,他在北大获得了计算机和经济学双学士学位。

在研究团队中也看到了其他不少华人面孔。

通讯作者蒋路,目前是谷歌研究院科学家以及CMU的兼职教授。

他的研究主要针对多模态大数据科领域,特别是鲁棒深度学习、生成式人工智能和多模态基础模型。

论文链接:

https://arxiv.org/abs/2310.05737

https://magvit.cs.cmu.edu/v2/

Recommend

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK