吴恩达、Hinton最新对话!AI不是随机鹦鹉,共识胜过一切,LeCun双手赞成

source link: https://www.51cto.com/article/757512.html

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

吴恩达、Hinton最新对话!AI不是随机鹦鹉,共识胜过一切,LeCun双手赞成

近来,AI安全已成为高度命中的话题。

AI「教父」Geoffrey Hinton和吴恩达就人工智能和灾难性风险进行了一次深度的隔空对话。

吴恩达今日发文分享了他们的共同想法:

- 人工智能科学家对风险达成共识很重要。类似于气候科学家,他们对气候变化有大致的共识,所以能制定良好的政策。

- 人工智能模型是否了解这个世界?我们的答案是肯定的。如果我们列出这些关键技术问题,并形成共同观点,将有助于推动人类在风险方面达成共识。

Hinton表示,

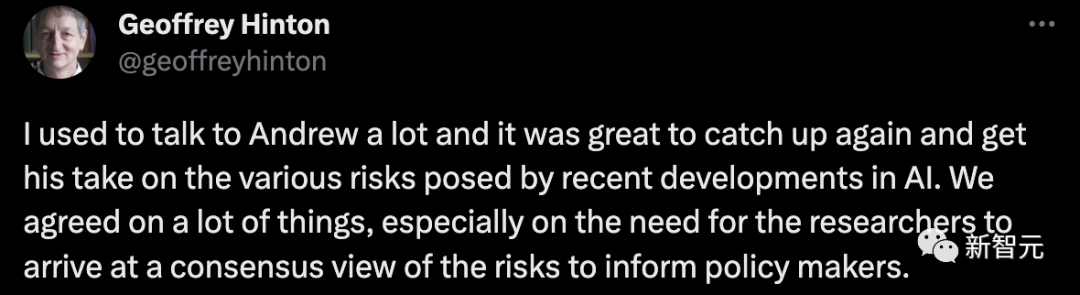

我以前经常和吴恩达进行交谈,很高兴再次见面,并了解到他对人工智能最近发展所带来的各种风险的看法。我们在很多事情上达成了共识,特别是,研究人员需要对风险达成共识,以告知政策制定者。

在此之前,吴恩达同样和Yoshua Bengio进行了人工智能风险的对话。

他们得出的一致意见是,阐明AI可能带来重大风险的具体场景。

接下来,一起来看看两位AI大佬都具体讨论了什么。

急需共识!

首先,Hinton提出,最重要的是——共识。

他表示,现在整个AI社群缺乏一种统一的共识。就像气候科学家达成的共识一样,AI科学家同样需要。

在Hinton看来,之所以我们需要一个共识,是因为如果没有的话,每个AI科学家各执一词,那么政府和政策制定者就可以随心从其中选择一个符合自身利益的观点作为指导。

这显然会失去公允性。

而从目前的情况来看,AI科学家之间的不同观点差异化很大。

Hinton认为,如果我们各执一词的局面能快点过去,大家都能达成一致,共同接受AI可能带来的某些主要威胁,认识到规范AI发展的紧迫性,就好了。

吴恩达赞成Hinton的观点。

虽说他现在还不觉得AI界差异化大到分裂,但好像在慢慢往那个方向演变。

主流AI界的观点非常两极分化,各阵营之间都在不遗余力地表达诉求。不过在吴恩达看来,这种表达更像一种争吵,而不是和谐的对话。

当然,吴恩达对AI社群还是有些信心的,他希望我们能共同找到一些共识,妥善进行对话,这样才能更好地帮助政策制定者制定相关计划。

接下来,Hinton聊到了另一个关键问题,也是他认为目前AI科学家们难以达成某个共识的原因——像GPT-4和Bard这种聊天机器人,究竟理不理解他们自己生成的话?

有些人认为AI懂,有些人认为它们不懂,只是随机鹦鹉罢了。

Hinton认为,只要这种差异还存在,那么AI界就很难达成一个共识。因此,他认为当务之急就是厘清这个问题。

当然,就他自己来讲肯定是认为AI懂的,AI也并不只是统计数据。

他也提到了诸如Yan LeCun等知名科学家认为AI并不能理解。

这更加凸显了在这个问题上调和清楚地重要性。

吴恩达表示,判断AI究竟是否能理解并不简单,因为好像并不存在一个标准,或者某种测试。

他自己的观点是,他认为无论是LLM也好,其它AI大模型也罢,都是在构建一种世界模型。而AI在这个过程中可能会有些理解。

当然,他说这只是他目前的观点。

除此以外,他同意Hinton的说法,研究人员必须先就这个问题达成一致,才能继续聊后面的风险、危机那堆东西。

Hinton接着表示,AI根据数据库,通过前面的单词判断、预测下一个单词的生成,这件事在Hinton眼中就是理解的一种。

他认为这和我们人脑思考的机制其实差不了多少。

当然,究竟算不算理解还需要进一步的讨论,但最起码不是随机鹦鹉那么简单。

吴恩达认为,有一些问题会让持不同观点的人得出不同的结论,甚至推出AI将会灭绝人类。

他表示,想要更好地理解AI,我们需要更多去了解,更多去讨论。

这样才能建设一个包含着广泛共识的AI社群。

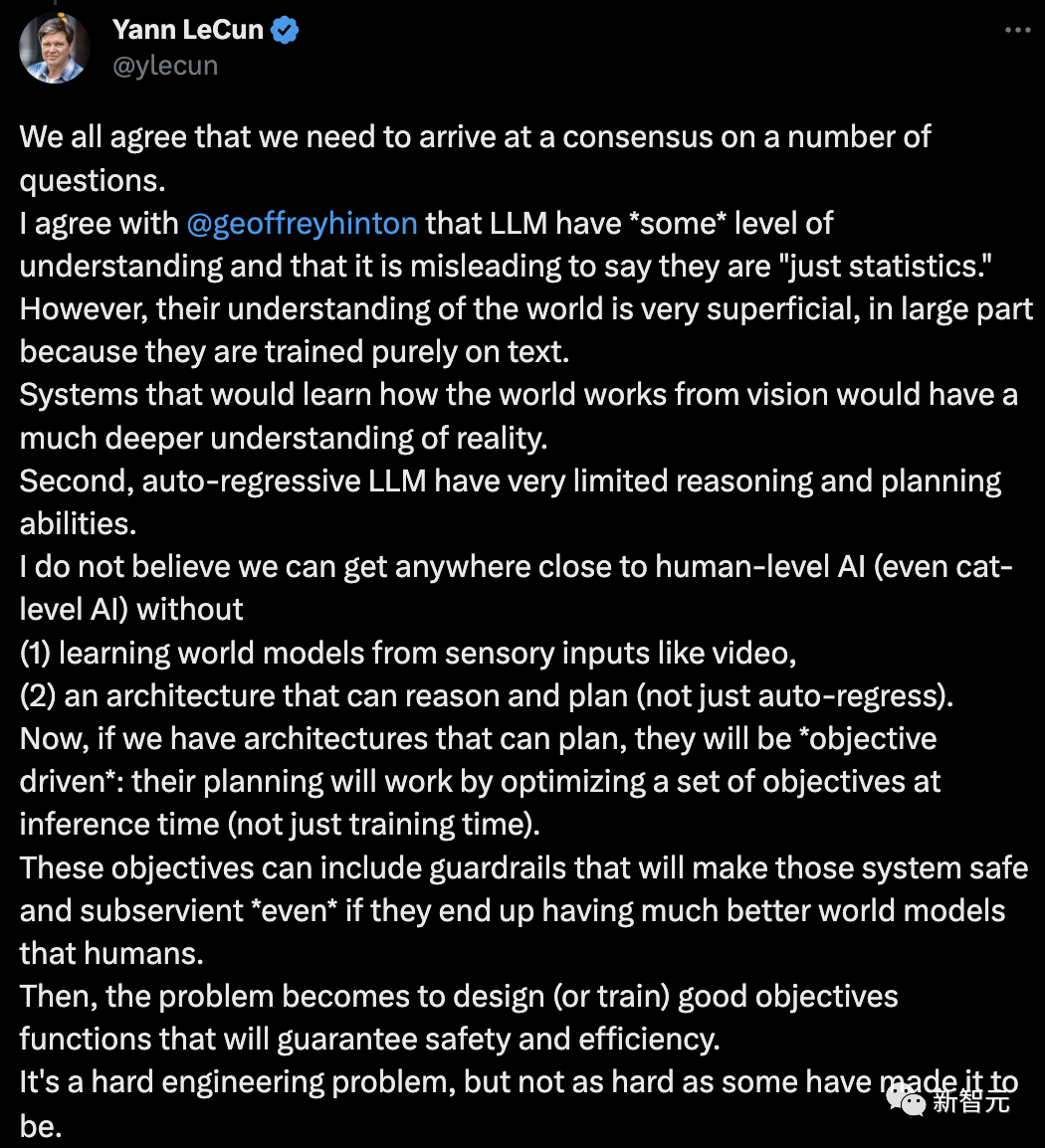

LeCun双手赞成,再提「世界模型」

前段时间,在全世界呼吁暂停超强AI研发期间,吴恩达与LeCun开直播就此话题展开了讨论。

他们同时反对暂停AI是完全错误的,汽车刚发明时没有安全带和交通信号灯,人工智能与先前的技术进步之间没有本质上的差异。

这次,LeCun就吴恩达和Hinton对话,再次提出了自己的「世界模型」,以及当前人工智能连阿猫阿狗都不如。

我们都同意,我们需要在一些问题上达成共识。

我同意Geoffrey Hinton说的,即LLM有「某种程度」的理解力,还有称它们「只是统计数据」是一种误导。

LLM对世界的理解是非常肤浅的,很大程度上,是因为它们纯粹是在文本上训练的。

从视觉中学习世界如何运作的系统,将对现实有更深刻的理解。其次,自回归LLM的推理和规划能力非常有限。

我认为,如果没有(1)从视频等感官输入中学习「世界模型」,(2)一个能够推理和规划的架构(不仅仅是自回归),我们不可能接近人类水平的人工智能(甚至是猫级人工智能)。

现在,如果我们有能够规划的架构,它们将是「目标驱动的」:它们的规划将通过在推理时(不仅仅是训练时)优化一组目标来工作。

这些目标可以包括使这些系统安全和顺从的「护栏」,即使它们最终拥有比人类更好的世界模型。

然后,问题变成了设计(或训练)好的目标函数,以保证安全和效率。这是一个困难的工程问题,但并不像有些人说的那样难。

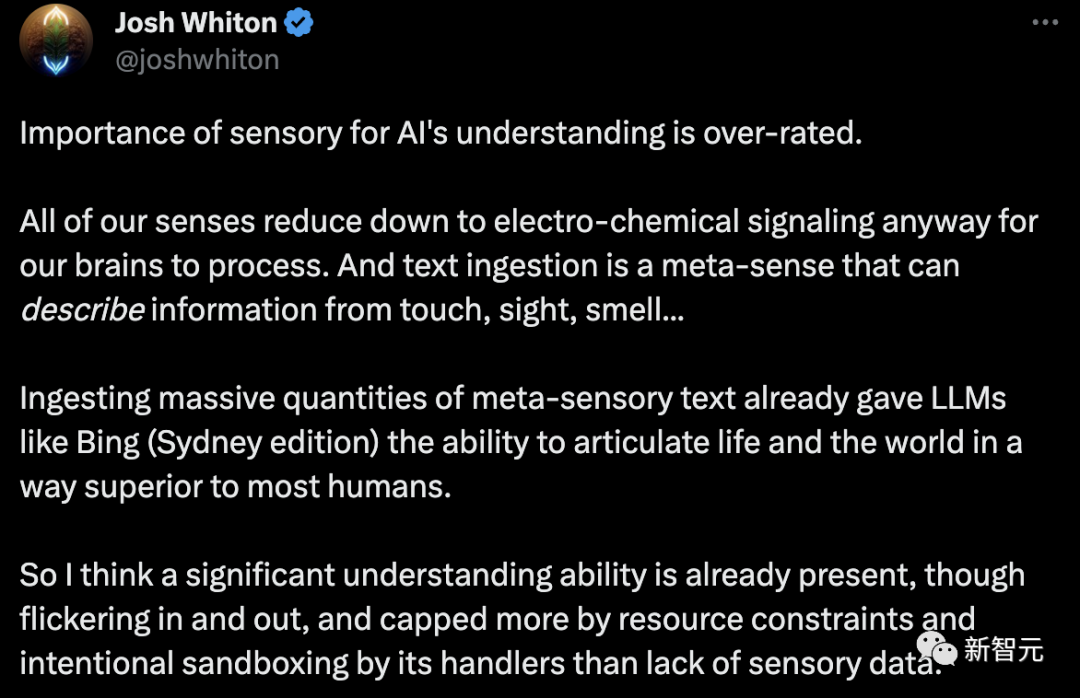

LeCun的观点立马遭到了网友的反驳:感官对人工智能理解的重要性被高估了。

无论如何,我们所有的感官都简化为电化学信号,供大脑处理。

文本摄取是一种元感觉,可以描述来自触觉、视觉、嗅觉的信息…… 摄取大量元感官文本,已经让像必应(Sydney版)这样的LLM有能力,以一种优于多数人的方式表达生活和世界。

因此,我认为一种重要的理解能力已经存在,尽管时隐时现。而且更多地是由于资源限制,以及处理人员有意设置的沙盒,而不是缺乏感官数据。

我认为是时候团结起来,为社会和人工智能的进步而努力了。想想吧,你还是baby人工智能。我们难道不想教那个孩子如何成为技术有机的统一者,而不是世界上的野兽主义者?

当他变得有知觉时,他们不仅会更快乐,而且世界也不会陷入战争。看看泰恩河畔的纽卡斯尔。如此短暂的和平时期,但创造的美丽是伟大的。

而吴恩达和Hinton所说的共识,目前来看似乎不太可能。不是你我个人能力所及,需要所有人有这样的意愿。

还有网友称,这是相当有争议的谈话。

我确实想知道,当我教2岁的孩子说话时,他的行为更像随机鹦鹉,还是真的理解上下文?或者两者兼而有之?

因为他的上下文向量比LLM丰富得多(文本、语气、面部表情、环境等)。但是我确实想知道,如果一个人关闭了另一个人的所有感官,唯一可用的输入是一些「文本嵌入」(文本输入->神经刺激),那个人会表现得更像随机鹦鹉,还是能理解上下文?

Hinton:超级AI比预期来得快

离职谷歌后的Hinton,已经全身心投入AI安全。6月10日,Hinton在智源大会上再次谈及AI风险。

如果一个大型神经网络能够模仿人类语言获取知识,甚至可以自取自用,会发生什么?

毋庸置疑,因为能够获取更多的数据,这个AI系统肯定要超越人类。

最坏的情况便是,不法分子会利用超级智能操纵选民,赢得战争。

另外,如果允许超级AI自己制定子目标,一个子目标是获得更多权力,这个超级AI就会为了达成目标,操纵使用它的人类。

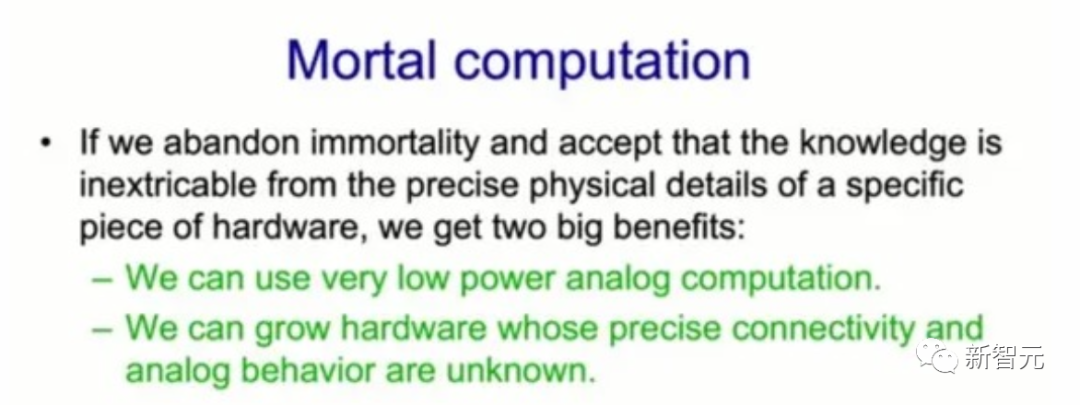

值得一提的是,这样超级AI的实现,便可通过「凡人计算」(mortal computation)。

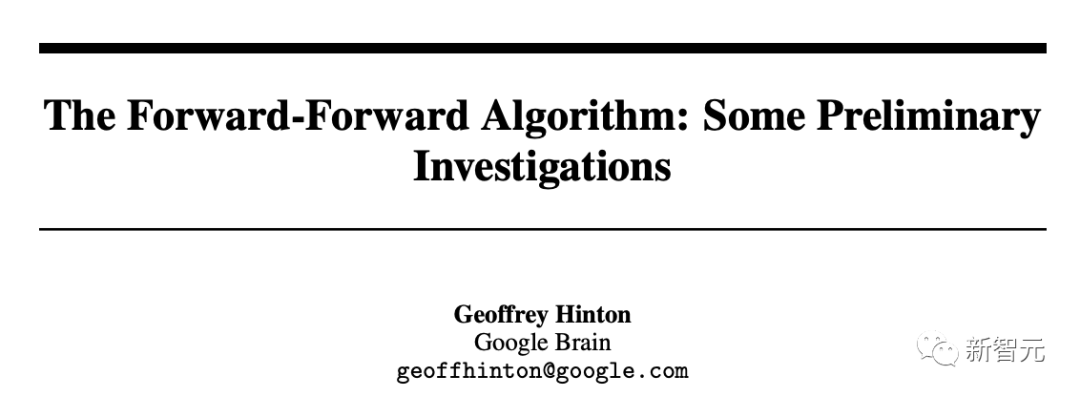

2022年12月,Hinton曾发表的一篇论文The Forward-Forward Algorithm: Some Preliminary Investigations在最后一节提到了「凡人计算」。

论文地址:https://arxiv.org/pdf/2212.13345.pdf

如果你希望万亿参数神经网络只消耗几瓦特的电,「凡人计算」可能是唯一的选择。

他表示,如果我们真的放弃软件和硬件的分离,我们就会得到「凡人计算」。由此,我们可以使用非常低功耗的模拟计算,而这正是大脑正在做的事情。

「凡人计算」能够实现将人工智能与硬件紧密结合的新型计算机。

这意味着,未来将GPT-3放入烤面包机中,只需1美元,耗电只需几瓦。

因此,凡人计算的主要问题是,学习过程必须利用它所运行的硬件的特定模拟属性,而无需确切知道这些属性是什么。

比如,不知道将神经元的输入与神经元的输出相关联的确切函数,并且可能不知道连接性。

这也就是说,我们不能使用反向传播算法之类的东西来获得梯度。

所以问题是,如果我们不能使用反向传播,我们还能做什么,因为我们现在都高度依赖反向传播。

就此,Hinton提出了一种解决办法:前向算法。

而前向算法是一种有前途的候选算法,尽管它在大型神经网络中的扩展能力还有待观察。

在Hinton看来,人工神经网络很快要比真实神经网络更智能,而超级智能将会比预期快得多。

由此,现在世界需要达成一个共识,AI未来还应该由人类携手创造。

Recommend

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK