MLPerf v2.0测试成绩发布,NVIDIA Jetson AGX Orin领跑边缘AI

source link: https://server.51cto.com/article/705946.html

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

在数字时代的今天,利用人工智能技术加速业务创新已经成为企业的共识。随着AI技术的突飞猛进,数据量的爆炸式增长,数据结构的变化,对数据中心的算力提出了新的要求,这也成为NVIDIA Ampere 架构一经发布,就得到业界广泛关注与认可的关键原因。

作为当前全球最具影响力的AI计算基准评测组织,MLPerf基准测试成为检测算力的重要参考依据。MLPerf由图灵奖得主大卫·帕特森(David Patterson)联合谷歌、斯坦福、哈佛大学等单位共同成立,每年组织全球AI训练和AI推理性能测试并发榜。目前,MLPerf的覆盖了计算机视觉、自然语言处理、推荐系统、强化学习等工作负载和场景。

为了提升边缘计算的能力,在今年的GTC上NVIDIA全新发布了NVIDIA Jetson AGX Orin,以此提升边缘AI算力。根据NVIDIA公布的数据,NVIDIA Jetson AGX Orin在最新一轮行业推理基准测试中取得了不错的成线,成为边缘AI的标杆产品。

用算力推动边缘创新

在今年的NVIDIA GTC上,NVIDIA正式发布了NVIDIA® Jetson AGX Orin™ 开发者套件。这款性能强大、尺寸紧凑、且节能的 AI 超级计算机适用于先进的机器人、自主机器以及新一代嵌入式和边缘计算。

根据NVIDIA公布的数据,Jetson AGX Orin 每秒可进行 275 万亿次运算,处理能力比上一代产品 Jetson AGX Xavier 高出 8 倍以上,同时仍保持了手掌大小的尺寸以及引脚兼容性,而且价格相近。

据了解,这款套件包含 NVIDIA Ampere 架构 GPU、 Arm Cortex-A78AE CPU、新一代深度学习和视觉加速器、高速接口、更快的内存带宽以及多模态传感器支持,可以为多个并发 AI 应用程序提供支持。

在首次参加行业MLPerf基准测试时, NVIDIA Orin就创造了新的AI推理性能纪录,并在边缘提升每个加速器的性能。在边缘AI领域,NVIDIA Orin预生产版本在六项性能测试中的五项处于领先地位,其运行速度比上一代Jetson AGX Xavier快了5倍,能效平均提高了2倍。

在最新的MLPerf 2.0导入多资料流(Multi Stream)测试项目,测量边缘运算设备在多摄影机、多传感器场景的性能表现。根据最新MLPerf 2.0性能测试,Jetson AGX Orin的性能最高可达前代Jetson AGX Xavier的5倍,同时提供平均2倍的电力效率。

NVIDIA人工智能推理和云计算高级产品经理Dave Salvator表示, NVIDIA Orin拥有出色的性能表现,将进一步加快行业打造新一代机器人和边缘 AI 产品的速度,并推动产业的创新步伐。

据了解,NVIDIA Orin现已加入到用于机器人和自动化系统的NVIDIA Jetson AGX Orin开发者套件。包括亚马逊网络服务、约翰迪尔、小松、美敦力和微软Azure在内的6000多家客户使用NVIDIA Jetson平台进行AI推理或其他任务。中国最大的电动汽车制造商比亚迪近期宣布,他们将在其新一代自动驾驶电动汽车中使用内置Orin的DRIVE Hyperion架构。

此外,Orin同样也是NVIDIA Clara Holoscan医疗设备平台的关键组成部分,且该平台可供系统制造商和研究人员用来开发新一代AI仪器。

Dave Salvator表示,凭借JetPack SDK,Orin可以运行整个NVIDIA AI平台,这个软件堆栈已经在数据中心和云端得到了验证,并且获得了NVIDIA Jetson平台100万名开发者的支持。

端到端 AI 和 HPC 数据中心平台

除了用于边缘计算的Orin之外,NVIDIA还为数据中心提供了基于安培架构的产品:NVIDIA A100 Tensor Core GPU。

NVIDIA A100 Tensor Core GPU主要针对 AI、数据分析和 HPC 应用场景,由 NVIDIA Ampere 架构提供支持,提供 40GB 和 80GB 两种配置。作为 NVIDIA 数据中心平台的引擎,A100 的性能比上一代产品提升高达 20 倍,并可划分为七个 GPU 实例,以根据变化的需求进行动态调整。A100 80GB 将 GPU 内存增加了一倍,提供超快速的内存带宽(每秒超过 2TB),可处理超大模型和非常庞大的数据集。

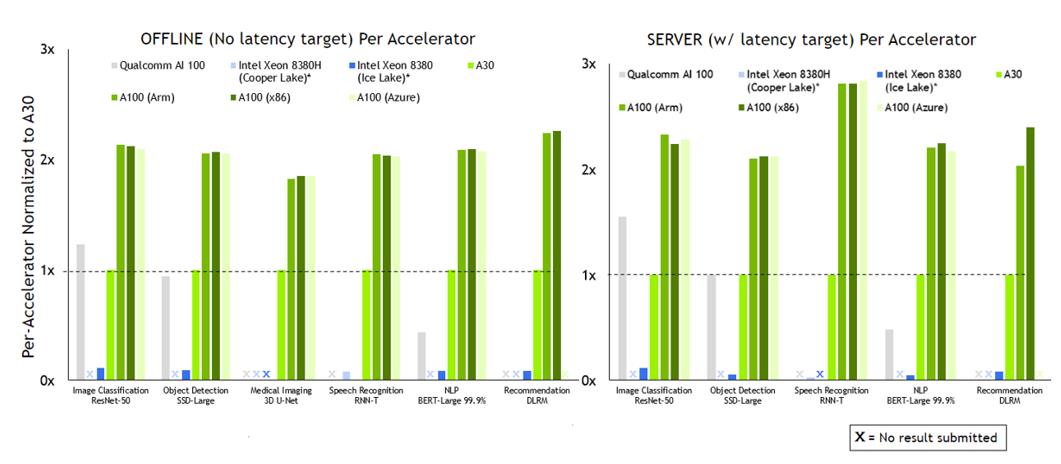

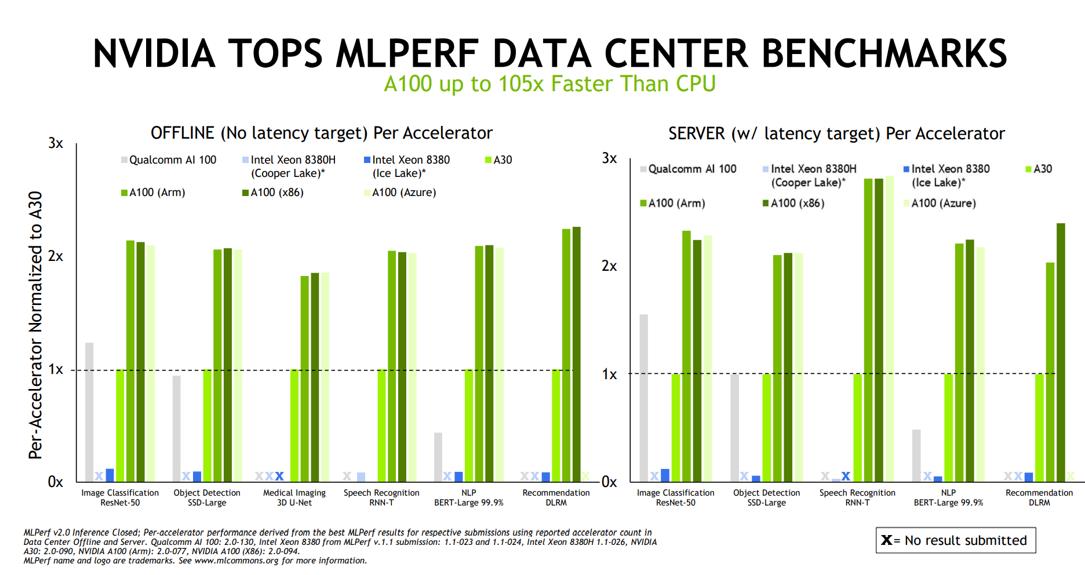

为了展示A100 GPU的性能,NVIDIA还通过数据表示现有的A100GPU的出色表现,在NVIDIA A100与 Qualcomm Cloud AI100 PCIe的对比测试中,各测试项目中A100的性能皆领先Cloud AI100 PCIe,尤其是在在特定项目中,NVIDIA A100甚至有105倍于处理器的AI运算性能。

目前来看,NVIDIA是唯一在所有MLPerf测试中都有提交成绩的公司,并通过测试成绩说明多执行实例GPU(Multi-Instance GPU,MIG)能在几乎不影响性能的前提下进行GPU的虚拟化,增加使用弹性。

Dave Salvator表示,通过这些测试成绩不难发现,全新的Jetson AGX Orin开发者工具包为边缘和机器人技术带来了新的人工智能功能,A100在1个GPU的情况之下提供了7个加速器,进一步简化部署和管理,同时优化利用和效用。

Dave Salvator强调,在Arm服务器下,NVIDIA的加速性能与x86不相上下,并在短短一年多的时间里,NVIDIA将人工智能软件的性能提高了50%,持续为人工智能提供全面的绩效领导力。

Recommend

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK