如何自动收集大批量现成的互联网业务

source link: https://zhuanlan.zhihu.com/p/245538524

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

如何自动收集大批量现成的互联网业务

在过往的从业生涯里,撇开创业初期的迷茫,在个人及团队走向成熟之后,我们就再也没有被"找项目"这个问题困扰过。

因为我们有各种不同角度的手段来挖掘、收集、统计、捕获存在于互联网各个角落的商机和业务。

对于我们来说,更重要的是项目的筛选,站在我们的角度比对,哪一个更有机会,哪一个更有潜能。

除去之前分享的几种方式以外,今天再分享另一个方式。

如果说之前挖掘的是需求,那今天这种方式挖掘的就是现成的业务。

本文首发于知乎作者“君言”个人的公众号"君言戏语",转载请前往联系授权。

信息挖掘是互联网营销生存的基本,而后就是信息筛选,今天涉及的主要是信息挖掘。

1:在百度搜索时,加入"intitle",搜索后的结果标题里必带完整关键词:

这个功能在近些年有些变化,比如变得智能一些,懂得匹配相关,偶尔会有一些没有完全包含的,不过不影响,大体上还是一样。

2:在百度搜索时,加入"inurl",搜索后的结果链接里必带完整字符:

这些结果点进去,一定都是知乎专栏的文章链接。

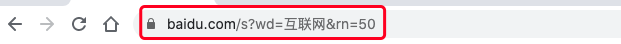

3:在百度搜索时,在搜索链接里加入"&rn=50",可以一次返回50个结果:

基于以上三点,这篇文章就是利用这个功能来挖掘"在网络上引流的那些人手上的业务"。

"私域流量"这个词是近两年比较火爆的,每个人都希望把流量装到自己的私有领域里,由自己支配,不受平台控制。

能被称为私域流量的地方并不多,基本是腾讯旗下产品一家独大:

微信、QQ、群、公众号、个人网站

除了纯粹倒买倒卖流量的,一般人不会把流量引到上诉之外的其他地方。

因此,每一个引流的人,无论做的是什么业务,在引流内容里,最终都要想尽各种办法留下自己"私域流量"的联系方式。

而为了向用户说明渠道,必须在留下联系方式时带上必要的前缀,比如:"加微"。

考虑到平台的屏蔽政策,又要绞尽脑汁的想出各种谐音字符,比如:"加威"、"+薇"。

而这些前缀,就是我们今天的关键字,我们要通过上诉的搜索引擎特殊命令,带上这些前缀批量的收集别人的现成业务。

步骤1:收集

结合上诉,我们可以想到的是:

"inurl"之后要跟的链接就是我们想收集的平台,这个平台我们选择了号称"全球最大中文社区"的百度贴吧。

这个称号有点虚,但算是有实无名。

在移动端,百度贴吧依然是集"社交"、"论坛"于一身的顶流头部APP,在PC端,作为百度亲儿子,贴吧占据着的百度搜索流量几乎是其他兄弟产品中的NO.1,随便搜索一个词,都有贴吧的身影。

另外,我们都很清楚,在百度贴吧引流,几乎是每一个互联网新手老手都干过的事情。

那么"inurl"怎么写?这个命令的意义是我们希望搜索出来的结果链接必须包含我们填写的这一段字符串,而我们搜索的,希望在标题中出现的关键词"加微",是希望在贴吧主贴的标题里的。

贴吧主贴的链接是:

https://tieba.baidu.com/p/000000000每一个帖子都是一样的格式,后面那串数字代表不同帖子。

因此"inurl"的值应该是:

tieba.baidu.com/p/这样在搜索时就可以只包含所有百度贴吧的主题帖子:

下面是我们搜索出来的结果:

五花八门,只有我们想不到的,没有别人没在做的。

当然了,不是所有业务都适合我们,不是所有业务都合适做,况且我们要的是现成,除了知道ta在做什么,还得知道怎么做,因此,有必要先把这些信息都收集回来做研究。

信息的收集很简单,不需要会技术,就用我之前分享的"web scraper"来收集,如果不会用,这是传送门,看里面的步骤1:

本次收集,对于每一个搜索结果,我们只要标题和标题对应的链接:

我们新建一个ws的项目工程(还不会ws的先在上面文章学一下,下面讲解一些操作步骤是有忽略的):

着重看一下三个红框的内容:

我们在百度搜索:intitle:"加微" inurl:http://tieba.baidu.com/p/

intitle:"加微" inurl:http://tieba.baidu.com/p/ 就是本次搜索的关键词。

搜索之后,在浏览器链接框(第一个红框)就会显示对应的百度链接,一般我们搜索后显示的链接是类似这样的:

密密麻麻的字符串,这是因为链接里包含了各种字段,每一个字段都有对应代表的信息,同时因为不是每个字段都是必须的,因此上面第一个红框的链接就是我保留了必须的字段,其他不必要的字直接去掉,这样就清晰很多。

链接字段是用"&"隔开的,除了第一个字段前面是"?",其他的字段前面都需要加上"&"表示隔开。

在上诉的搜索链接中:

字段"wd"等于的值就是我们搜索的关键词,会有一些"%"和数字,它们是浏览器转义后的显示,不用在意,"rn"就是上面说的返回50条结果的作用。

"pn"是百度的分页格式,pn=0,代表是第一页,pn=50,是代表第二页,以此类推每页递增50。

我们把这条链接复制到其他地方,就会变成下面这样:

https://www.baidu.com/s?wd=intitle%3A%22%E5%8A%A0%E5%BE%AE%22%20inurl%3Atieba.baidu.com%2Fp%2F&rn=50&pn=0"wd"后的关键词变成了一串乱码,这个是浏览器的URL编码,不用在意,明白就好,所以现在回过头来看上面这张图:

我们针对这次采集新建了一个工程项目,这个工程的配置是不会变的,因为都是采集百度结果页面,但是我们可能会采集不同的词,比如"加微"、"加威",词不同链接就要换,所以每次采集时是要更换这个"start URL"的。

当我们换成其他关键词时:

先在浏览器链接里把"加微"修改成"加威",然后直接回车就会搜索,搜索完之后,把浏览器上的链接复制到下面红框中即可,保存就可以进行新一轮收集。

当然了,复制下来后"pn"的值是要改的,不能直接等于0,百度的搜索结果最大只显示76页,我们这样的搜索(一页返回50条)最多只会显示10几页,因此每次搜索一个新词要先确认"pn"最大可以是多少:

每次5页、10页的点,等到没有更多了,看看上面浏览器链接里pn是多少,然后再按照刚才的链接格式填进"start URL",把pn设置成对应的数值。

现在我们设置一下抓取标题的"selector":

经过点选,标题已经筛选出来了,保存即可开始采集。

收集数据就到这里了,完全不需要技术,如果不明白,肯定是ws的基础理解还不够,回看之前的文章先学习。

你可能会奇怪,一页50条结果,十几页也才大几百条,数据量很少。

其实够了,我们每次都是把百度能返回来的最多结果都收集回来了,我们刚才说的前缀"加微",可以演变成各种形式,根据过往见过的,发挥我们的想象力,每一个词都可以抓几百上千,光这些收集成千上万是没问题的,够我们挖掘了。

这些词包括不限于:

加微、加威、加薇、加胃、加魏、+V、vx,以及各种组合。

另外我们只有搜索了微信,还有加群、加Q、关注公众号等等等等,光公众号就有各种变体,抖音和贴吧的公众号变体多了去了。

步骤2:整理

这是本次测试收集到的数据(2000+,需要对标题去重):

第一条就是"迪拜包机"业务,啧啧啧,这业务真大,由于对方是在引流,因此有必要说清ta能提供什么,所以每一条标题都是明明白白清清楚楚的业务信息。

那么怎么应用这份数据呢?

我们刚才提到,我们需要现成的业务,现在业务都在这份表,我们知道了他们在做什么,接下来要了解具体是怎么做的。

介于数据量太多,我们有必要优先筛选,选择的标准是:

"迪拜包机,需要的朋友详聊加微150*******6357【阿联酋吧】..."

这样一个标题,我们很清楚他是干嘛的,因为"迪拜"、"包机",已经明确说清楚了。

"看中加微188**********8【联通宽带吧】_百度贴吧"

这样一个标题,他并没有直接说明业务信息,需要点进去看。

因此我们显然优先了解直接从标题就可以看到业务信息的帖子,这两种标题的差别在于:没有明确业务信息的标题,标题里都是一些通用词,比如:加微、联系、进、找我

这些通用词在各种标题里都会出现,但是一个标题里如果仅只有这些词,那就是没有明确信息的标题。

PS:以下操作需要用到Python,不会的朋友可以先看,后续我会慢慢更新一些需要用到的Python小工具。

因此我们先把所有标题分词并统计词频,这些通用词因为很多标题都会有,很容易就可以把他们统计挑选出来:

如上,在这些高频词汇里,诸如:百度、加微、需要、欢迎、交流、联系等等,他们对我们了解业务信息是没有帮助的。

这些词里,我们看一眼,觉得是通用的,对我们了解信息没有帮助的,都可以挑选出来,放到一个库里,假设叫:无效词库,把每个标题分词,分词过程中把每个词根拿去无效词库里比对,有就去掉,没有就保留,最终没有明显业务信息的标题就会返回空的,有业务信息的标题就会返回关键信息,然后把他们一一对应:

如上图,第一列标题就是我们收集回来的,第二列是我们去除掉标题里的贴吧名称字段,第三列就是我们把第二列拿去分词并去除无效词之后得到的。

从中可以看到,诸如:

红框中的两列标题都没有关键信息,都是一些通用词,光凭标题看不出什么,所以经过计算,它会返回空,这样的目标我们以后再研究。

现在我们筛选去掉第三列(词根)为空的:

最后就是我们需要优先了解的数据了:

主要看"key"这一列,已经足够一目了然了,如果关键词是我们感兴趣的,直接点击右边对应的百度快照链接,就会进入原帖页面:

上面是一位帮别人推荐配置的朋友,在低预算情况下玩游戏,引流到闲鱼或微信都有。

当我们对某个业务有兴趣怎么办?直接加微信,加完直接问,或者观察朋友圈一周左右,他的业务我们基本就明白了。

如果我们对他的业务有兴趣,想要估算一下他大概能赚多少钱,大致逻辑可以根据我在知乎专栏的第二篇文章的步骤5,这是传送门:

了解完这些还是对业务有兴趣,那接下来就要知道他如何引流,这个业务要做的话基本门槛是什么?

首先是门槛,需要多少钱,要准备什么工具,要准备什么资源,要花多少时间经营,要多少个人,具体项目情况不一样,只能根据个人常识经验判断。

其次是如何引流,这太简单了,把他的联系方式拿到搜索引擎里搜索:

任何可以搜索的地方都可以搜索看看,只要他在互联网留下痕迹,大部分都能找得到。

当然,有些引流渠道其实我们也能想到,这样找不单单是看渠道,更重要的意义在于确认是否可以安全引流。

比如有些人就在贴吧引流,我们搜索下去全部都是贴吧的,但即使是这样也有价值,一个贴吧能被很多人发广告,说明要嘛贴吧没有多少人关注,要嘛没有管理员,他可以引流我们也可以。

可不要以为没人关注就没有引流价值,在贴吧引流也不一定都是为了给贴吧内的用户看,不要忘了还有搜索,只要我们的帖子能不被删,就有机会被搜索到。

有些人就专门找这样的吧,很多贴吧都是完全没听过的:

像这种,贴吧没几个人关注,发一个长尾词布局的标题,帖子内容开头写明看头像,名称设置成微信号,内容跟标题完全没有关系。

但是我们一搜索他的微信号(一些不太好的字眼抹掉了):

说到这一点,我们刚才收集的原标题,里面有很多包含贴吧名称的:

除了标题本身太长,要不然都会有包含贴吧名称,我们按照格式提取出来(Excel、Python都可以),这里面经常出现的贴吧,就是比较好发帖的贴吧,很可能是长期没人管的。

有些人专门一个帖子布局一个搜索量极低的长尾词,几乎没人跟他竞争,然后发到不会被删的贴吧里,日积月累,生产了这个领域里大部分长尾需求的帖子内容,到这时,在这个小众领域里他几乎是霸屏的状态,我们随便一搜都有他的身影。

1:结合微信、QQ、群、公众号、扫码等核心字眼,发挥想象力,尽可能想出更多的词汇来搜索,能想到越多,能找到的信息就比别人更多,信息差就是这么出来的。

2:我们演示是贴吧,除了贴吧,百度知道、豆瓣、简书之类的等等都可以收集。

3:如"词文本向量分类"里介绍的,这是一种广泛的挖掘方式,如果你已经限定了一个领域,可以结合领域核心词来挖掘:

这个时候,你能挖掘的范围就是无穷无尽的。

4:搜索引擎是可以自定义时间范围的,如果你在乎时效性:

当然这样搜索下去内容会相对少很多。

Recommend

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK