Sam Altman 的芯片计划,7 万亿美元融资是最容易的部分

source link: https://www.geekpark.net/news/331367

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

Sam Altman 的芯片计划,7 万亿美元融资是最容易的部分

不计成本树立大模型典范,OpenAI 提前看到的未来是什么?

周一在迪拜举行的世界政府峰会上,当被问及「7 万亿美元可以购买多少个 GPU」时,黄仁勋打趣道:「显然是所有的 GPU」。

在这之前,Sam Altman 被爆出正在筹集高达 7 万亿美元的资金,以增加全球半导体芯片的供应。看上去,OpenAI 距离 AGI(通用人工智能)只差 AI 算力了。

但就像《华尔街日报》一篇报道的标题,筹集数万亿美元可能是 Altman 芯片计划里最容易的部分。

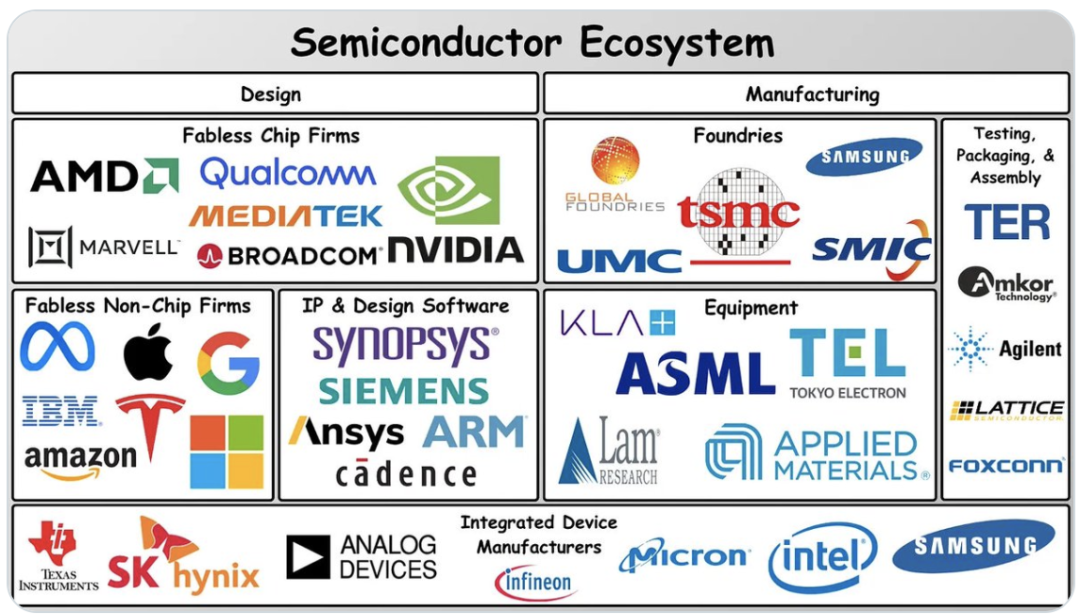

毋庸置疑,芯片制造是比金钱复杂得多的挑战,作为资本密集型产业,历来经历过剧烈的周期性波动,芯片制造厂对激进扩张也持谨慎态度。目前,世界上只有三家公司能够大批量生产最尖端的芯片:台积电、三星电子和英特尔。

Sam Altman 到底看到了什么,决定如此重押算力?

如果把大模型厂商划分为两种,一种是在落地场景中探索大模型。其中的「显眼包」代表包括英伟达、微软、Databricks,三者都强调算力瓶颈会随着模型尺寸变小、下一代芯片架构创新等取得突破来进一步破除,就像互联网带宽限制在 2000 年基本消失一样,「GPU 也会发生同样的情况」。

另一种大模型厂商的典型代表则是 OpenAI,对于大模型技术,要不计成本地做标本、数典范、探索边界。对于 OpenAI 率先看到的未来,Q*、GPT-5 的消息让外界对 Transformer 能否实现 AGI 充满想象。这可能也是 Sam Altman 芯片制造野心的起点。

据报道,除了投资方,Altman 还与芯片制造商比如台积电进行了讨论,讨论与他们合作并使用数万亿美元建设和运营新工厂,以及对能源和其他人工智能基础设施的投资。

建设一家尖端芯片工厂通常至少需要 100 亿美元,相比之下,Altman 所讨论的 7 万亿美元规模是极端的。对于 Sam 的 7 万亿美元,黄仁勋预判,到 2029 年全球建设人工智能数据中心的成本将达到 2 万亿美元,他表示,「你不能假设你会购买更多电脑,你还必须假设计算机会变得更快,因此你需要的总量不会那么多。」

在 OpenAI 内部,Sam Altman 看到了什么?

对于这个问题,The information 跟踪 AI 和云计算的两位记者在《The Most Exciting Thing About Altman's Chip Dream》一文作出探讨,由极客公园编译整理:

01 OpenAI 唯一的障碍,算力短缺?

上周,OpenAI 首席执行官 Sam Altman 抢尽风头。他正试图筹集数万亿美元的资金来开发和制造 AI 芯片。尽管这一数字多少有点骇人听闻,但姑且先把集体怀疑放在一边,尝试理解 Altman 融资的意义——无限的计算能力将导致全能的人工智能。

图片社交媒体 X 平台,网友总结 7 万亿美元的购买力|来源:twitter.com

换句话说,他认为唯一阻碍超级人工智能的是服务器短缺,而实现超级人工智能,甚至可以帮助我们移民火星或解决全球变暖问题。

Altman 并不是唯一持这种观点的人,但这远非共识。

四年前,OpenAI 发表了一篇关于大型语言模型领域的「缩放定律」(Scaling Law)的论文。「缩放定律」表明,对大语言模型进行更多计算能力和数据方面的训练,可以提高其预测下一个单词的准确性,从而提高大模型的能力。在这个信念下,OpenAI 等大模型厂商花了 1 亿多美元来训练一个模型。

然而,更多 AI 从业者认为,在今天的 AI 模型上投入更多芯片和数据并不是实现超级人工智能的途径。当我们用完高质量的、人类生成的数据来训练 AI 模型时,基于相对较少的数据,开发出能够像人类一样学习和推理的软件可能会更容易。毕竟,OpenAI 的 GPT-4 和谷歌的 Gemini 已经接受了世界上大多数公共文本信息的训练,它们还没有达到超级人工智能的水平。

利用「缩放定律」训练大模型还隐含着一个副作用:强行使用更大、更耗电的模型可能会对环境产生灾难性的影响,因为服务器和数据中心的电力消耗会产生温室气体。

Altman 本人也承认,开发前沿大模型可能需要在能源方面取得重大突破。数据中心公司的管理者也已经开始担心,今年所有以人工智能为重点的新数据中心,是否有足够的电力供应。

02 OpenAI 必须保持算力领先

目前,我们只能假设 Altman 和他聪明的同事们知道一些我们不知道的大模型「缩放定律」。

显然,他们相信,有了更多的服务器,他们可以利用现有的人工智能和最近的技术突破,比如 Q*——一个可以推理以前没有训练过的数学问题的模型——来创建正确的「合成」(非人类生成的) 数据。当用完人类生成的数据后,合成数据可以接着被用来训练更好的模型。

或者,这些模型可以找出现有模型 (如 GPT-4) 的缺陷,并提出技术改进建议——换句话说,就是自我改进的人工智能。(此前,谷歌资深工程师卢一峰独家向极客公园解读了 OpenAI Q*可能代表的技术路径。)

Altman 已经明确表示,他的团队根本没有从其独家服务器供应商——微软那里获得足够的计算能力来发挥其潜力。私下里,他曾表示,明年谷歌将拥有比 OpenAI 更强大的计算能力来开发人工智能。这在某种程度上可以理解他想改变现状的紧迫性。

被爆出 7 万亿美元筹资建芯片时,Altman 在 X 社交平台发表观点|来源:twitter.com

Altman 到底需要多少钱才能到达计算的「应许之地」?据报道,他与阿拉伯联合酋长国盛产石油的酋长们提出了 7 万亿美元的数字,他希望这些酋长能资助新的芯片和服务器。

一位头部 AI 芯片厂商的 CEO 称,建造数据中心、发电厂和芯片代工厂,以产生 10 倍于微软现有计算能力的计算能力,将耗资 1000 亿至 2000 亿美元。

这位 CEO 和该领域的其他人士表示,由于劳动力和供应链的限制,资金在加速芯片制造厂、数据中心和发电厂的建设方面所能做的只有这么多。就连英伟达 CEO 黄仁勋也对 7 万亿美元的数字表示怀疑。

如果 Altman 的计划包括 OpenAI 开发自己的服务器芯片,那将需要数年时间,而且不能保证成功。

这就提出了一个问题,为什么他首先要寻找数万亿美元?

如果 Altman 与英特尔、AMD、阿联酋和一长串其他公司达成一笔大交易,打造新的人工智能芯片,这将很容易成为这十年来最重要的技术努力之一。但即使什么都没发生,Altman 不得不在更小的算力规模上,测试他对自我改进的人工智能假设,这也足以让人感到兴奋。

Recommend

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK