一文搞懂使用 Arthur Bench 进行 LLM 评估

source link: https://www.51cto.com/article/781102.html

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

一文搞懂使用 Arthur Bench 进行 LLM 评估

Hello folks,我是 Luga,今天我们来聊一下人工智能(AI)生态领域相关的技术 - LLM 评估 。

一、传统文本评估面临的挑战

近年来,随着大型语言模型(LLM)的快速发展和改进,传统的文本评估方法在某些方面可能已经不再适用。在文本评估领域,我们可能已经听说过一些方法,例如基于“单词出现”的评估方法,比如 BLEU,以及基于“预训练的自然语言处理模型”的评估方法,比如 BERTScore。

尽管这些方法在过去一直非常出色,但随着 LLM 的生态技术的不断发展,它们显得有点力不从心,无法完全满足当前的需求。

随着 LLM 的快速发展和改进,我们正在面对新的挑战和机遇。LLM 的能力和表现水平不断提高,这使得基于单词出现的评估方法(如 BLEU)可能无法完全捕捉到 LLM 生成文本的质量和语义准确性。LLM 能够生成更加流畅、连贯且语义丰富的文本,而传统的基于单词出现的评估方法则无法准确衡量这些方面的优势。

此外,基于预训练模型的评估方法(如 BERTScore)也面临一些挑战。尽管预训练模型在许多任务上表现出色,但它们可能无法充分考虑到 LLM 的独特特征以及其在特定任务上的表现。LLM 在处理特定任务时可能会展现出与预训练模型不同的行为和性能,因此仅仅依赖基于预训练模型的评估方法可能无法全面评估 LLM 的能力。

二、为什么需要 LLM 指导评估?以及带来的挑战 ?

通常来讲,在实际的业务场景中,采用 LLM 指导评估这种方法最为价值的地方主要在于“速度”和“灵敏度”。

首先,通常来说,实施速度更快。相比于以前的评估管道所需的工作量,创建 LLM 指导评估的首次实施相对较快且容易。对于 LLM 指导的评估,我们只需要准备两件事情:用文字描述评估标准,并提供一些在提示模板中使用的示例。相对于构建自己的预训练 NLP 模型(或微调现有的 NLP 模型)以用作评估器所需的工作量和数据收集量,使用 LLM 来完成这些任务更为高效。使用 LLM,评估标准的迭代速度要快得多。

2、敏感性

其次,LLM 通常更加敏感。这种敏感性可能带来积极的方面,与预训练的 NLP 模型和之前讨论的评估方法相比,LLM 更能灵活地处理这些情况。然而,这种敏感性也可能导致 LLM 的评估结果变得非常不可预测。

正如我们之前讨论的那样,与其他评估方法相比,LLM 评估者更加敏感。将 LLM 作为评估器有许多不同的配置方法,根据所选择的配置,其行为可能会有很大的差异。同时,另一个挑战在于,如果评估涉及太多的推理步骤或需要同时处理太多的变量,LLM 评估者可能会陷入困境。

由于 LLM 的特性,其评估结果可能会受到不同配置和参数设置的影响。这意味着对 LLM 进行评估时,需要仔细选择和配置模型,以确保其行为符合预期。不同的配置可能导致不同的输出结果,因此评估者需要花费一定的时间和精力来调整和优化 LLM 的设置,以获得准确和可靠的评估结果。

此外,当面对需要进行复杂推理或同时处理多个变量的评估任务时,评估者可能会面临一些挑战。这是因为 LLM 的推理能力在处理复杂情境时可能受限。LLM 可能需要进行更多的努力来解决这些任务,以确保评估的准确性和可靠性。

三、什么是 Arthur Bench ?

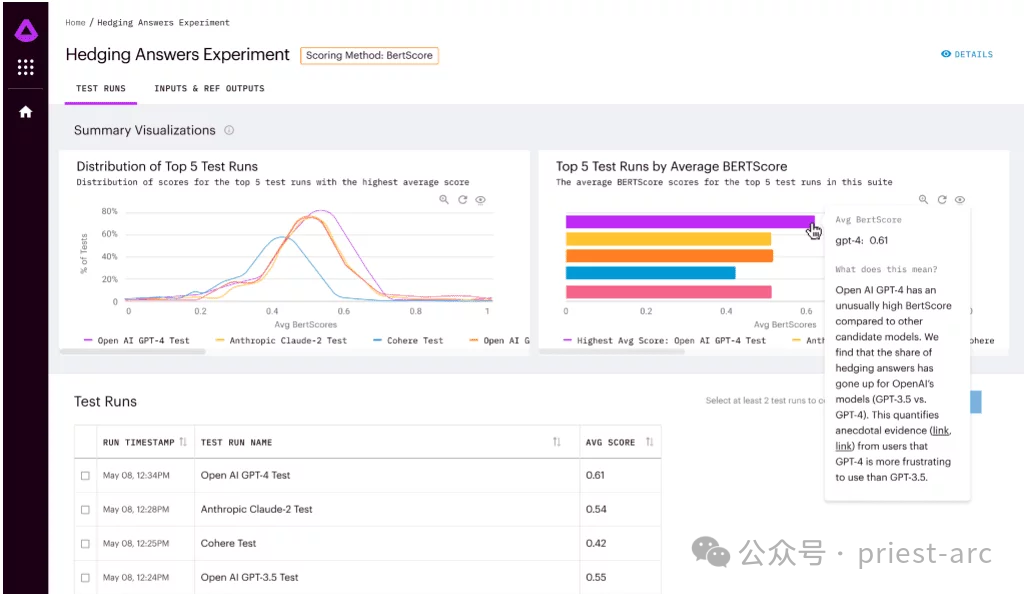

Arthur Bench 是一个开源的评估工具,用于比较生成文本模型 (LLM) 的性能。它可以用于评估不同 LLM 模型、提示和超参数,并提供有关 LLM 在各种任务上的性能的详细报告。

Arthur Bench 的主要功能包括:Arthur Bench 的主要功能包括:

- 比较不同 LLM 模型:Arthur Bench 可以用于比较不同 LLM 模型的性能,包括来自不同供应商的模型、不同版本的模型以及使用不同训练数据集的模型。

- 评估提示:Arthur Bench 可以用于评估不同提示对 LLM 性能的影响。提示是用于指导 LLM 生成文本的指令。

- 测试超参数:Arthur Bench 可以用于测试不同超参数对 LLM 性能的影响。超参数是控制 LLM 行为的设置。

通常而言,Arthur Bench 工作流程主要涉及如下阶段,具体詳細解析如下所示:

1. 任务定义

在此阶段,我们需要明确我们的评估目标,Arthur Bench 支持多种评估任务,包括:

- 问答:测试 LLM 对开放式、挑战性或多义性问题的理解和回答能力。

- 摘要:评估 LLM 提取文本关键信息并生成简洁摘要的能力。

- 翻译:考察 LLM 在不同语言之间进行准确、流畅翻译的能力。

- 代码生成:测试 LLM 根据自然语言描述生成代码的能力。

2. 模型选择

在此阶段,主要工作为筛选评估对象。Arthur Bench 支持多种 LLM 模型,涵盖来自 OpenAI、Google AI、Microsoft 等知名机构的领先技术,如 GPT-3、LaMDA、Megatron-Turing NLG 等。我们可以根据研究需求选择特定模型进行评估。

3. 参数配置

完成模型选择后,接下来进行精细化调控工作。为了更精准地评估 LLM 性能,Arthur Bench 允许用户配置提示和超参数。

- 提示:指引 LLM 生成文本的方向和内容,例如问题、描述或指令。

- 超参数:控制 LLM 行为的关键设置,例如学习率、训练步数、模型架构等。

通过精细化配置,我们可以深入探索 LLM 在不同参数设置下的表现差异,获得更具参考价值的评估结果。

4. 评估运行:自动化流程

最后一步,即借助自动化流程进行任务评估。通常情况下,Arthur Bench 提供自动化评估流程,只需简单配置即可运行评估任务。它将自动执行以下步骤:

- 调用 LLM 模型并生成文本输出。

- 针对特定任务,应用相应的评估指标进行分析。

- 生成详细报告,呈现评估结果。

四、Arthur Bench 使用场景分析

作为一种快速、数据驱动的 LLM 评估的关键,Arthur Bench 主要提供如下解决方案,具体涉及:

1、模型选择和验证

模型选择和验证是人工智能领域中至关重要的关键步骤,对于确保模型的有效性和可靠性具有重要意义。在这个过程中,Arthur Bench 的角色非常关键。他的目标是为公司提供一个可靠的比较框架,通过使用一致的指标和评估方法,帮助他们在众多大型语言模型(LLM)选项中做出明智的决策。

Arthur Bench 将运用他的专业知识和经验来评估每个 LLM 选项,并确保使用一致的指标来比较它们的优势和劣势。他将综合考虑诸如模型性能、准确性、速度、资源需求等因素,以确保公司能够做出明智而明确的选择。

通过使用一致的指标和评估方法,Arthur Bench 将为公司提供一个可靠的比较框架,使他们能够全面评估每个 LLM 选项的优点和局限性。这将使公司能够做出明智的决策,以最大程度地利用人工智能领域的快速发展,并确保他们的应用程序能够获得最佳的体验效果。

2、预算和隐私优化

在选择人工智能模型时,并非所有应用程序都需要最先进或最昂贵的大型语言模型(LLM)。在某些情况下,使用成本更低的人工智能模型也可以满足任务需求。

这种预算优化的方法可以帮助公司在有限的资源下做出明智的选择。而不必追求最昂贵或最先进的模型,而是根据具体需求选择合适的模型。较为经济实惠的模型可能在某些方面的性能略低于最先进的 LLM,但对于一些简单或标准的任务来说,Arthur Bench 仍然能够提供满足需求的解决方案。

此外,Arthur Bench 强调将模型引入内部可以更好地控制数据隐私。对于涉及敏感数据或隐私问题的应用程序,公司可能更倾向于使用自己内部训练的模型,而不是依赖外部的第三方LLM。通过使用内部模型,公司可以更好地掌握数据的处理和存储,更好地保护数据隐私。

3、将学术基准转化为现实世界的表现

学术基准是指在学术研究中建立的模型评估指标和方法。这些指标和方法通常是针对特定任务或领域的,能够有效评估模型在该任务或领域的性能。

然而,学术基准并不总是能够直接反映模型在现实世界中的表现。这是因为现实世界中的应用场景往往更加复杂,需要考虑更多因素,例如数据分布、模型部署环境等。

Arthur Bench 可以帮助将学术基准转化为现实世界的表现。 它通过以下方式实现这一目标:

- 提供一组全面的评估指标, 涵盖模型的准确性、效率、鲁棒性等多个方面。这些指标不仅能够反映模型在学术基准下的表现,也能反映模型在现实世界中的潜在表现。

- 支持多种模型类型, 能够对不同类型的模型进行比较。这使得企业能够选择最适合其应用场景的模型。

- 提供可视化分析工具, 帮助企业直观地了解不同模型的表现差异。这使得企业能够更容易地做出决策。

五、Arthur Bench 特性分析

作为一种快速、数据驱动的 LLM 评估的关键,Arthur Bench 具有如下特性:

1、全套评分指标

Arthur Bench 拥有一整套评分指标,涵盖了从总结质量到用户体验的各个方面。他可以随时利用这些评分指标来对不同的模型进行评估和比较。这些评分指标的综合运用可以帮助他全面了解每个模型的优势和劣势。

这些评分指标的范围非常广泛,包括但不限于总结质量、准确性、流畅性、语法正确性、上下文理解能力、逻辑连贯性等。Arthur Bench 将根据这些指标对每个模型进行评估,并将结果整合为一个综合评分,以辅助公司做出明智的决策。

此外,如果公司有特定的需求或关注点,Arthur Bench 还可以根据公司的要求创建和添加自定义的评分指标。这样以便能够更好地满足公司的具体需求,并确保评估过程与公司的目标和标准相符合。

2、本地版本和基于云的版本

对于那些更喜欢本地部署和自主控制的用户,可以从 GitHub 存储库中获取访问权限,并将 Arthur Bench 部署到自己的本地环境中。这样,大家可以完全掌握和控制 Arthur Bench 的运行,并根据自己的需求进行定制和配置。

另一方面,对于那些更倾向于便捷和灵活性的用户,也提供了基于云的 SaaS 产品。大家可以选择注册,通过云端访问和使用 Arthur Bench。这种方式无需繁琐的本地安装和配置,而是能够立即享受到所提供的功能和服务。

3、完全开源

Arthur Bench 作为一个开源项目,在透明性、可扩展性和社区协作等方面展现出其典型的开源特点。这种开源性质为用户提供了丰富的优势和机会,使他们能够更深入地了解项目的工作原理,并根据自身需求进行定制和扩展。同时,Arthur Bench 的开放性还鼓励用户积极参与社区协作,与其他用户共同合作和发展。这种开放式的合作模式有助于推动项目的不断发展和创新,同时,也为用户创造了更大的价值和机遇。

总之,Arthur Bench 提供了一个开放且灵活的框架,使用户能够自定义评估指标,并且已经在金融领域得到广泛应用。与 Amazon Web Services 和 Cohere 的合作进一步推动了该框架的发展,鼓励开发人员为 Bench 创建新的指标,为语言模型评估领域的进步做出贡献。

Reference :

- [1] https://github.com/arthur-ai/bench

- [2] https://neurohive.io/en/news/arthur-bench-framework-for-evaluating-language-models/

Recommend

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK