十个2023年最流行的数据科学开源工具

source link: https://www.51cto.com/article/770156.html

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

数据科学已经渗透到各行各业,由于数据以指数级速度增长,数据科学家从数据中挖掘价值、进行分析的挑战越来越高。此时,必须使用相应的数据科学工具,挖掘、清洗、规整和可视化数据。

本文从众多的数据科学工具中整理了一组开源工具,因为开源工具拥有低成本、灵活性和高透明度的特点。

1. KNIME

【KNIME】:https://www.knime.com/

图片

KNIME是一款免费开源的工具,可进行数据分析、可视化和部署,几乎不需要编程。它具有以下特点:

- 基于图形用户界面的数据预处理和流水线操作,可使不同技术背景的用户轻松完成复杂任务。

- 和正在使用的管道和系统进行无缝集成。

- KNIME的模块化方法可使用户根据需求自定义工作流程。

2. Weka

【Weka】:https://www.weka.io/

图片

Weka是一款经典的开源工具,支持预处理数据、构建和测试机器学习模型,还行使用图形界面对数据进行可视化。尽管出现了很长时间,但由于其适应性强,能处理不同模型,因此仍然很流行。Weka支持多种语言,包括R、Python、Spark、scikit-learn等,使用非常方便和可靠。Weka的优势如下所示:

- Weka不仅适用于数据科学从业人员,还是优秀的机器学习教学平台。

- 大大提高创建数据管道的效率。

- 无需调整,即可支持高I/O、低延迟、小文件和混合任务,且性能强大。

3. Apache Spark

【Apache Spark】:https://spark.apache.org/

图片

Apache Spark是一个著名的数据科学工具,可提供实时数据分析,是广泛使用的可扩展计算引擎。此外,Spark还具有极快的数据处理能力。用户可以轻松连接到不同的数据源,不必担心数据存储的位置。Spark的缺点是它需要大量的内存。Spark的特点如下所示:

- 易于使用,提供了简单的编程模型,支持多种编程语言。

- 可以用统一的处理引擎处理任务。

- 一站式解决方案,可用于批处理、实时计算和机器学习。

4. RapidMiner

【RapidMiner】:https://rapidminer.com/

图片

RapidMiner功能强大,在完整数据科学周期的不同阶段,从数据建模和分析到数据部署和监控,都能派上用场。它提供了可视化的工作流程设计,消除了繁琐的编码需求。RapidMiner还可以从零开始构建自定义数据科学管道和算法。RapidMiner强大的数据预处理功能能协助用户清洗数据。RapidMiner的特点如下所示:

- 通过提供可视化和直观的界面简化数据科学流程。

- RapidMiner的连接器简化了使数据集成。

5. Neo4j Graph Data Science

【Neo4j Graph Data Science】:https://neo4j.com/product/graph-data-science/

图片

Neo4j Graph Data Science是一种解决方案,用于分析数据之间的复杂关系,发现隐藏的联系。它能识别数据点之间的相互关系。它由预配置的图形算法和自动化程序组成,能快速展示图形分析的价值。它在社交网络分析、推荐系统和其他关联关系重要的场景中特别有用。以下是它的一些额外优势:

- 通过65种丰富的图形算法改进预测。

- 使用30多个连接器和插件实现无缝集成数据生态。

- 支持快速部署。

6. ggplot2

【ggplot2】:https://ggplot2.tidyverse.org/

图片

ggplot2是R语言中一款出色的数据可视化软件包。它基于图形语法构建,并提供自定义的创作空间。即使是默认的配色方案效果也很好。ggplot2利用不同方法为可视化添加细节。虽然它具有强大的数据可视化能力,但处理复杂图形可能要用到繁琐的语法,需要注意。ggplot2的特点如下:

- 将图形保存为对象,从而不需要重复大量代码就可以创建不同版本的图形。

- ggplot2提供了统一的解决方案,而无需在多个平台之间切换。

- 提供丰富的资源和文档,可帮助你入门。

7. D3.js

【D3.js】:https://d3js.org/

图片

D3是数据驱动文档(Data-Driven Documents)的简称。它是一个功能强大的开源JavaScript库,通过DOM操作技术能够创建令人惊叹的可视化效果。它创建的可交互式可视化能够对数据的变化做出响应。然而,对于不熟悉JavaScript的用户,D3.js不容易上手。D3.js的特点如下所示:

- 提供丰富的模块和API,可定制程度高。

- 足够轻巧,不会影响Web应用程序的性能。

- 符合当前的Web标准,并且可以轻松与其他库集成。

8. Metabase

【Metabase】:https://www.metabase.com/

图片

Metabase是一个拖放式的数据探索工具,适用于专业用户和普通用户。它简化了分析和可视化数据的过程。Metabase直观的界面使用户能创建交互式面板、报告和可视化效果。它在企业中越来越受欢迎。它还提供了其他一些优势,包括:

- 用简单语言查询替代复杂的SQL查询。

- 支持协作。

- 支持超过20种数据源,使用户能够连接到数据库、电子表格和API。

9. Great Expectations

【Great Expectations】:https://greatexpectations.io/

图片

Great Expectations是一款数据质量工具,使你能够对数据进行检查并高效监控任何违规行为。通过为数据定义一些期望或规则,然后根据这些规则监控数据。它还提供数据分析工具,加速数据发现过程。Great Expectations的主要优势如下:

- 为数据生成详细的文档。

- 与不同的数据管道和工作流无缝集成。

- 支持自动化测试,以便在流程的早期检测到问题或偏差。

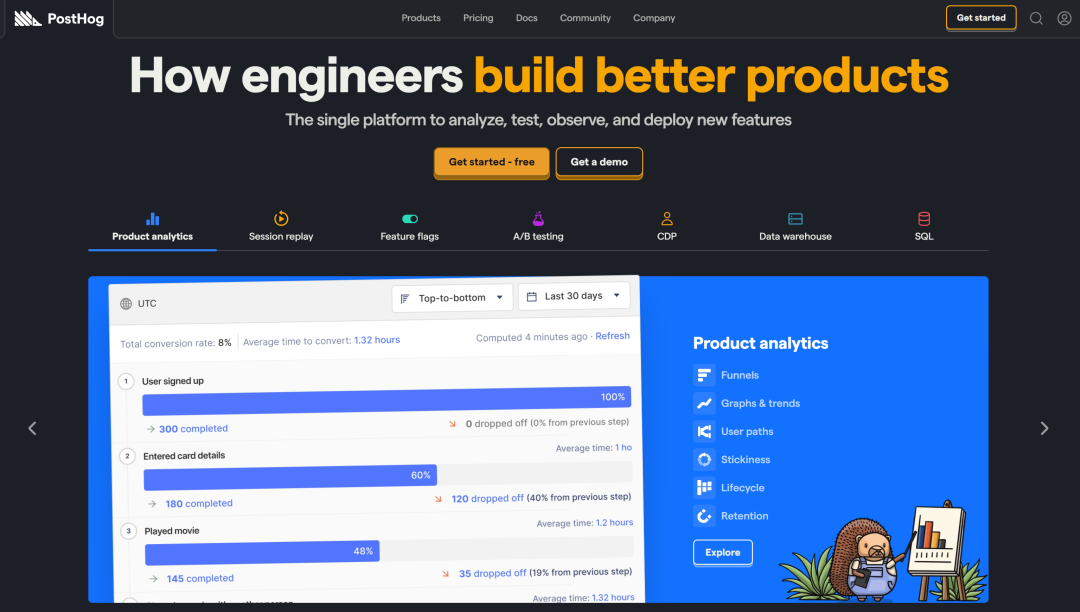

10. PostHog

【PostHog】:https://posthog.com/

图片

PostHog是一款产品分析领域的开源工具,使企业能够跟踪用户行为以提升产品体验。使用PostHog,数据科学家和工程师无需编写SQL查询,就能够快速获取数据。它包含数据面板、趋势分析、漏斗分析、会话记录等功能。以下是PostHog的关键特点:

- 通过A/B测试功提供实验平台。

- 支持与数据仓库无缝集成,用于导入和导出数据。

- 通过采集会话、控制台日志和网络监控,提供对用户与产品交互情况的深入理解。

Recommend

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK