从观察、思考到行动,深度强化学习大牛Pieter Abbeel谈如何驯服机器人

source link: https://www.51cto.com/article/768538.html

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

从观察、思考到行动,深度强化学习大牛Pieter Abbeel谈如何驯服机器人

人类的大脑具有学习新事物的能力,而且学习方式多种多样,从模仿他人到观看在线解说视频,不一而足。如果机器人也能这样做呢?2021 年 ACM 计算奖获得者 Pieter Abbeel 的职业生涯一直在研究这个问题。

Pieter Abbeel 是 Covariant 的创始人之一。Covariant 是一家人工智能机器人公司,致力于构建一个通用的人工智能,使机器人能够在现实世界中学习和操作,以协助人类完成繁重和劳累的任务,尤其是在仓储和物流行业中。

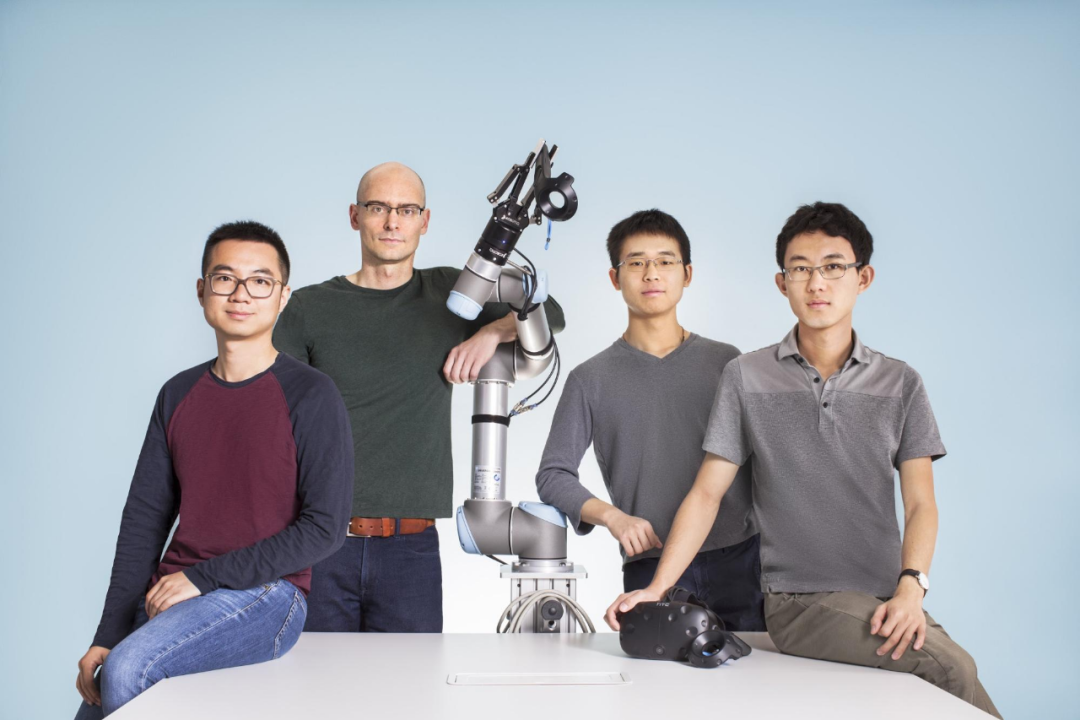

Covariant 的创始人陈曦、Pieter Abbeel、段岩、张天浩(从左到右)

通过与仓储公司的合作,Covariant 的核心技术「Covariant Brain」能够接触到大量现实生活中物体,从数百万次的拾取任务中学习。Covariant Brain 能够使机器人看、思考并行动。在学习过程中不仅学习既有动作,还通过学会如何学习(元学习)来抓取任何不熟悉的物品,无论形状、大小或包装如何。

最近,ACM 邀请到 Pieter Abbeel,聊一聊有关他的工作,以及那些他为更轻松「教」机器人学习而开发的技术。以下为机器之心对本次访谈进行了不改变原意的编译与整理。

ACM:让我们从深度强化学习和你开发的名为 「信赖域策略优化 」的方法开始。这种方法是如何工作的,你又是如何开发出来的?

Pieter Abbeel:过去,要把机器人放在某个地方,比如汽车厂或电子厂。这时你需要把机器人周围的环境布置好,让一切以完全相同的方式重复一遍又一遍。然后,用某种固定的动作序列对机器人进行编程,这样就能完成任务了。这对于结构化的环境非常有效,但当在可预测性稍差的环境中,我们就无能为力了。

我一直认为,当机器人能够适应不同环境时,就会发生重大变革。而要做到这一点,就意味着机器人必须具备学习能力。

ACM:那么如何让机器人学习呢?

Pieter Abbeel:这是我取得博士学位之后一直在研究的问题。从根本上说,主要有两种方法,它们相辅相成:一种是模仿学习或学徒学习,另一种是强化学习。

在模仿学习中,你告诉机器人该做什么,机器人就会从你的例子中学会做这件事。这很好,因为当你想让机器人做某件事时,你通常较为准确地知道需要它做些什么。但挑战在于,你需要给机器人提供大量的示例,这样它才能在面对新场景时进行归纳总结,并完成任务。这可能会变得非常耗时,并且一旦环境发生变化,总会有一些内容超出你所给出例子的范围。

ACM:强化学习是什么?

Pieter Abbeel:强化学习是关于试错的。在这种方法中,不需要向机器人展示该做什么,机器人只是不断尝试,然后系统会告诉它是否成功。因此原则上,你需要先通过模仿学习向机器人展示该做什么,然后让机器人不断试错,从而学习。

ACM:2012 年,ACM 图灵奖获得者 Geoff Hinton 证明,只要有足够的视觉数据,深度神经网络在训练后就能表现出前所未有的模式识别能力。我想这启发了你,使你的强化学习框架中的模式识别功能更加强大。

Pieter Abbeel:在强化学习中,机器人会自己做一些事情,但它仍然需要识别好的运行模式与差的运行模式有何不同。我和我的学生 John Schulman 开始尝试使用深度神经网络,看看能否改进强化学习算法中的模式识别器。但事实证明,强化学习算法比标准的监督学习要脆弱得多。在监督学习中,有一个输入,输出是一个标签,你只需要识别模式。而在强化学习中,机器人需要在从未运行过的情况下学会运行。在这过程中,信号不多,噪音很大。

ACM:因此,你尝试既要提高模式识别,又要让算法更加稳定。

Pieter Abbeel:我们需要能够保证机器人在持续改进。如果机器人观察最近的经验,它将更新模式识别器。而模式识别器是一种神经网络策略,用于接收当前的传感器输入并生成电机指令。我们知道,如果能想出一种方法让机器人在每一步都能持续改进,那么就有了利用这些庞大神经网络进行强化学习的真正基础。

ACM:这就是信赖域策略优化的作用所在了。

Pieter Abbeel:在传统强化学习中,我们会进行一系列试验,然后计算梯度,找出进步最大的方向。信赖域策略优化定义了一个信赖区域:一个我们知道可以信赖梯度的区域。梯度是 landscape 的一阶线性近似值。我们知道 landscape 不是线性的,但在局部它能够以这种方式近似为线性。因此,我和 John Schulman 想出了一种方法,来量化可以信赖这种线性近似的区域。接下来,我们只需在该区域内迈出一步,就能保证改进效果。

ACM:重复这样做,你就为强化训练打下了值得信赖的基础。

Pieter Abbeel:没错!我们在 YouTube 上有一段视频 ,你可以在视频中看到整个过程。机器人只是不断尝试,不断摔倒,但随着时间的推移,它真的开始运行了。学习的妙处在于,一旦你有了学习算法,你就不需要重新编程,只需再次运行学习算法,它就能学会在新情况下需要什么。

视频来源:https://bit.ly/3nZrQhs

ACM:你创立的公司 Covariant 正试图通过制造一个通用的机器人大脑来商业化这个想法。

Pieter Abbeel:我们的目标是提出一种方法,使机器人能够在学习什么以及如何学习方面通用。当然,机器人不能通过学习过操作堆乐高积木然后学会飞行,堆积木并不是学习飞行的正确数据集,但是代码可以是相同的。就像人类学习如何骑自行车或驾驶汽车,在人脑中,思路都是一样的。

ACM:Covariant 也在为商业应用构建机器人,特别是仓储取放机器人。

Pieter Abbeel:我们可以赋予机器人超越预先编程的固定动作序列的新技能,即使它们不是完全通用的。从我们的学术研究中我们知道这是可能的,我们开始考虑创建 Covariant。我们想到,机器人现在应该具备有用性。另外,我们的产品开发是数据驱动的,如果想要收集大量的数据,则需要制造出真正能激发人们购买需要的机器人。

ACM:当你在 2017 年创建 Covariant 时,自动驾驶汽车获得了大量的资金。是什么吸引了投入仓储取放机器人?

Pieter Abbeel:我们希望找到一个领域,它不需要实时干预,而是在极少数情况下才需要人工支持。实时人工干预很昂贵,无法体现机器人做事的价值。使用机器人操作,你仍然需要非常高的精度,但一旦机器人没有像预期的那样运行,就会有人介入并进行快速修复。

我们研究了许多不同的公司、行业和应用,最后我们把目光集中在仓储上,因为它似乎是一个自然而然的起点,原因有二。首先,取放是机器人几乎所有操作的基础。第二,这是一个快速发展的行业,真正需要自动化来支持我们所有的在线传送。在拾取和放置过程中没有自动化,这种非常重复的工作是对人类来说是很伤脑筋的。

ACM:你还与人共同教授一门关于 AI 业务的课程。你从向非专业人士教授 AI 中发现了什么?

Pieter Abbeel:我决定教授这门课程的原因之一是,我认为对 AI 的基本了解对做出商业决策很重要。许多公司将以某种方式使用 AI 人工智能,无论是在内部开发还是购买某种服务。商业专业的学生必须能够理解今天可能发生的事情,以及在不久的将来可能发生的事情,以及如何评估不同的系统。

这很有趣,因为对于从未真正研究过 AI 的人来说,这有点像解释一个魔术。就其核心而言,AI 是很好解释的。如果你想把它推向下一个技术前沿,你需要大量的训练,但理解基本概念并不需要多年的学习。

Recommend

-

62

62

雷锋网 (公众号:雷锋网) AI 科技评论按:机器人如何能够学到在多样且复杂的真实世界物体和环境中能够广泛使用的技能呢?如果机器人是设计用来在可控环境下进行高效的重复工作,那么这个任务就相对来说更加简单,比如设计一...

-

56

56

课程地址:https://dlrlsummerschool.ca/ MILA 2018 夏季课程包括深度学习夏季课程(DLSS)和强化学习夏季课程(RLSS),并主要由以下机构支持。Yoshua Bengio 等人组织的夏季课程每年都非常受关注,每一个主题及讲师都是该领域...

-

52

52

考虑到拉新的成本太高,我们开始着手于用户留存的精细化运营,那么,首先需要思考的第一件事,如何搭建明确目标化的用户成长体系? 移动互联网发展到今天,慢慢过了那个野蛮生长的时代。特别是当产品成熟以后,拉新遇到瓶颈或成本太高,我们逐渐将重心转移到存量用...

-

21

21

如何避免“整本书都是重点,讲过的都要考”?

-

9

9

在物流仓储场景中,无序混合纸箱码垛机器人有着大量的应用需求。对于乱序到来的、多种尺寸规格的箱子,如何用机器人实现自动、高效的码垛,节省人力的同时提升物流周转效率,是物流仓储自动化的一个难点问题。 其核心是求解装箱问题(Bin P...

-

4

4

初中如何考到年级前十?市重点初中普通班。生物地理语文英语政治都比较一般。其他还不错,但离年级前十还有一段距离。怎么拔尖努力3,...

-

5

5

宁夏启动「剑网2022」专项行动,强化NFT数字藏品等版权监管 • 37 分钟前...

-

3

3

2022-09-27 02:43 宁夏启动“剑网 2022”专项行动,强化 NFT 数字藏品等版权监管 11.5万 据《宁夏日报》9 月 27 日报道,近日,宁夏自治区版权局、公安厅、互联网信息办公室、通...

-

3

3

行动元完成亿元 Pre-A 轮融资,继续强化智能工业平台建设2023/01/03 13:54|作者

-

6

6

耗时两年,谷歌用强化学习打造23个机器人帮助垃圾分类 作者:机器之心 2023-04-25 11:44:36 以后垃圾分类这个活,可以交给机器人了。 强化学习(RL)可以让...

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK