RWKV:一个大模型小团队,要做 AI 时代的安卓

source link: https://www.geekpark.net/news/322331

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

RWKV:一个大模型小团队,要做 AI 时代的安卓

独自一人开发大模型,转身创业并拒掉巨头的橄榄枝。

「Interested in working at OpenAI ?」

香港大学物理系毕业的彭博,在今年2月3日收到了一封来自 OpenAI 的邀约邮件。吸引这家 AI 巨头的,是他作为独立开发者发布的一个开源模型:RWKV。信中并没有包含具体薪资。不过,此前有消息称 OpenAI 为软件工程师提供的年薪中位数为92.5万美元。

当时国内还少有人关注到这个创新的模型设计。

彭博回复了邮件:「OpenAI is great, but I like building Open AI :) Let me know if OpenAI plans to build a community project one day.”(OpenAI很好,但我喜欢建设 Open 的 AI :) 如果OpenAI哪天计划做一个社区驱动的项目,欢迎告诉我)。

如今,他是元智能OS的创始人。这是一个基于RWKV模型的创业公司。他更希望建设真正Open的AI,这需要更多商业和资金的支持。这就像Linux是免费的,基于Linux开源生态,会形成 Redhat 这样的商业公司。

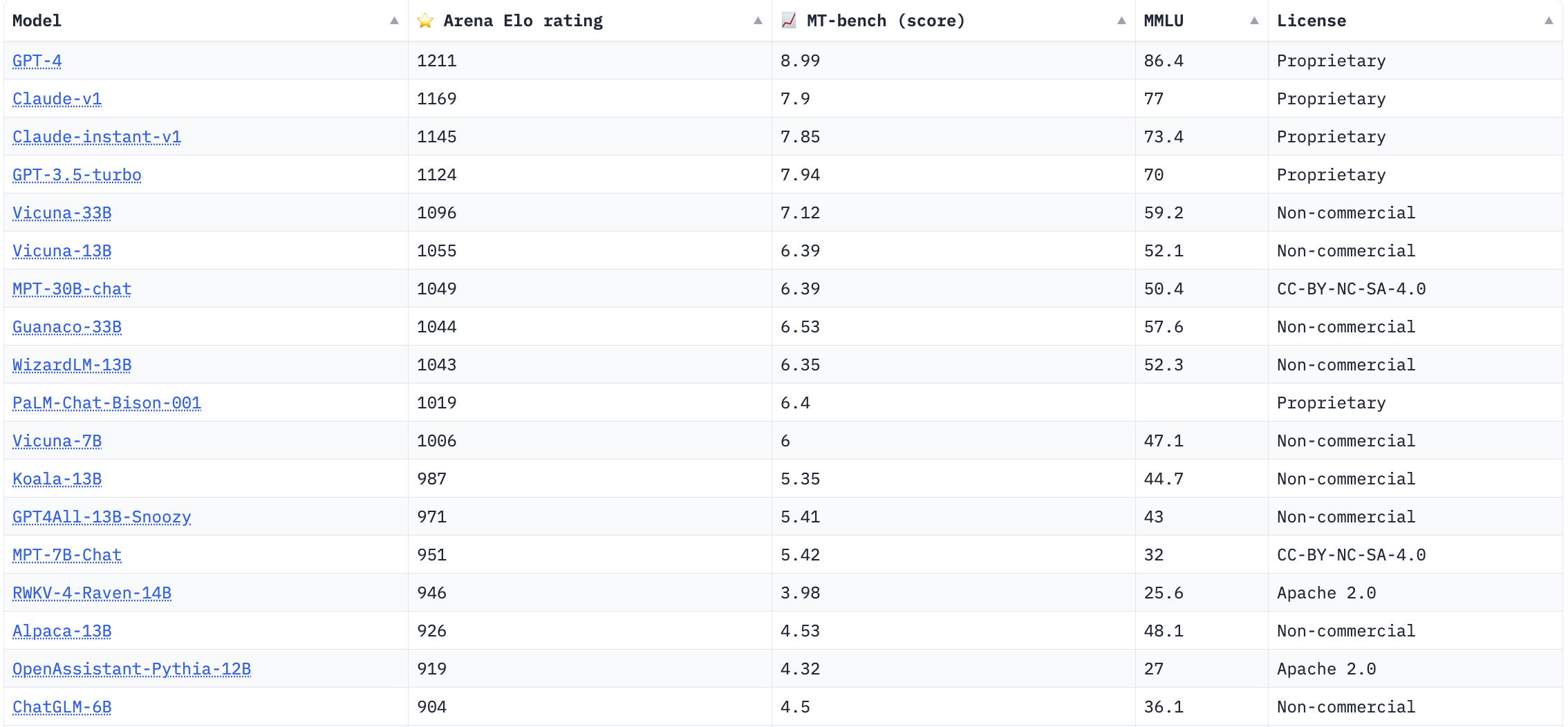

为了降低模型的推理成本,RWKV 创新性地将大模型最常用的 Transformer 架构改写成了RNN,这展现出的实用价值受到了业内的关注。让团队引以为傲,反复强调的是:在开放研究组织 LMSYS 每周更新排行榜中,真实用户测评的Elo排名中,RWKV系的对话模型 Raven-14B 的排在Alpaca-13B、OpenAssistant-Pythia-12B、ChatGLM-6B等知名项目前。

而RWKV和Raven,从设计,到优化,到大规模训练,全部由彭博一人完成。

在执行推理任务时,RWKV的性能优越。如果Transfomer架构的算力成本是T(序列长度)的平方,RWKV推理的算力成本只有T分之一,并且显存的占用是恒定的。「我们是市面上真正能够在手机的芯片上长期跑的模型。因为其他的模型跑着跑着显存就会爆掉。」元智能的另一位联创罗璇介绍。

独特的性能,让RWKV在开源社区中获得了一定的关注,得到了来自Stability AI的算力支持。RWKV也积累起了自己的开发者社群,并成立了RWKV基金会。5月底,来自全世界27个研究机构、开源社区、高校的RWKV开发者们合著的论文才在arxiv上发表,外界得以更详细了解模型设计的细节。

大模型的热潮让黑客松复兴。在今年4月份深圳一场黑客松上,经历三组初赛后,「第一个国产开源语言模型RWKV」在进入决赛的17个队伍中脱颖而出,获得了第一名。罗璇便是这场黑客松的发起人。他表示,这场开启于3月的比赛「可能是中国最早的 AIGC 黑客松」。他是AI-Transformer 社群的创始人,曾在腾讯担任高级产品经理、猎豹移动担任高级产品总监;2016年 all in AI,先后在阿里巴巴机器人部门和AI Lab担任产品总监,2018年创业做了AMR机器人公司,担任Syrius矩星的联合创始人。

夺冠之后,RWKV 团队想尝试商业化,需要一个产品和市场经验丰富的人,于是邀请罗璇加入。此后,基于RWKV的商业团队组成了4人创始团队:RWKV原作彭博、CTO 刘潇、COO孔晴、罗璇。这便是「元智能OS」的起源。

罗璇介绍,目前元智能OS团队有7人,主要精力依旧放在训练更好的基础模型上。目前公司正在进行第一轮融资,也已经接到一些微调行业模型的商单。而元智能OS最终的目标是成为大模型时代的Android。这意味着开发者基于RWKV开发应用,形成生态,与模型适配的芯片会进入终端。

诞生于个人开发者的创新模型

RWKV这一模型读作「Ra Ku」,最初的作者只有彭博一个人。RWKV模型的诞生,一部分源自彭博自己用AI生成小说的兴趣。

小说是一种需要连贯逻辑、内在世界观的长文本。三年前,GPT系列模型已经引起了学界的关注,但是长文本生成依旧是不小的挑战。

在2017年的谷歌论文中,为了实现Attention机制,研究者提出了如今被LLM广泛采用的Transformer架构。这一架构的特点是具有可扩展性。并行的Transformer组件提升了模型训练数据的效率,从而让LLM的参数规模持续增加,最终出现了「智能涌现」的特点。

但是这一架构也有缺点,在执行推理任务,也就是生成内容的时候,计算复杂度会随着序列长度(T)成2次方O(T*2)增加,这意味着推理时计算成本的也会成2次方增加。这种计算复杂度的增加是由Attention机制带来的,因此,一部分研究者在思考如何能够简化Attention机制。

2021年,苹果发布了一篇论文《An Attention Free Transformer》,提出了种不需要 Attention 机制的 Transformer 模型。这给了彭博很大的启发,他将这篇论文中的公式进行改写,成功将Attention公式改写成了RNN(循环神经网络)形式。循环神经网络是之前 NLP 里最常用的深度学习模型。

公式的改写,将推理的计算复杂度降为了线性增长。于是,RWKV被形容为成兼具Transformer与RNN优点的模型架构:可并行高效训练、推理性能优越。

RWKV模型训练完成后,彭博将其在国外的GitHub、以及国内的魔搭社区上线。他开发了更适合对话的ChatRWKV,并建立了Discord社区、QQ群,欢迎开发者们一起做「大规模语言模型的 Stable Diffusion」、「开源ChatGPT」。这样一个出自独立开发者的模型,在5月初, RWKV一度在开放研究组织LMSYS的模型对抗排名中取得了第六名,无疑令人惊喜。

对于小型创业团队、个人开发者而言,RWKV是没有算力门槛,是可以快速尝试的模型。在最近一次不到二十人的小范围聚会中,我遇到四五个基于大模型做应用的创业者。其中就有两个使用了RWKV。

这样创业小团队的画像很常见:基于已有的开源模型,结合私有数据做Finetune,帮助一些需要提升效率的企业,做模型定制或内部的 AI Agent 开发。

他们常常在开源社区选用最合适的模型,也熟悉各个开源模型的特点。一位创业者则在朋友圈展示出RWKV的安卓端版的页面,这是一个可以在手机端进行推理的模型版本。

其中一位创业者表示,RWKV模型的优势是处理长文本的信息,并给出回应,因此在格外需要这一能力的用例上会优先考虑,不过模型的缺点也很明显,发散性太强,交互过程中会容易偏离话题。「它实际上的竞争对手是GLM」他说。

ChatGLM是清华智谱团队开发的模型。其中的6B版本在国内开源模型中表现出色,颇有口碑。几天前团队刚刚宣布了此前开源的ChatGLM-6B 和ChatGLM2-6B允许商用。

RWKV保持开源,元智能OS想成为大模型时代的安卓

在开源模型层出不穷的当下,如何评测模型无疑是关键任务。各家也往往搬出其自研模型在MMLU、AGIEval、C-Eval等评测基准上的表现,以自证模型能力。但不止一位行业人士指出,模型可以根据评测基准做特定的数据优化,由此最终得到比较好的打分结果。这一现象难免令外界无所适从。

要真正理解RWKV在排行榜上取得的排名的含义,就需要理解排名产生的规则。开放研究组织 LMSYS 则创新地尝试一种综合的测评策略,每周更新排行榜。最新的结果显示,RWKV系列 14B的对话模型 Raven 排在第15位,综合排位在ChatGLM-6B(清华-智谱)之前,后者是在国内颇具口碑的开源模型。在5月8日的排行中,RWKV一度排在第六。

LMSYS的测评策略中一共使用三种方式为模型打分,RWKV似乎在第一种 Chatbot Arena(对话模型竞技场)的表现上更加优越;而在MT-bench、MMLU这样的基于任务集的测试上得分偏低。

Chatbot Arena(对话机器人竞技场)是随机匿名的人类打分机制。在网页上,访客同时跟两个匿名模型进行交互,并投票给更认为体验更佳的一方。这样收集众多模型间1V1的比拼结果之后,LMSYS最终统计模型的排名。在每周的排名公布时,也会公布任意两个模型在竞技场上「狭路相逢」时的表现。最近一周,当RWKV-4-Raven-14B与ChatGLM-6B被人类比较时,59%的概率下,人类会觉得 Raven 表现更优秀,这或许说明了在对话的场景下,Raven略胜一筹。

而在MT-bench、MMLU这样的基于任务集的测试上得分偏低,这表明RWKV在能力泛化、知识迁移、多轮有挑战的任务上能力较弱。

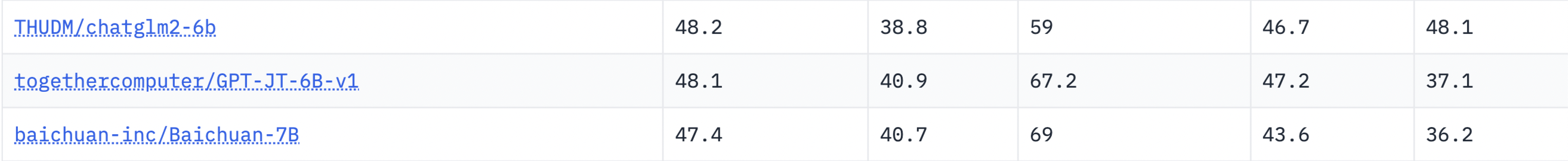

罗璇曾形容 RWKV 是「最佳开源可商用」LLM。不过,在百川智能 Baichuan-13B、智谱 ChatGLM2-6B 先后宣布开源可商用之后,国内开源可商用的模型格局必然发生新的变化。5月,RWKV在Hugging face模型平台上线,但目前已经不在 Open LLM Leaderboard 榜单上,ChatGLM2-6B 和 Baichuan-7B 榜单中排位相近。

在5月接受36Kr采访时,彭博表示「RWKV 中文 7B 模型和 ChatGLM 6B 中文模型也是互有胜负,不过,RWKV 还没开始真正炼中文模型,使用的是英文词表,还没有加入大规模中文语料。」

彭博目前的主要精力都集中在训练模型上,RWKV-4-world 系列模型也在不断上线中,其中就包括了针对中文的特化模型,重点提升了中文能力,降低了其它语言的能力。目前Demo也已经开放在魔搭社区供人尝试。在AI作曲上,彭博也发布了最新的开源成果,基于RWKV生成MIDI形式音乐的模型。(注:MIDI一种数字音频格式,用于控制电子音乐设备之间的通信)

RWKV模型本身会一直保持开源和非盈利,目标是成为大模型时代的Linux,而元智能OS则希望能够成为大模型时代安卓。

罗璇表示,安卓是 Linux 在手机垂直领域的版本。对应而言,元智能OS就会成为大模型时代某一领域最通用的模型。「大模型时代的安卓」包含了两层含义,「会有一个大的生态,在这个基础上,提供多样的能力给第三方应用;另外一方面,硬件会是RWKV的重要生态。」他介绍,目前终端和服务器上的GPU、CPU都可以用来做模型推理,而在模型训练方面,Nvidia、AMD、Intel等芯片都已能够很好支持,国产芯片中不少也移植了RWKV的算子。

「做ChatGPT现在不能做的」: 未来的模型会在端侧运行

元智能OS已经接到了帮助一些微调行业垂直领域的商单,客户主要来自金融、律所、智能硬件等行业,以license的形式收年费。RWKV模型吸引它们的主要是两点:全自研,算力成本低。

元智能OS会结合特定领域的公开数据,在基础模型上微调一个更具备行业知识的垂直模型,再交由客户结合自己的私有业务数据,进行本地化部署。部署环节往往由第三方技术提供方实现,这是由于公司希望私有数据不外泄。本地化部署所面临的是业务上的门槛,而非技术上的门槛,「数据不能出来,不能进模型。」

这也是为什么以API的商业模式的前景开始受到怀疑。尽管OpenAI已经在3月分更新了服务条款,明确表示不再使用任何API的数据进行训练,依旧难以打消企业们对于数据外泄的担忧。

元智能OS的观点是明确的:API不是一个好的商业模式。

- 延迟问题难以解决。在智能汽车、智能音箱,以及未来的XR眼镜、头显等场景,通过API调用云端算力资源的延迟性较高。「现在Open AI的API调用体验非常差,实际上是不可用的」

- 成本问题,调用API按照消耗Token的数量来计费,如果在终端设备上使用功能,还要为云端的Token付费,也是不合理的。罗璇表示,如果接入OpenAI的API,计算下来,一个智能音箱需要10美金的订阅费抵消成本。

- 数据安全问题。除了企业不愿意外泄数据,在个人助理领域,个人用户也不希望自己的私人数据被传入云端。

在端侧运行大模型,也已经是行业内的共识,高通前不久展示针对Stable Diffusion 而做的优化,实现了在安卓手机上运行模型。

由于RWKV模型的性能优势,元智能OS将「终端部署大模型」视为自己的最大战场。彭博表示「AI 大模型的决战战场是在硬件上面,也就是芯片。无论是端侧和云测都需要专用芯片。」陆奇在深圳的公开演讲中就曾表示,可能需要三到五年的时间,大模型会在手机端上运行。

目前RWKV已经提供了在Windows 和 Mac、Linux电脑上可以安装的版本 RWKV Runner。除了已经放出的安卓版本,IOS版本在开发中。罗璇告诉极客公园:元智能OS正在进行第一轮融资。团队未来半年的核心还是模型,提升模型能力是一方面,另外也正在和一些芯片公司和算力平台洽谈,打造标杆客户。

其中,标杆客户包括有终端部署的形式,也包括跟云平台合作提供API调用。「现在的精力其实是更多在模型训练、开发者生态和融资,接下来会逐渐调整到产品和生态」。

「硬件的迭代周期,是天然的门槛」

基于大模型的Killer app尚未出现的当下,基于大模型的应用价值,引起了人们的诸多讨论。

Notion AI、Office 365 Copilot这样商业价值确定的应用,共同之处是在成熟的软件产品上新增AIGC功能。罗璇形容,这样的新功能,是「在原来定义好的场景下,提升效率,帮助人节省了劳动力。」

但是他认为,这样产品思路并没有带来增量价值;而且,只做效率提升,带来的商业价值很快就会见顶。他认为,如何用大模型带来的生产力创造增量价值,比如「让人们获得更多、更好的数字化内容」,应该是创业者思考的方向。

另外一个现象是,调用模型能力,从单点价值出发的创业团队似乎难以形成商业壁垒。「创业公司基于 ChatGPT 能够创造的价值非常单薄」的观点便是代表。

比如 Jasper.AI 这样调用模型能力应用的营销写作产品,在ChatGPT推出之后,反而迎来了流量下降。这意味着基础模型能力更强、更易用之后,具备覆盖一部分应用的能力。另外一个例子是 Gammaly,这个已经存在了十几年的写作辅助软件,在ChatGPT表现出优异的语言能之后,也面临着自证「Gammaly 能够提供更好的写作辅助」的新课题。

组织过十几场黑客松,作为经历过互联网时代产品老人,罗璇也表示目前的初创产品往往存在问题:

- 对于技术边界理解不深入。或者不知道现在的模型能做什么,或者不知道随着模型发展,未来能够做什么;这表现在,做出来的应用,是模型已经能实现的功能;或者想实现的效果,未来三到五年,通过模型能力也无法实现。

- 对市场竞争格局、现有市场供需关系理解不深入,这容易带来两种结果:做出来的产品很容易被有渠道的大厂直复制;或者做出来的东西没有市场需求,没有人用。

在大模型技术快速发展的当下,理解技术边界,思考技术会如何演变,对于产品经理而言变得更加重要,这样才能避免思考产品时刻舟求剑。

RWKV模型在进入终端硬件上有优势,罗璇本人也看好模型进入在机器人、XR等手机、PC之外的终端硬件之后所带来的可能性。首先,这些终端硬件带来激活新的应用场景,从而衍生出其上搭载的软件服务和数字化内容;其次,硬件的迭代周期很长,是天然的门槛。

「谁先做,就很有可能就有一些优势。」在黑客松中,为了鼓励硬件项目,他还专门设立了硬件奖项。深圳拥有的硬件产业链优势,也寄托了他「让AI发生在中国大湾区」的愿望。

Recommend

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK