AI领域大显神威,Gaudi2和Sapphire Rapids为AI训练提供优秀性能还节约成本

source link: http://www.expreview.com/88992.html

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

AI领域大显神威,Gaudi2和Sapphire Rapids为AI训练提供优秀性能还节约成本

Strike发布于 2023-6-29 10:14

本文约 1020 字,需 2 分钟阅读

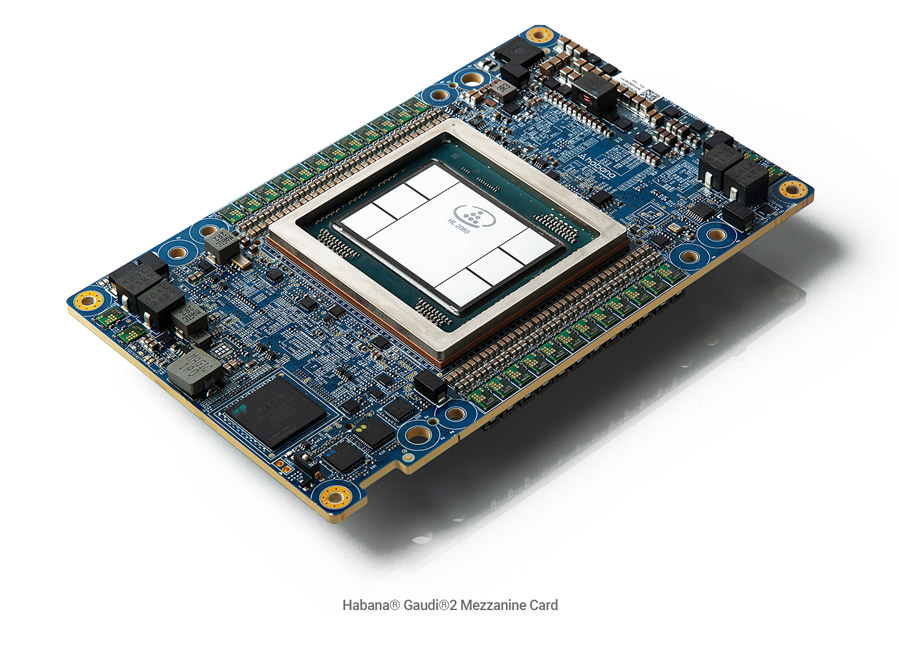

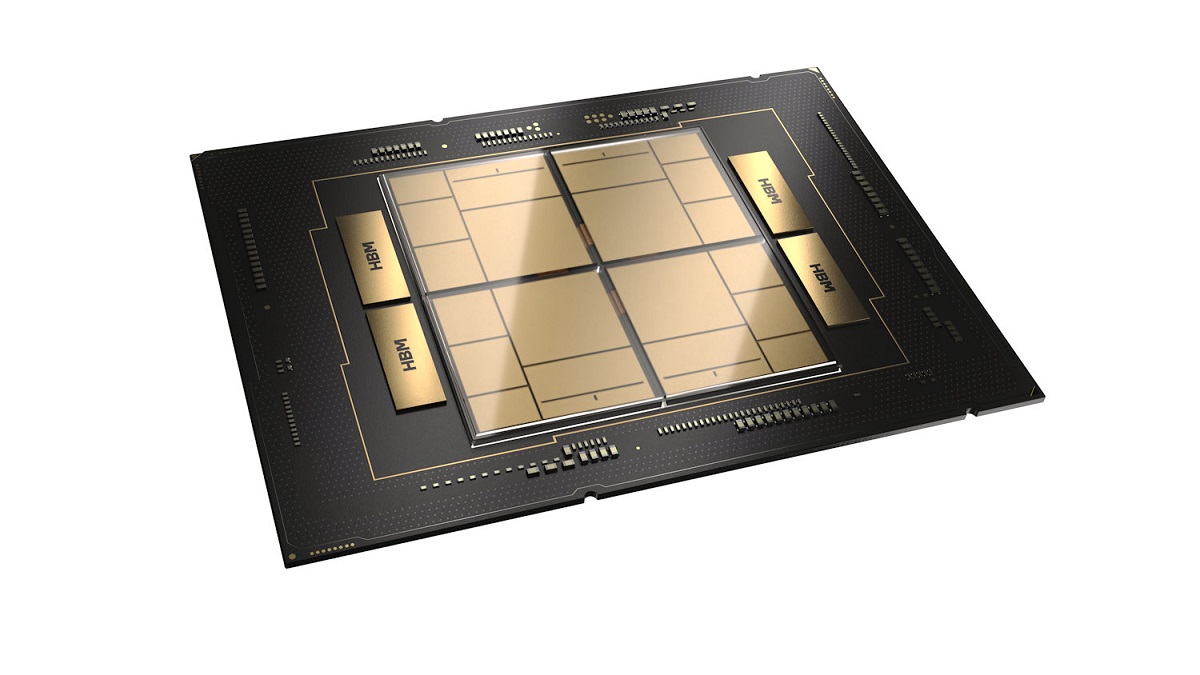

Intel今年2月份推出了Sapphire Rapids架构的第四代至强可扩展处理器,而在5月份推出了第二代深度学习芯片Habana Gaudi 2,后者自然是针对AI领域的产品,而前者也针对AI性能经行了大量优化,MLCommons公布其行业AI性能基准测试MLPerf训练3.0的结果,Intel的这两款产品都展现出令人印象深刻的训练结果。

目前,业内普遍认为生成式AI和大语言模型(LLMs)仅适宜在GPU上运行。然而,最新的数据显示,基于Intel产品组合的AI解决方案,能够为在封闭生态系统中寻求摆脱当前效率与规模限制的客户提供极具竞争力的选择。

先来说说Habana Gaudi2,训练生成式AI和大语言模型需要服务器集群来满足大规模的计算要求。最新MLPerf结果切实验证了Gaudi2在要求极为苛刻的模型——1750亿参数的GPT-3上的出色性能以及高效的可扩展性。

Gaudi2在GPT-3模型上,384个加速器上的训练时间为311分钟,从256个加速器到384个加速器实现近线性95%的扩展效果。•在计算机视觉模型ResNet-50(8个加速器)和Unet3D(8个加速器)以及自然语言处理模型BERT(8个和64个加速器)上取得了优异的训练结果。与去年11月提交的数据相比,BERT和ResNet模型的性能分别提高了10%和4%,证明Gaudi2软件成熟度的提升,软件支持在持续发展和成熟,并能与日益增长的生成式AI及大语言模型的需求保持同步。

而第四代至强可扩展处理器则是众多解决方案中唯一提交的基于CPU的解决方案,MLPerf结果表明,至强可扩展处理器为企业提供了“开箱即用”的功能,可以在通用系统上部署AI,避免了引入专用AI系统的高昂成本和复杂性。

在封闭区,第四代至强可以分别在50分钟以内(47.93分钟)和90分钟以内(88.17分钟)的时间里训练BERT和ResNet-50模型。对于BERT模型的开放区,结果显示,当扩展至16个节点时,第四代至强能够在大约30分钟左右(31.06分钟)完成模型训练。对于较大的RetinaNet模型,第四代至强能够在16个节点上实现232分钟的训练时间,使客户能够灵活地使用非高峰期的至强周期来训练其模型,即可以在早晨、午餐或者夜间进行模型训练。具备Intel AMX的第四代英特尔至强可扩展处理器提供了显著的性能提升,其范围覆盖了多个框架、端到端数据科学工具,以及广泛的智能解决方案生态系统。

对于少数从头开始间歇性训练大模型的用户,他们可以使用通用CPU,并且通常是在已经完成部署的、基于Intel的服务器上运行其业务。此外,大多数人将采用预先训练好的模型,并用小型数据集对其进行微调。Intel发布的结果表明,通过使用Intel AI软件以及标准的行业开源软件,这种微调可以在短短几分钟内完成。

Recommend

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK