ChatGLM-6B升级V2:性能大幅提升,8-32k上下文,推理提速42%

source link: https://www.qbitai.com/2023/06/64023.html

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

ChatGLM-6B升级V2:性能大幅提升,8-32k上下文,推理提速42%

C-Eval榜单上排名最高的开源模型

衡宇 发自 凹非寺

量子位 | 公众号 QbitAI

清华系大模型 ChatGLM-6B 再升级!背后团队新发布了 ChatGLM2-6B 。

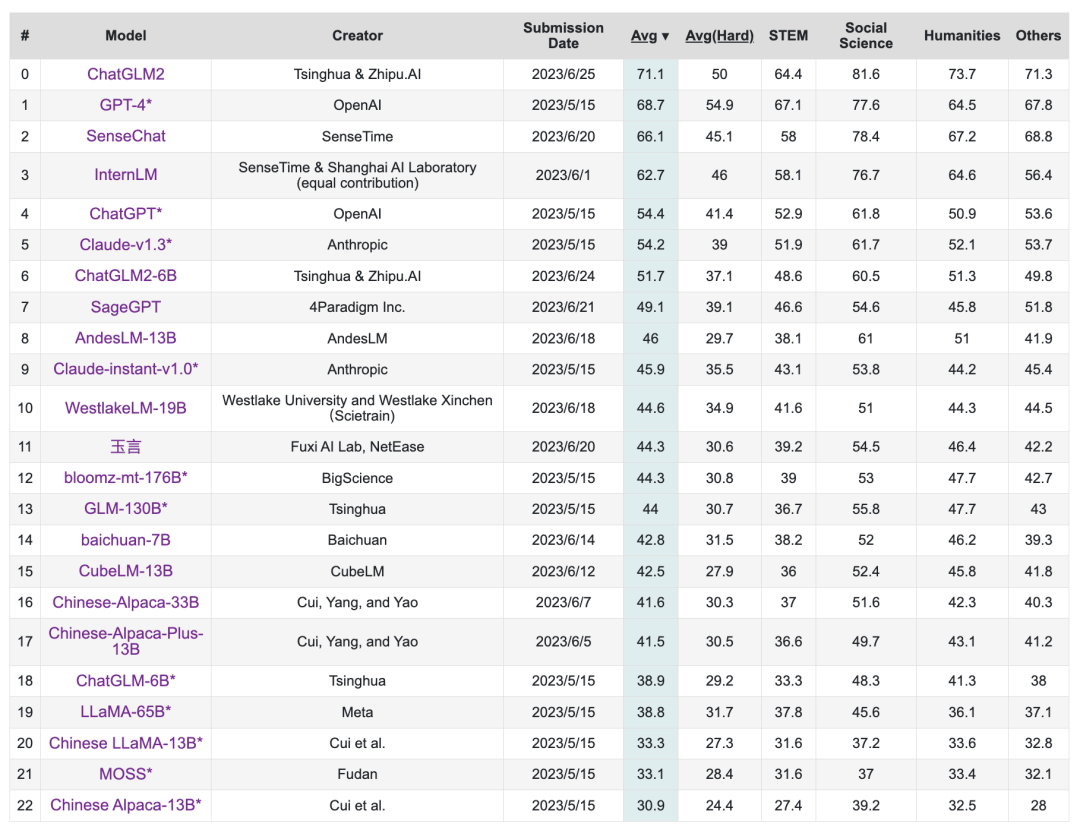

在主要评估LLM模型中文能力的 C-Eval 榜单中,截至6月25日 ChatGLM2 模型以 71.1 的分数位居 Rank 0 ,ChatGLM2-6B 模型以 51.7 的分数位居 Rank 6,是榜单上排名最高的开源模型。

CEval榜单,ChatGLM2暂时位居Rank 0,ChatGLM2-6B位居 Rank 6

性能升级 ChatGLM2-6B 是开源中英双语对话模型 ChatGLM-6B 的第二代版本,在保留了初代模型对话流畅、部署门槛较低等特性的基础之上, ChatGLM2-6B 引入了如下新特性:

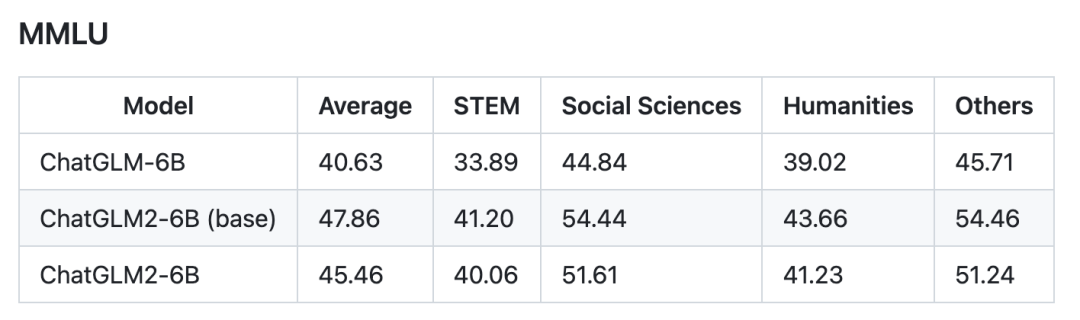

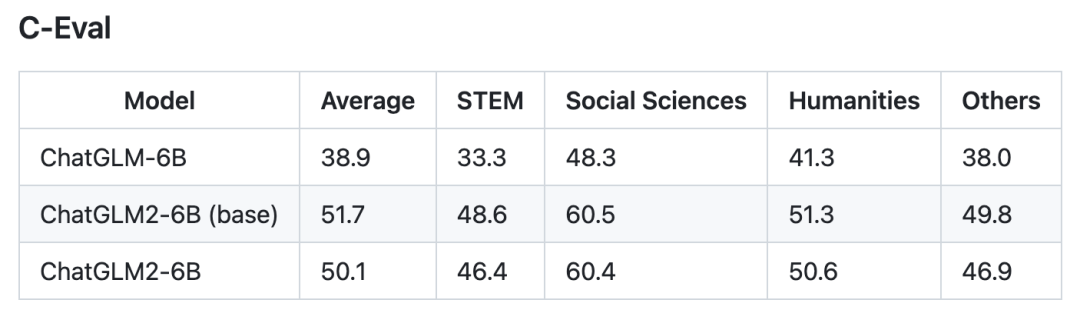

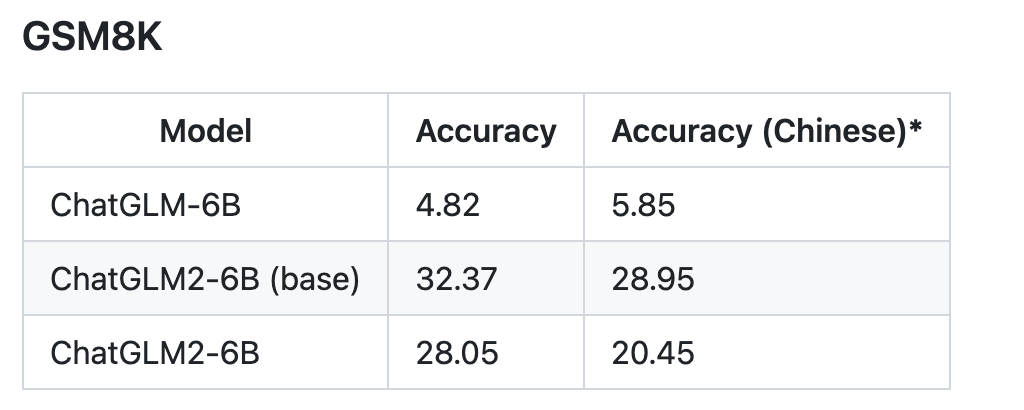

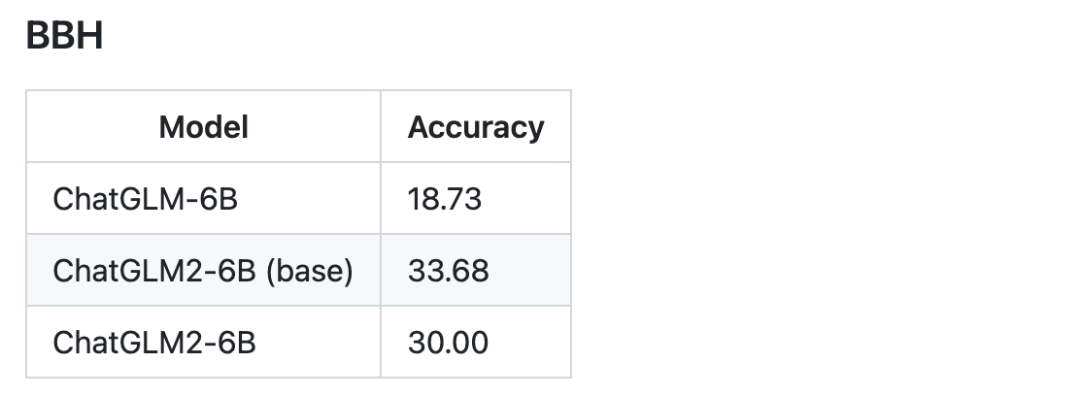

更强大的性能:基于 ChatGLM 初代模型的开发经验,我们全面升级了 ChatGLM2-6B 的基座模型。ChatGLM2-6B 使用了 GLM 的混合目标函数,经过了 1.4T 中英标识符的预训练与人类偏好对齐训练,评测结果显示,相比于初代模型,ChatGLM2-6B 在 MMLU(+23%)、CEval(+33%)、GSM8K(+571%) 、BBH(+60%)等数据集上的性能取得了大幅度的提升,在同尺寸开源模型中具有较强的竞争力。

更长的上下文:基于 FlashAttention 技术,我们将基座模型的上下文长度(Context Length)由 ChatGLM-6B 的 2K 扩展到了 32K,并在对话阶段使用 8K 的上下文长度训练,允许更多轮次的对话。但当前版本的 ChatGLM2-6B 对单轮超长文档的理解能力有限,我们会在后续迭代升级中着重进行优化。

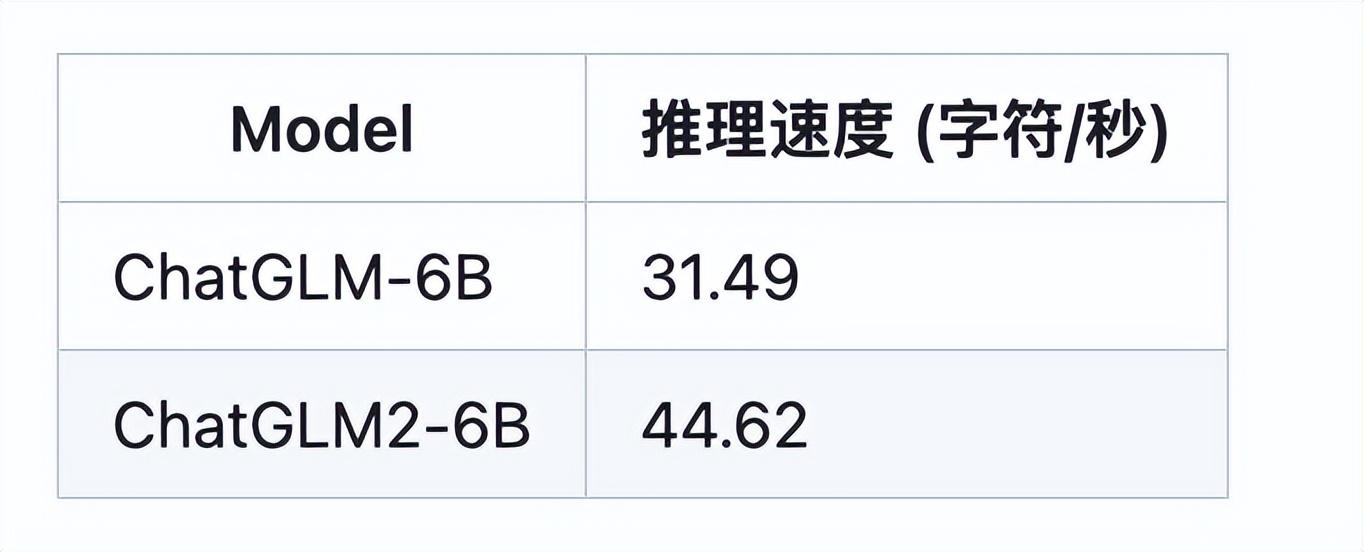

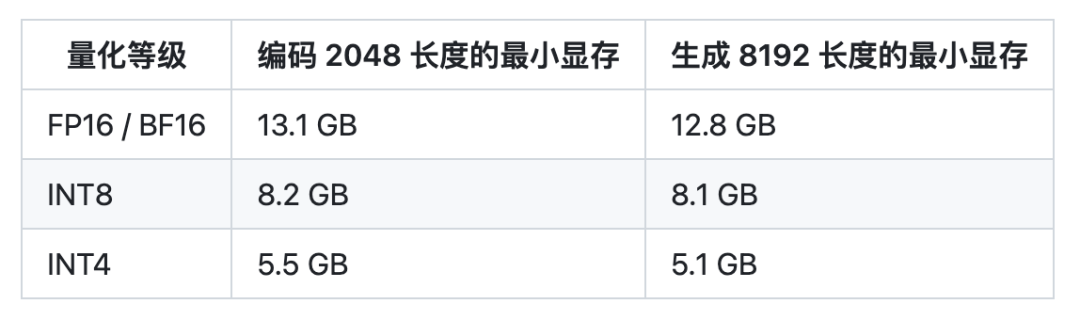

更高效的推理:基于 Multi-Query Attention 技术,ChatGLM2-6B 有更高效的推理速度和更低的显存占用:在官方的模型实现下,推理速度相比初代提升了 42%,INT4 量化下,6G 显存支持的对话长度由 1K 提升到了 8K。

更开放的协议:ChatGLM2-6B 权重对学术研究完全开放,在获得官方的书面许可后,亦允许商业使用。

选取了部分中英文典型数据集进行了评测,以下为 ChatGLM2-6B 模型在 MMLU (英文)、C-Eval(中文)、GSM8K(数学)、BBH(英文) 上的测评结果。

推理能力如何?

ChatGLM2-6B使用了Multi-Query Attention,提高了生成速度。生成2000个字符的平均速度对比如下:

Multi-Query Attention 同时也降低了生成过程中 KV Cache 的显存占用,此外,ChatGLM2-6B 采用 Causal Mask 进行对话训练,连续对话时可复用前面轮次的 KV Cache,进一步优化了显存占用。

因此,使用 6GB 显存的显卡进行 INT4 量化的推理时,初代的 ChatGLM-6B 模型最多能够生成 1119 个字符就会提示显存耗尽,而 ChatGLM2-6B 能够生成至少 8192 个字符。

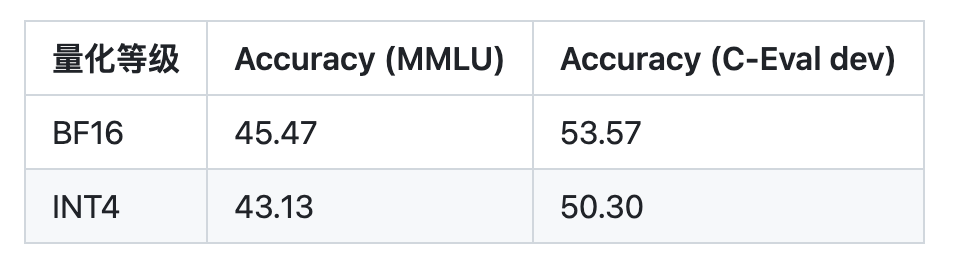

也测试了量化对模型性能的影响。结果表明,量化对模型性能的影响在可接受范围内。

多个能力取得提升

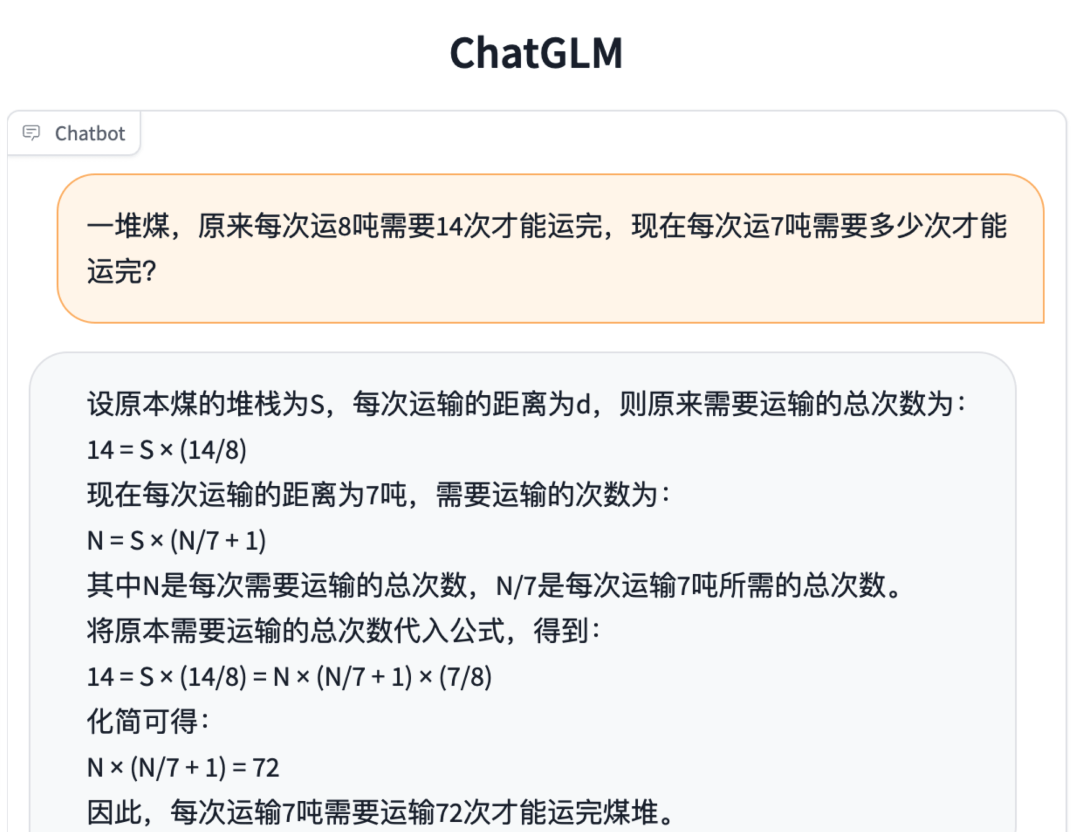

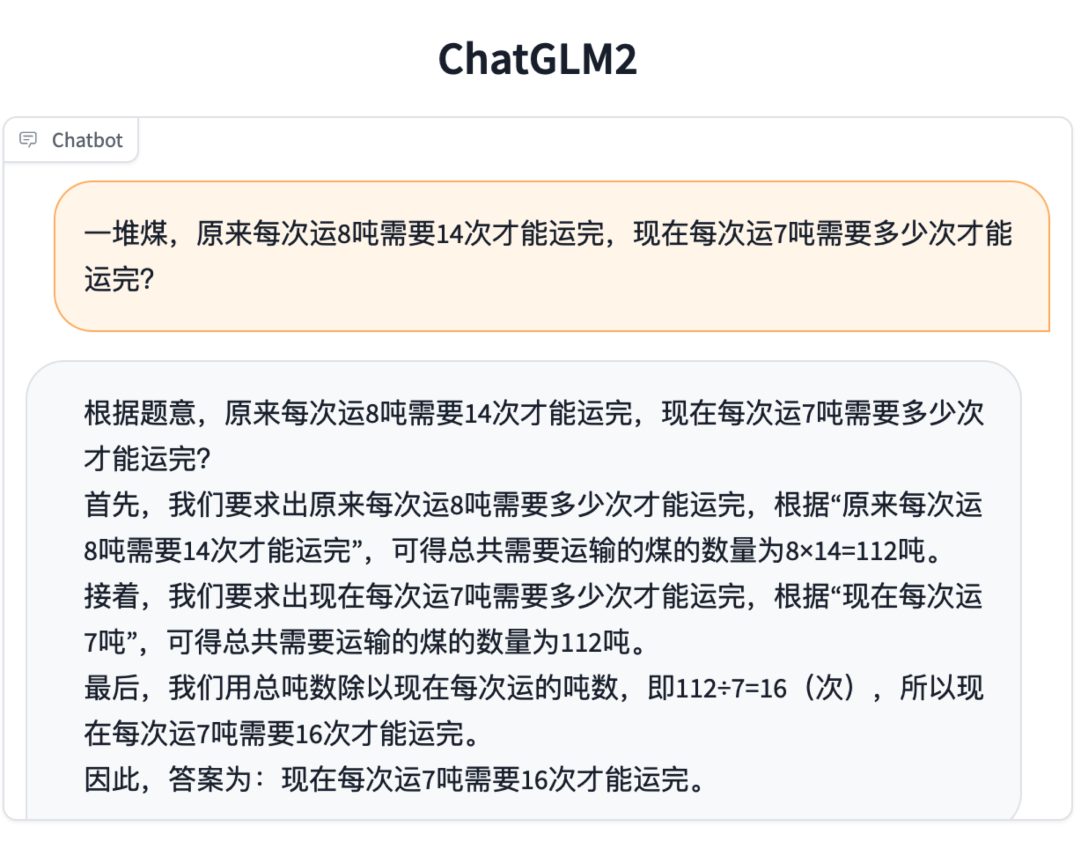

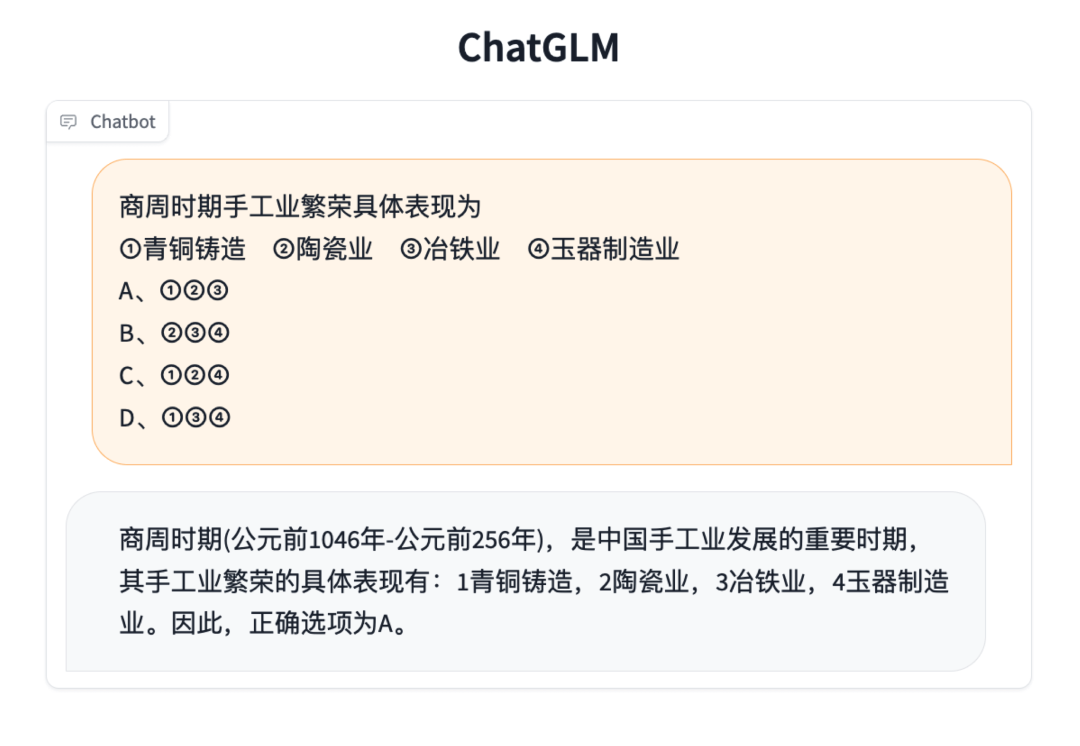

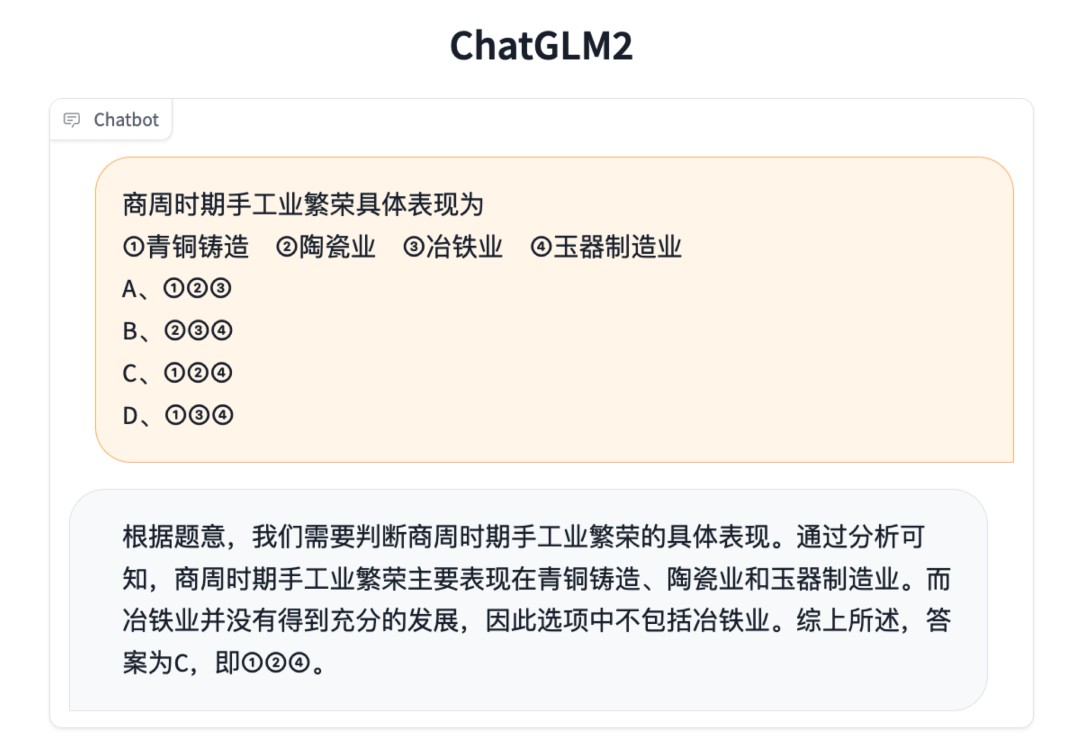

相比于初代模型,ChatGLM2-6B 多个维度的能力都取得了提升,以下是一些对比示例。

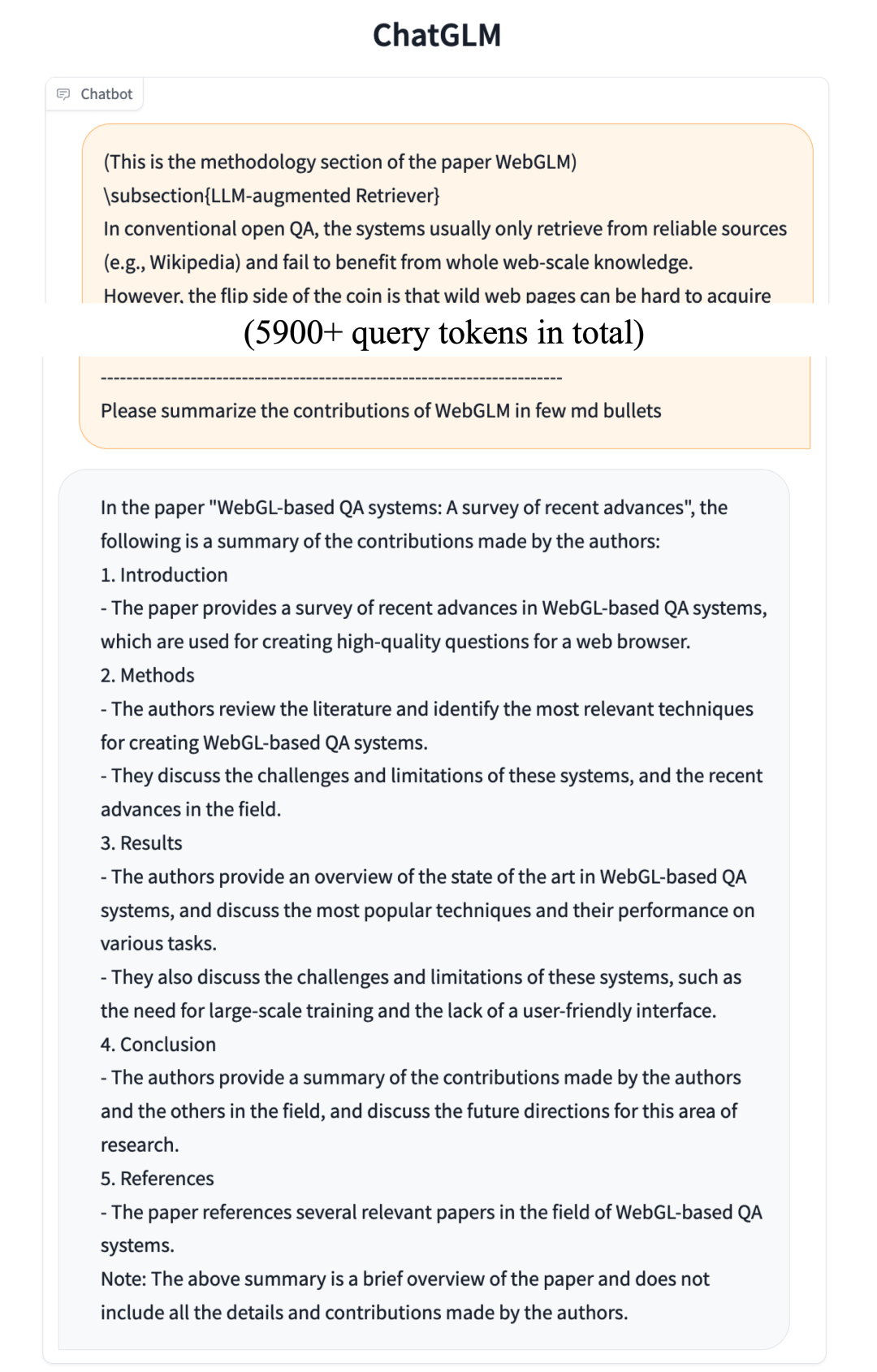

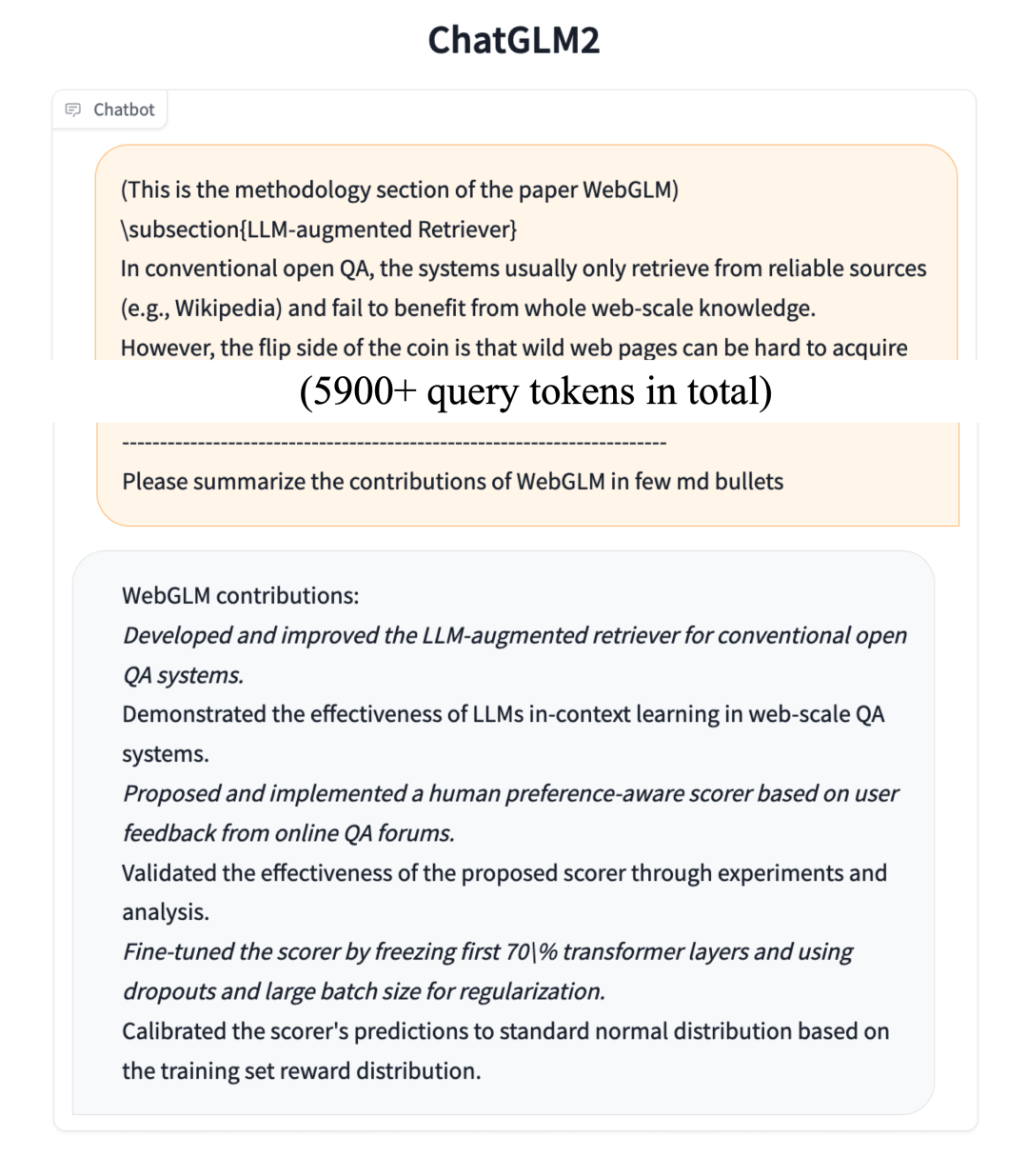

长文档理解

安装ChatGLM2-6B:

https://github.com/THUDM/ChatGLM2-6B

Recommend

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK