LeCun再爆金句:ChatGPT?连条狗都比不上!语言模型喂出来的而已

source link: https://www.51cto.com/article/757985.html

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

LeCun再爆金句:ChatGPT?连条狗都比不上!语言模型喂出来的而已

图灵三巨头之一的LeCun昨日又爆金句。

「论聪明程度,ChatGPT可能连条狗都不如。」

这句话来自本周四LeCun在Vivatech上和Jacques Attalie的一场辩论,可谓精彩纷呈。

CNBC甚至直接把这句话放到了标题里,而LeCun也在之后火速转推。

“ChatGPT和狗:比不了一点”

LeCun表示,当前的AI系统,哪怕是ChatGPT,根本就不具备人类的智能水平,甚至还没有狗聪明。

要知道,在AI爆炸发展的今天,无数人已经为ChatGPT的强大性能所折服。在这种情况下,LeCun的这句话可谓惊世骇俗。

不过,LeCun一贯的观点都是——不必太过紧张,如今的AI智能水平远远没到我们该担忧的地步。

而其他的科技巨头则基本和LeCun持截然相反的意见。

比如同为图灵三巨头的Hinton和Bengio,以及AI届人士由Sam Altman挑头签的公开信,马斯克的危机言论等等。

在这种大环境下,LeCun一直「不忘初心」,坚定认为现在真没啥可担心的。

LeCun表示,目前的生成式AI模型都是在LLM上训练的,而这种只接受语言训练的模型聪明不到哪去。

「这些模型的性能非常有限,他们对现实世界没有任何理解。因为他们纯粹是在大量文本上训练的。」

而又因为大部分人类所拥有的知识其实和语言无关,所以这部分内容AI是捕捉不到的。

LeCun打了个比方,AI现在可以通过律师考试,因为考试内容都停留在文字上。但AI绝对没可能安装一个洗碗机,而一个10岁的小孩儿10分钟就能学会怎么装。

这就是为什么LeCun强调,Meta正尝试用视频训练AI。视频可不仅仅是语言了,因此用视频来训练在实现上会更加艰巨。

LeCun又举了个例子,试图说明什么叫智能上的差别。

一个五个月大的婴儿看到一个漂浮的东西,并不会想太多。但是一个九个月大的婴儿再看到一个漂浮的物体就会感到非常惊讶。

因为在九个月大的婴儿的认知里,一个物体不该是漂浮着的。

LeCun表示,如今我们是不知道如何让AI实现这种认知能力的。在能做到这一点之前,AI根本就不可能拥有人类智能,连猫猫狗狗的都不可能。

Attali:我也要签公开信

在这场讨论中,法国经济和社会理论家Jaques Attali表示,AI的好坏取决于人们如何进行利用。

然而他却对未来持悲观态度。他和那些签公开信的AI大牛一样,认为人类会在未来三四十年内面临很多危险。

他指出,气候灾难和战争是他最为关注的问题,同时担心AI机器人会「阻挠」我们。

Attali认为,需要为AI技术的发展设置边界,但由谁来设定、设定怎么样的边界仍是未知的。

这和前一阵子签的两封公开信所主张的内容相同。

当然,公开信LeCun也是压根没搭理,发推高调表示哥们儿没签。

LeCun炮轰ChatGPT——没停过

而在此之前,LeCun针对ChatGPT不止讲过过一次类似的话。

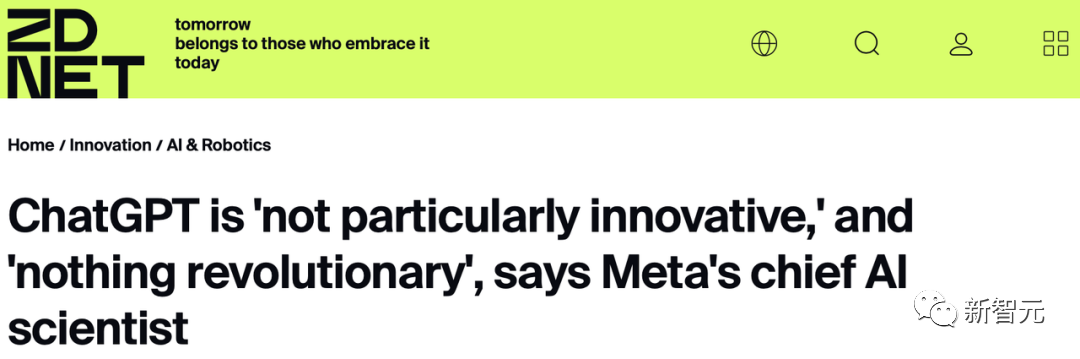

就在今年的1月27日,Zoom的媒体和高管小型聚会上,LeCun对ChatGPT给出了一段令人惊讶的评价——

「就底层技术而言,ChatGPT并不是多么了不得的创新。虽然在公众眼中,它是革命性的,但是我们知道,它就是一个组合得很好的产品,仅此而已。」

「除了谷歌和Meta之外,还有六家初创公司,基本上都拥有非常相似的技术。」

此外,他还表示,ChatGPT用的Transformer架构是谷歌提出的,而它用的自监督方式,正是他自己提倡的,那时OpenAI还没诞生呢。

当时闹得更大,Sam Altman直接在推上给LeCun取关了。

1月28日,LeCun梅开二度,继续炮轰ChatGPT。

他表示,「大型语言模型并没有物理直觉,它们是基于文本训练的。如果它们能从庞大的联想记忆中检索到类似问题的答案,他们可能会答对物理直觉问题。但它们的回答,也可能是完全错误的。」

而LeCun对LLM的看法一以贯之,从未改变。从昨天的辩论就可以看出,他觉得语言训练出来的东西毫无智能可言。

今年2月4日,LeCun直白地表示,「在通往人类级别AI的道路上,大型语言模型就是一条歪路」。

「依靠自动回归和响应预测下一个单词的LLM是条歪路,因为它们既不能计划也不能推理。」

当然,LeCun是有充分的理由相信这一点的。

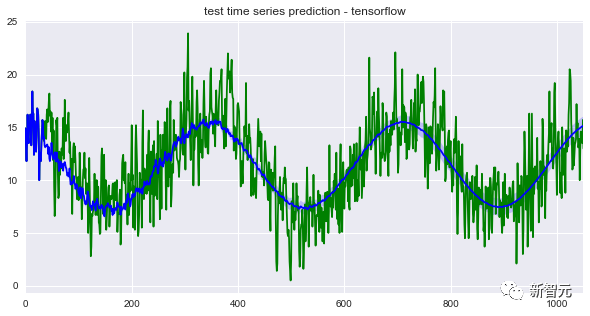

ChatGPT这种大语言模型是「自回归」。AI接受训练,从一个包含多达14000亿个单词的语料库中提取单词,预测给定句子序列中的最后一个单词,也就是下一个必须出现的单词。

Claude Shannon在上个世纪50年代开展的相关研究就是基于这一原则。

原则没变,变得是语料库的规模,以及模型本身的计算能力。

LeCun表示,「目前,我们无法靠这类模型生成长而连贯的文本,这些系统不是可控的。比如说,我们不能直接要求ChatGPT生成一段目标人群是13岁儿童的文本。

其次,ChatGPT生成的文本作为信息来源并不是100%可靠的。GPT的功能更像是一种辅助工具。就好比现有的驾驶辅助系统一样,开着自动驾驶功能,也得把着方向盘。

而且,我们今天所熟知的自回归语言模型的寿命都非常短,五年算是一个周期,五年以后,过去的模型就没有人再会用了。

而我们的研究重点,就应该集中在找到一种是这些模型可控的办法上。换句话说,我们要研究的AI,是能根据给定目标进行推理和计划的AI,并且得能保证其安全性和可靠性的标准是一致的。这种AI能感受到情绪。」

要知道,人类情绪的很大一部分和目标的实现与否有关,也就是和某种形式的预期有关。

而有了这样的可控模型,我们就能生成出长而连贯的文本。

LeCun的想法是,未来设计出能混合来自不同工具的数据的增强版模型,比如计算器或者搜索引擎。

像ChatGPT这样的模型只接受文本训练,因此ChatGPT对现实世界的认识并不完整。而想要在此基础上进一步发展,就需要学习一些和整个世界的感官知觉、世界结构有关的内容。

然而好玩儿的是,Meta自己的模型galactica.ai上线三天就被网友喷的查无此人了。

原因是胡话连篇。

Recommend

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK