5分钟端侧部署视觉大模型!专为Transformer优化的AI芯片来了

source link: https://www.qbitai.com/2023/06/57789.html

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

5分钟端侧部署视觉大模型!专为Transformer优化的AI芯片来了

性能可达361 FPS

丰色 发自 凹非寺

量子位 | 公众号 QbitAI

有没有人好奇:

大模型那么香,我们将它从云侧拿到端侧开发应用,比如让每台手机都标配一个大模型,岂不是更香?

——我们还没实现这个愿望,当然不是因为不想,是不能。

由于芯片架构不同,在端侧部署时往往需要开发人员对模型网络结构进行一通修改才能勉强“上车”,但改完之后性能难保证,更别提功耗、成本等一系列本就存在的问题了。

不过现在,一款号称现实开源模型直接拿来用,还能让性能、功耗与自动驾驶领域基于GPU的端侧芯片有得一拼的平台诞生了。

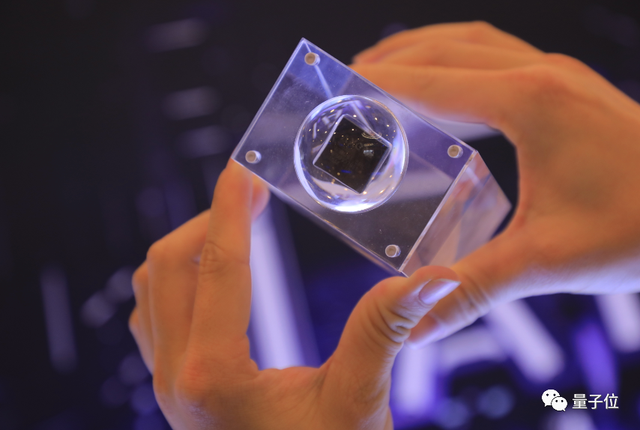

它叫AX650N,来自爱芯元智,对Transformer架构支持效果尤甚。

Transformer不用多说,它是当下最火的ChatGPT、Stable Diffusion等大模型背后的基础架构。

那么具体效果如何?咱这就展开参数一一来看。

5分钟就能完成原版Swin Transformer端侧部署

AX650N是AI芯片公司爱芯元智发布的第三代端侧芯片。

其构成包括CPU和NPU等,其中CPU采用的是八核A55处理器,NPU则采用了自研混合精度技术,可以做到43.2TOPs(INT4)或10.8TOPs(INT8)的高算力。

AX650N主要用于端侧视觉感知。

目前在该领域,业界主要还是基于CNN网络开发应用。

相反,准确率和性能双佳的Swin Transformer并没有得到突出的大规模落地,还是多部署于云端服务器。

爱芯元智表示,这是因为GPU对于MHA结构(Transformer中的多头注意力机制)计算支持更友好。

而目前的大部分端侧AI芯片由于其架构限制为了保证CNN结构的模型效率更好,基本上对MHA结构没有过多性能优化,因此我们需要修改Swin Transformer的网络结构才能勉强将其部署在端侧——

一旦修改网络结构,就意味着将出现一系列问题,例如精度下降,精度一降就得对模型进行重训,这个过程就要以星期甚至是月来计算了。

爱芯元智联合创始人、副总裁刘建伟介绍:

用AX650N在端侧部署原版Swin Transformer,从拿到测试板到demo复现,只需要5分钟,再到在自己的私有环境里跑起来私有模型,只要1个小时就能搞定。

——不仅能跑起来,还跑得飞快、性能高且功耗低。

具体而言,AX650N端侧部署Swin Transformer性能可达361 FPS。

这是什么概念?

某知名芯片商开发的基于GPU的高端域控SoC,用于自动驾驶领域,跑的也是400帧以内的一个数字。AX650N基本可与之相媲美了。

不仅性能高,AX650N还能保证准确率,做到高于市场水平的80.45%精度。

与此同时,功耗也非常低,即能效非常高,它可以跑到199 FPS/W,是上面提到的基于GPU的高端域控SoC的数倍(该芯片整体TDP大约是15到60W,实测增量功耗20多W,合下来大约是20 FPS/W)。

除了这些优势,AX650N还支持低比特混合精度,遇到大规模参数的模型,我们就可以采用INT4来减少内存和带宽占用率,从而降低大模型在端侧边缘侧部署的成本。

基于此,爱芯元智表示,AX650N可以说是成为了目前对Transformer架构支持最好的一个端侧部署平台。

对了,除了上面的Swin Transformer,AX650N还适配ViT/DeiT、DETR在内的Transformer模型,Meta最新发布的视觉模型DINOv2也达到了30帧以上的运行结果。

因此,有了AX650N,我们在下游进行检测、分类、分割等操作也更加方便。

据悉,接下来,爱芯元智AX650N将会针对Transformer结构进行进一步优化,并且将探索多模态方向的Transformer模型。

Ps. Swin Transformer以及DETR和EfficientViT的具体部署方法,爱芯元智官方提供了详细教程,这里就不再赘述,大家戳文末链接即可查看~

△Swin Transformer性能实测,3.6Tops都能跑100多帧

边缘侧、端侧部署大模型,是趋势

再回到大模型本身这个话题,大家有没有思考过它的蓬勃发展究竟会给我们带来什么?

奇绩创坛CEO陆奇博士在最近的一场演讲中提到:

当年他刚从CMU毕业时,买一张地图需要3美元,现在咱们只需要在网上花费300毫秒就能搜到一张,信息获取的成本已接近免费。

爱芯元智相关负责人就表示,大模型从某种程度上会重复如上故事,也就是说,我们可以畅想以后打开手机或者其他终端,就能获得一个诸如私人医生和律师、厨师的AI助理,它无所不知无所不晓,为我们提供成本非常低廉的咨询等服务。

另一方面,比如智能音箱,如果能够在本地用上大模型,它就能做一些真正称得上是智能的交互,而不是只会提取关键词。

为了实现诸如这样的愿望,大模型部署就不会只局限于云端。

△图源爱芯元智官网

“而从量的角度来讲,边缘侧、端侧的需求一定比云侧更大,毕竟边缘侧、端侧设备会更多。”

像我们今天讲的Transformer端侧部署,“但凡是会用到摄像头的业务,都会对它感兴趣。”

爱芯元智介绍,相比CNN网络,在端侧部署Transformer最大的好处之一就是可以解决以前长尾场景下,AI智能投入太高的问题。

比如河道垃圾监测,用CNN等网络,可能出现一类新的垃圾就得花数月去重新采集数据进行训练,不然系统就认不出来。

而基于Transformer的视觉大模型,采用无监督学习的方式进行了训练,遇到新的就能直接识别(也就是zero-shot或者one-shot能力),可以省去很大的时间和训练成本。

不过要开发可以让Transformer模型轻松又高效地在端侧跑起来的平台,要面对的困难并不少。

硬件架构上早期定位就要准,要对Transformer去做针对性的优化,要想办法能降低大参数模型带宽的使用情况,以及加载的时候怎么做到更顺畅一些。

软件上,在推理的时候,则要求做量化、而不是浮点推理,而这就比较需要经验。

在目前的成果之上,爱芯元智AX650N也还有很多迭代要做,比如怎么让硬件对离散数据拥有比较高效的读取能力,并且配套的计算还要跟上新的读取速度,以及对网络稀疏化、MOE(Mixture of Experts)、硬件底层低比特优化等方面的工作。

关于爱芯元智

爱芯元智成立于2019年5月,是一家人工智能视觉感知芯片研发及基础算力平台公司。

创始人、董事长兼CEO仇肖莘本硕毕业于清华大学自动化专业,博士毕业于美国南加州大学电子工程专业。在创立爱芯元智前,她先后担任了美国博通公司副总裁和紫光展锐CTO。

去年,爱芯元智宣布完成8亿元A++轮融资,投资方包括腾讯、美团等公司。加上之前的三轮,公司融资总金额已接近20亿元人民币。

截至目前,爱芯元智也成功研发并量产了三代多颗端侧、边缘侧智能视觉感知芯片,据称所有芯片产品均具备低功耗优势及优异的图像处理能力,应用于智能城市、智能交通、智慧制造等领域。

One More Thing

爱芯元智基于AX650N推出的爱芯派pro开发板(类似于树莓派)即将上线某宝,相关教程和工具也可以在GitHub找到。

对Transformer深度研究有需求的伙伴,可以去“整活”啦。

友情链接:

[1]https://mp.weixin.qq.com/s/csuIyfvFXPPVX8wdkQ0yOg

[2]https://mp.weixin.qq.com/s/K_RpTAX97jz2Rpk3BpGrGw

[3]https://mp.weixin.qq.com/s/vqtA9czTaYk7kJTPS3Zc4Q

Recommend

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK