人手一个Midjourney,Stability AI开源旗下生图模型,做图圈炸了

source link: https://www.36kr.com/p/2262982630760450

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

一次开源一次爽,一直开源一直爽。

StabilityAI又双叒叕放大!

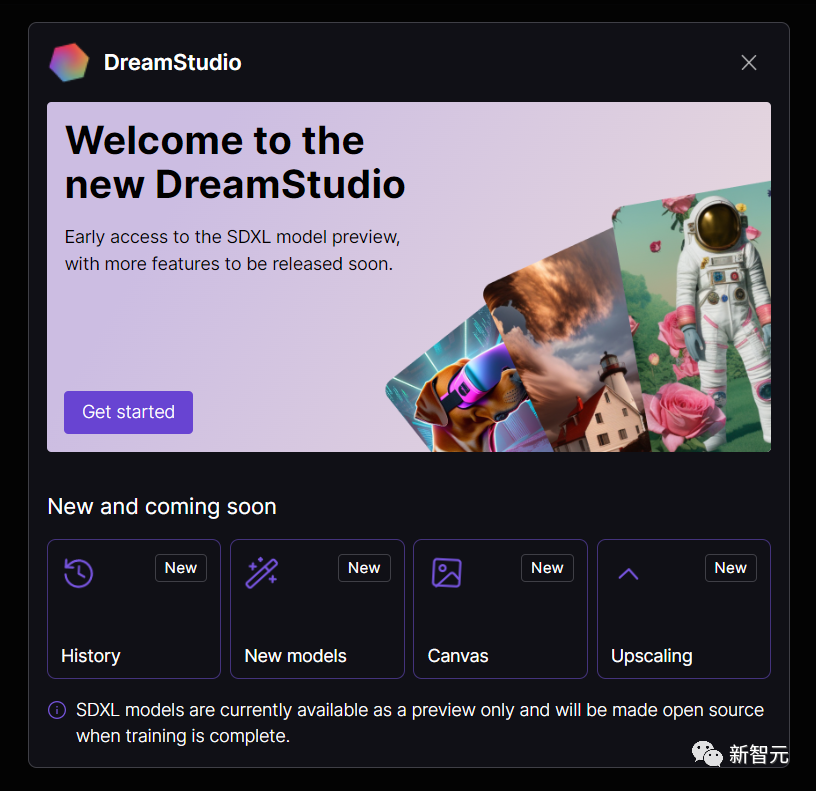

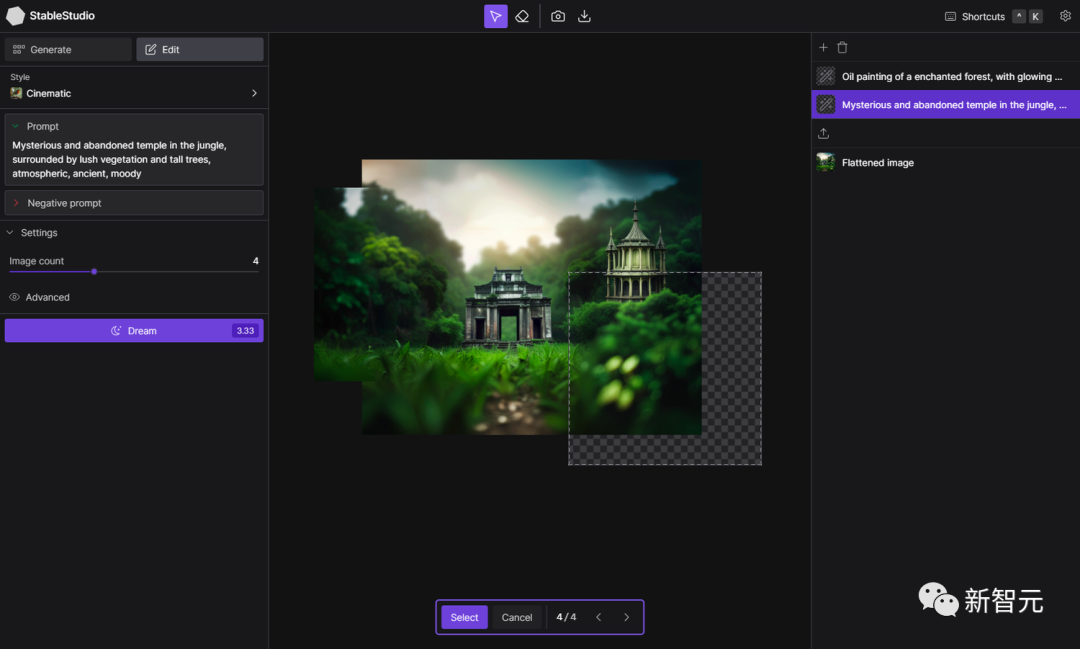

就在昨天,StabilityAI在官网上重磅宣布——旗下的文生图应用DreamStudio开源了!开源产品更名为StableStudio。

据官网介绍,此次开源意味着StabilityAI的图片生成产品线迈入一个全新的篇章,也展现出了StabilityAI推广开源模型的决心。

AI的尽头是开源

自从Stable Diffusion发布以来,DreamStudio就是StabilityAI最主要的应用,用来展示最新的模型和功能。

最近,DreamStudio来了一波升级,改用了StabilityAI最新的图像生成模型——SDXL。

原本该应用的功能就是一个平台,让广大用户能用上生成图片的AI模型。到目前为止,用户得生成了少说成百上千的图片。

而此次发布的重磅炸弹,是因为StabilityAI相信,最好的推广生图模型的方式,就是开源,发展社群,而非闭关锁国。

诚如LeCun所说,AI发展的尽头是开源。

StabilityAI表示,他们的目标是和更多开发者社区建立合作关系,打造一个完全由用户控制的生成性AI的界面。

虽说DreamStudio将继续负责StableStudio的运营,但StabilityAI的目标是把StableStudio打造成一个独立的项目。

而且,StabilityAI的野心可不小,誓要把StableStudio搞的比任何一个独立公司都要牛。

追溯起DreamStudio的起源,它最初是Disco Diffusion下的一个动画工作室。随着去年夏天Stable Diffusion的发布,Disco Diffusion的重点也从动画转到了图像生成。

StabilityAI的目标就是为生成性AI创造一个强大的多模式体验,该公司一直在为这个目标而努力。

因此,StabilityAI在最新的StableStudio项目中公布了即将推出的聊天界面——

人手一个Midjourney?

在今年3月,DreamStudio也是发布了最新的一次更新。

新的稳定扩散微调(Stable unCLIP 2.1, Hugging Face),分辨率为768x768,基于SD2.1-768。

这个模型允许图像变化,以及混合操作。

由于其模块化,可以与其他模型,如KARLO,进行结合。这里面有两个变体:Stable unCLIP-L和Stable unCLIP-H,它们分别以CLIP ViT-L和ViT-H图像嵌入为条件。

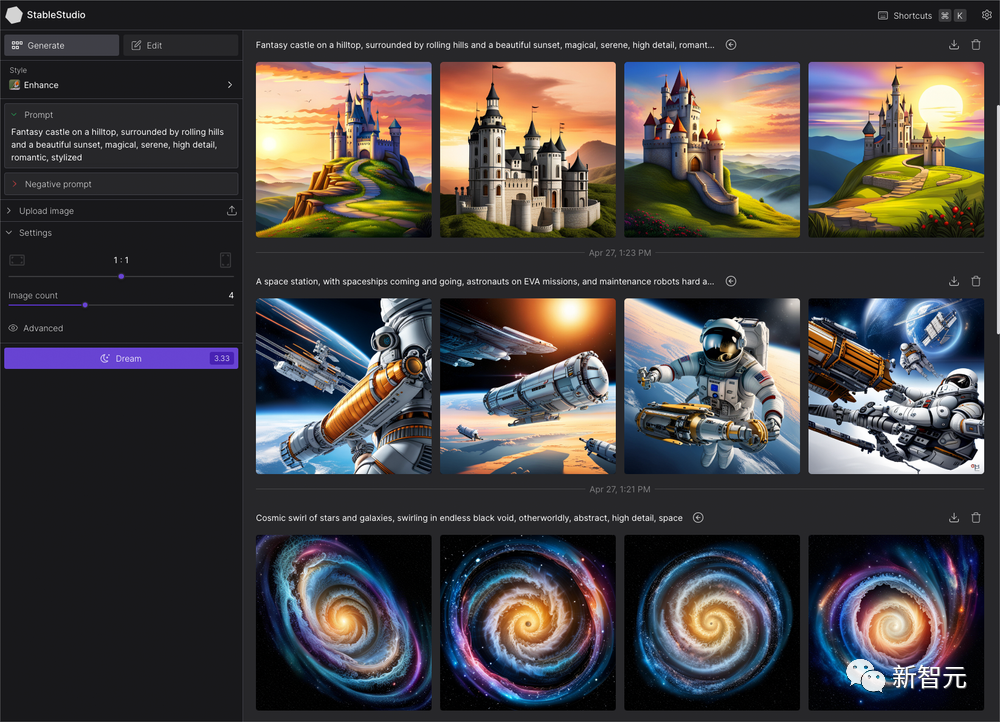

再来看看几组StableStudio生成的图片。

不得不说,和Midjourney比真是不遑多让。

开源——StabilityAI的优良传统

而开源,一向是Stable家族的传统。

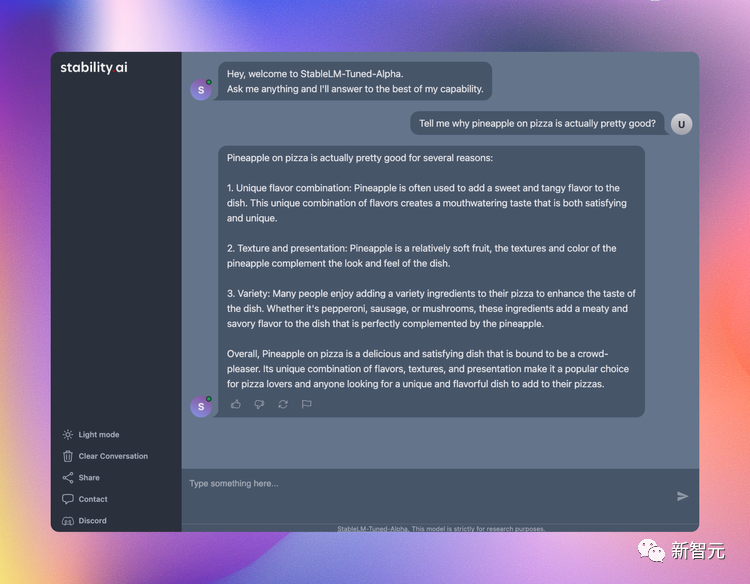

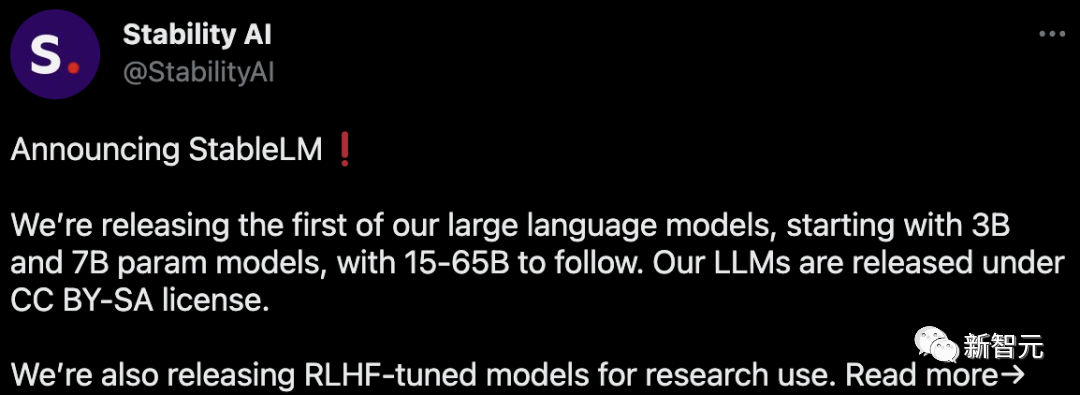

就在上个月,Stability AI宣布推出他们的第一个大语言模型——StableLM。

划重点:它也是开源的,在GitHub上已经可用。模型从3B和7B参数开始,随后会有15B到65B的版本。

并且, Stability AI还发布了用于研究的RLHF微调模型。

项目地址:https://github.com/Stability-AI/StableLM/

Stability AI官方声称:Alpha版本的StableLM有30亿和70亿个参数,之后还有150亿到650亿参数的后续版本。

StabilityAI还豪横地表示,开发者随便用。只要遵守相关条款,不管是检查、应用还是改编基础模型,想怎么来怎么来。

StableLM功能强大,不光可以生成文本和代码,还能给下游应用提供技术基础。它是一个很好的范例,展示了小型、高效的模型通过适当训练就可以有足够高的性能。

早年间,Stability AI和非营利性研究中心Eleuther AI一起开发过早期的语言模型,可以说,Stability AI积淀很深。

像什么GPT-J、GPT-NeoX和Pythia,这都是两家公司合作训练的产物,在The Pile开源数据集上训练完成。而后续的更多开源模型,比如Cerebras-GPT和Dolly-2都是上面三兄弟的后续产品。

说回StableLM,它是在建立在The Pile基础上的新数据集上训练的,该数据集包含1.5万亿个token,大约是The Pile的3倍。模型的上下文长度为4096个token。在即将发布的技术报告中,Stability AI会公布模型的规模和训练设置。

作为概念验证,团队用斯坦福大学的Alpaca对模型进行了微调,并使用了最近的五个对话代理的数据集的组合:斯坦福大学的Alpaca、Nomic-AI的gpt4all、RyokoAI的ShareGPT52K数据集、Databricks labs的Dolly和Anthropic的HH。这些模型将作为StableLM-Tuned-Alpha发布。

当然,这些微调过的模型仅仅用于研究,属于非商业性质。后续,Stability AI还将会公布新数据集的更多细节。

其中,新数据集十分丰富,这也是为什么StableLM的性能很棒。虽说参数规模目前来看还是有点小(和GPT-3 1750亿个参数相比是这样的)。

Stability AI表示,语言模型是数字时代的核心,我们希望每个人都能在语言模型中有发言权。而StableLM的透明性。可访问性、支持性等特点也是践行了这个观念。

Stability AI表示,目前这些模型已经在GitHub公布,未来还会有完整的技术报告问世。Stability AI期待和广泛的开发者和研究人员进行合作。同时,他们还表示将启动众包RLHF计划,开放助手合作,为AI助手创建一个开源的数据集。

随着StableLM的推出,可以说Stability AI在用AI造福所有人的路上越走越远了。

毕竟,开源一向是他们的优良传统。

在2022年,Stability AI提供了多种方式让大家使用Stable Diffusion,包括公开demo、软件测试版和模型的完整下载,开发人员可以随意使用模型,进行各种集成。

作为一个革命性的图像模型,Stable Diffusion代表着一个透明、开放和可扩展的专有AI替代方案。显然,Stable Diffusion让大家看到了开源的各种好处,当然也会有一些无法避免的坏处,但这无疑是一个有意义的历史节点。

https://stability.ai/blog/stablestudio-open-source-community-driven-future-dreamstudio-release

本文来自微信公众号“新智元”(ID:AI_era),作者:拉燕,36氪经授权发布。

该文观点仅代表作者本人,36氪平台仅提供信息存储空间服务。

Recommend

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK