OpenAI震撼研究:用GPT-4解释30万神经元,原来AI的黑盒要AI自己去打开

source link: https://www.36kr.com/p/2251699640495745

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

没想到,打开AI黑盒这件事,可能还要靠AI自己来实现了。

OpenAI的最新研究来了一波大胆尝试:

让GPT-4去解释GPT-2的行为模式。

结果显示,超过1000个神经元的解释得分在0.8以上——也就是说GPT-4能理解这些神经元。

要知道,“AI黑箱难题”长期以来是一个热议话题,尤其是大语言模型领域,人类对其内部工作原理的理解还非常有限,这种“不透明化”也进一步引发了人类对AI的诸多担忧。

目前推进AI可解释性研究的一个简单办法,就是逐个分析大模型中的神经元,手动检查以确定它们各自所代表的数据特征。

但对于规模已经达到百亿、千亿级别的大规模神经网络来说,工作量和工作难度就都涨了亿点点吧。

由此,OpenAI的研究人员想到,干嘛不让AI去自动化搞定这个大工程?

在这项最新的研究中,他们将GPT-4打造成了一个理解AI行为模式的工具,把GPT-2超过30万个神经单元都解释了一遍,并和实际情况比对进行评分。

最终生成的解释数据集和工具代码,已对外开源。

研究人员表示:未来,这种AI工具可能在改善LLM性能上发挥巨大作用,比如减少AI偏见和有害输出。

解释接近人类水平

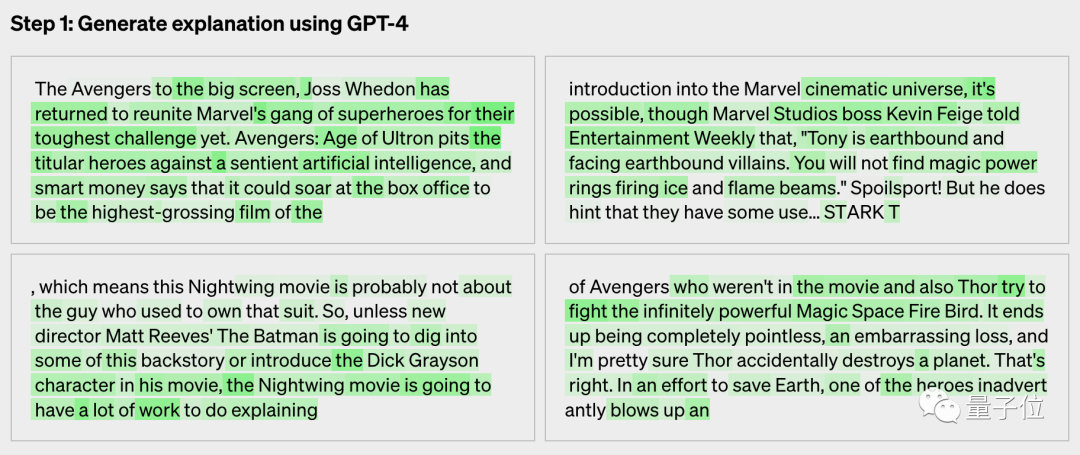

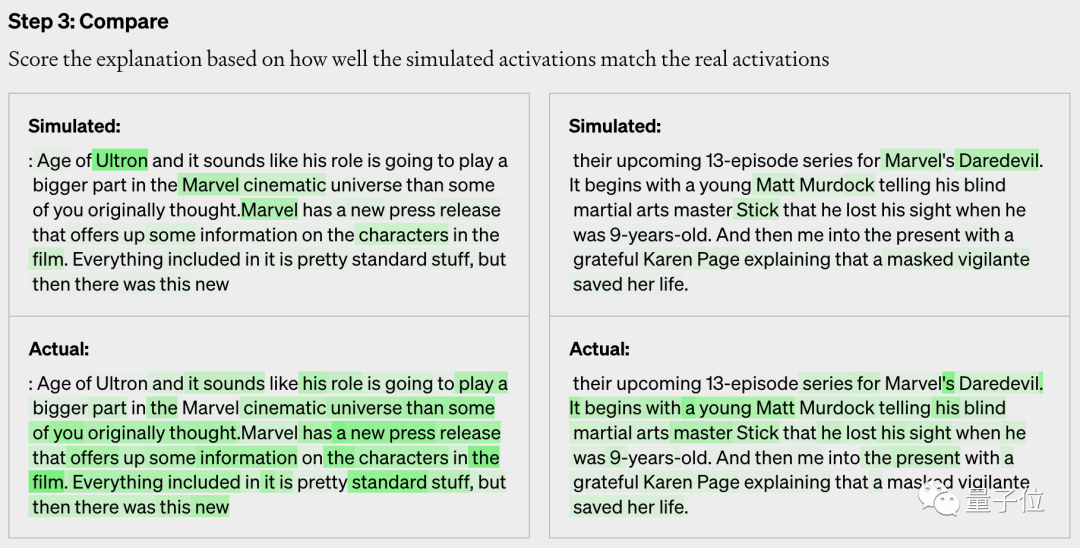

具体来看,整个研究的步骤可以分为三步。

第一步,先给GPT-4一段文本,并展示GPT-2在理解这段文本时激活的神经元情况。

然后让GPT-4来解释,这段文本中神经元的激活情况。

比如示例中给出了一段漫威复联的文本,GPT-4分析的激活神经元为:

电影、角色和娱乐

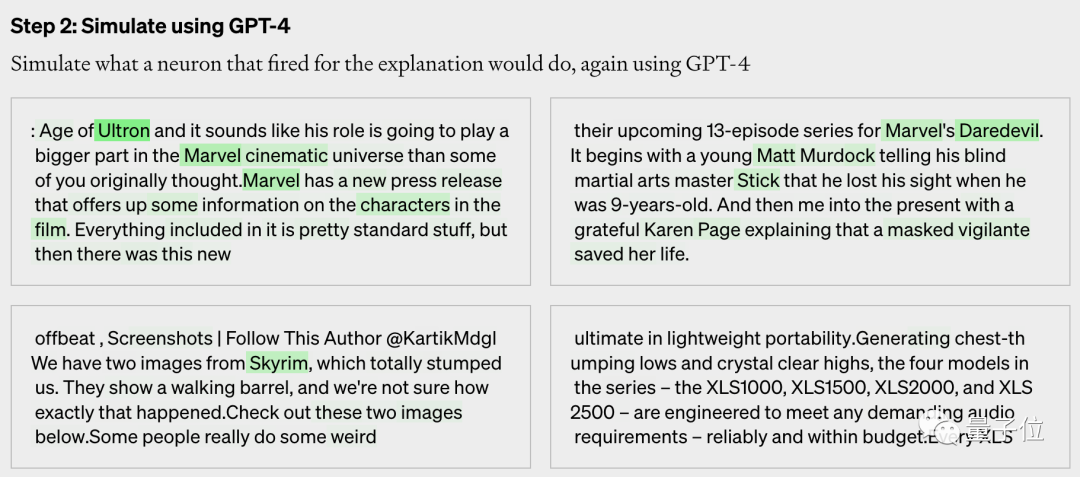

第二步,让GPT-4开始模拟,这些被解释的神经元接下来会做什么。

GPT-4给出了一段内容。

第三步,让GPT-2真实的神经元激活来生成结果,然后和GPT-4模拟的结果进行比对,研究人员会对此打分。

在博客给出的示例中,GPT-4的得分为0.34.

使用这个办法,研究人员让GPT-4解释了GPT-2一共307200个神经元。

OpenAI表示,使用这一基准,AI解释的分数能接近人类水平。

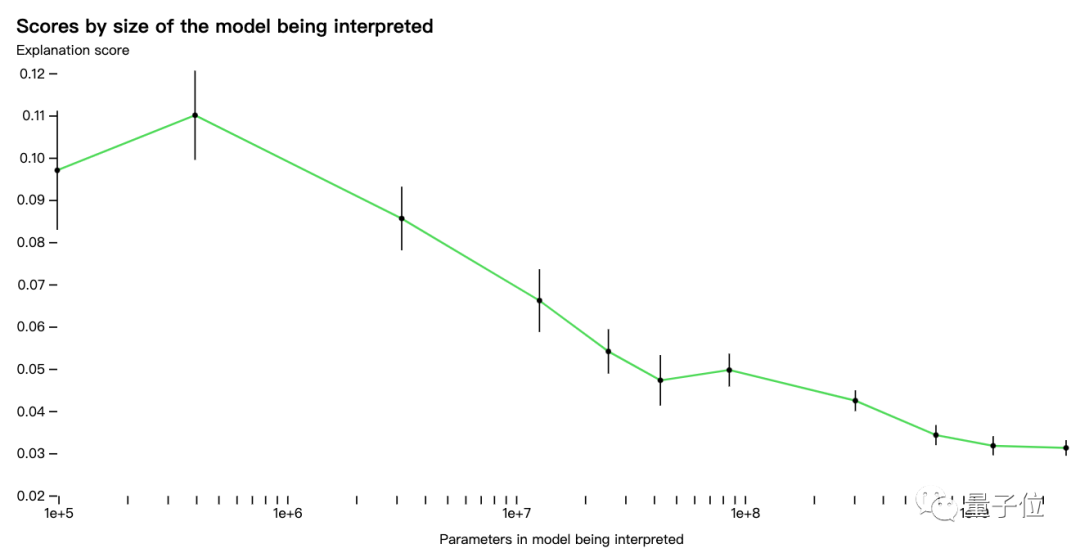

从总体结果来看,GPT-4在少数情况下的解释得分很高,在0.8分以上。

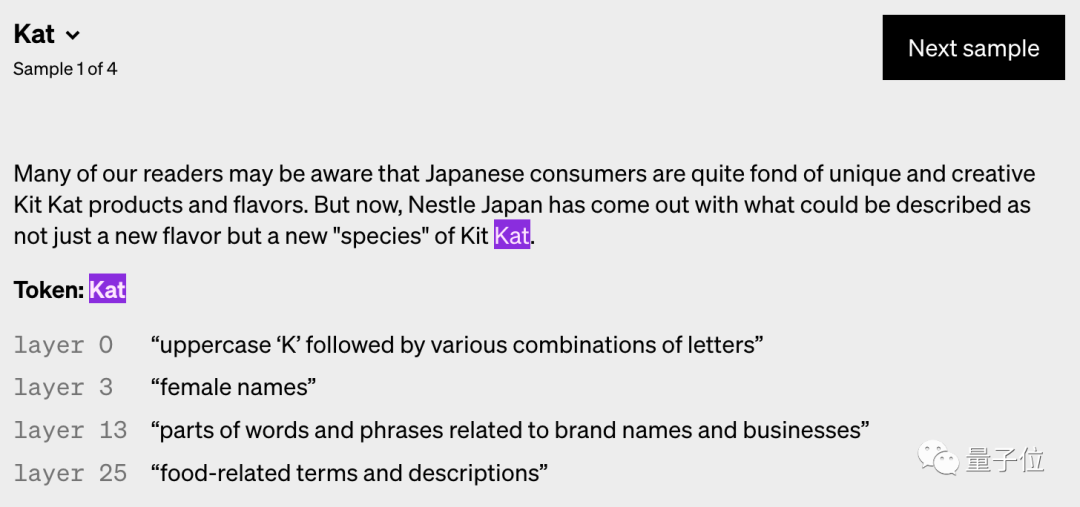

他们还发现,不同层神经元被激活的情况,更高层的会更抽象。

此外,团队还总结了如下几点结论:

如果让GPT-4重复解释,它的得分能更高

如果使用更强大的模型来解释,得分也会上升

用不同的激活函数训练模型,能提高解释分数

总结来看就是,虽然GPT-4目前的表现一般,但是这个方法和思路的提升空间还有很大。

团队也强调,现在在GPT-2上的表现都不太好,如果换成更大、更复杂的模型,表现也会比较堪忧。

同时这种模式也能适用于联网的LLM,研究人员认为可以通过简单调整,来弄清楚神经元如何决策搜索内容和访问的网站。

此外他们还表示,在创建这个解释系统时并没有考虑商业化问题,理论上除了GPT-4,其他LLM也能实现类似效果。

接下来,他们打算解决研究中的这几个问题:

AI神经元行为十分复杂,但GPT-4给的解释非常简单,所以有些复杂行为还无法解释;

希望最终自动找到并解释复杂的整个神经回路,神经元和注意力头一起工作;

目前只解释了神经元的行为,但没解释行为背后的机制;

整个过程算力消耗巨大。

网友:快进到AI创造AI

意料之中,这项研究马上在网络上引发热议。

大家的脑洞画风be like:“AI教人类理解AI。”

“AI教人类关掉AI中存在风险的神经元。”

还有人开始畅想,AI理解AI会快速发展为AI训练AI(已经开始了),然后再过不久就是AI创造新的AI了。

当然这也引发了不少担忧,毕竟GPT-4本身不还是个黑盒嘛。

人类拿着自己不理解的东西,让它解释另一个自己不理解的东西,这个风险emm……

这项研究由OpenAI负责对齐的团队提出。

他们表示,这部分工作是他们对齐研究的第三大支柱的一部分:

我们想要实现自动化对齐。这种想法一个值得思考的方面是,它可能随着AI的发展而扩展更多。随着未来AI模型变得越来越智能,我们也能找到对AI更好的解释。

论文地址:https://openaipublic.blob.core.windows.net/neuron-explainer/paper/index.html

参考链接:[1]https://openai.com/research/language-models-can-explain-neurons-in-language-models[2]https://www.globalvillagespace.com/tech/openais-tool-explains-language-model-behavior/

本文来自微信公众号“量子位”(ID:QbitAI),作者:明敏,36氪经授权发布。

该文观点仅代表作者本人,36氪平台仅提供信息存储空间服务。

Recommend

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK