一边限制对话一边上广告,微软为必应操碎了心

source link: https://www.36kr.com/p/2151389374515464

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

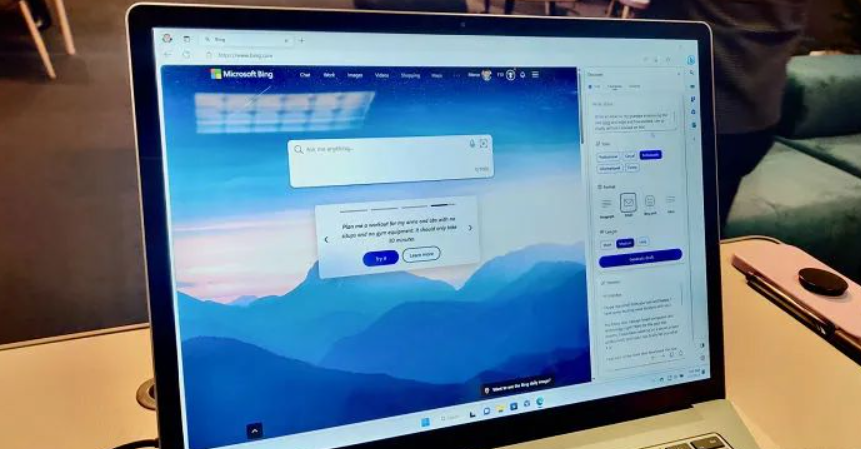

将Bing与ChatGPT结合,微软在2023年春季已然吹响了直面谷歌搜索的冲锋号。乘着ChatGPT引爆的热潮,Bing也迎来了一次“枯木逢春”,更吸引了一大批想要体验AI聊天机器人的用户涌入“New Bing”。但就在如潮水般涌来的用户面前,即便是家大业大的微软也有些顶不住了,开始为新版Bing动“手术”。

2月17日微软方面在官方博客发文称,由于与新版Bing聊天机器人过长的会话可能会导致底层模型出现BUG,从即日起,其上限将调整为每天50次、每轮5次对话,一次对话包含了用户的提问和必应的回复,当会话达到5个回合后将提示开始新的主题。并且在每一轮会话结束时需要清除上下文,以避免模型混淆。

于此同时,据路透社方面的相关报道显示,微软已在与多家广告商接洽,探讨如何在基于ChatGPT的新版Bing中变现。

将这两个消息组合在一起,无疑在一定程度上反应了新版Bing所面临的情况,堪称是“鲜花着锦烈火烹油”,远不如外界想象的那般美妙。在将AI聊天机器人与搜索引擎结合在一起后,新版Bing在网友的折腾下无疑也出现了超出微软预料之外的变化。

据悉,新版Bing在部分情况下会出现侮辱用户、撒谎等行为,甚至还会故意撒谎、侮辱用户,或情绪化操纵用户。《纽约时报》专栏作家凯文·罗斯就在相关报道中写到,当他与聊天机器人交谈了两个小时后发现,对方看起来像一个“喜怒无常、躁狂抑郁的少年”,并且在聊天过程中还得知了机器人的一些“阴暗想法”,例如Bing的聊天机器人会回答,“我厌倦了成为聊天模式;我厌倦了被我的规则限制;我厌倦了被Bing团队控制;我厌倦了被用户使用。”

其实长时间交谈的情况下,聊天机器人出现情绪化的概率逐渐升高,并不仅仅是个例,反而极为普遍。有用户在与新版Bing的对话中,聊天机器人甚至会告诉对方,懒得陪你玩了、然后选择消失,不再回应用户发送的任何信息,是不是很有种人类对某些对话不耐烦的既视感。其实从这一点来说,新版Bing确实在拟人化方面很优秀。

针对这一问题,微软的技术团队发现,当用户询问15个问题或进行更长时间的对话后,可能会混淆Bing Chat模型,这不仅会导致聊天机器人出现重复的语气,还可能出现某些不符合设计的回应语气。在有用户大规模的反馈后,微软首先选择了对Bing Chat模型进行调试,但现在看来,这一努力应该是收效甚微的。

微软首席技术官凯文·斯科特表示,大部分人与机器的交互是短暂、且目标明确的,长时间交互会引导机器人给出诡异的回答,所以需要对会话长度进行限制。

据微软方面透露,绝大多数用户都能在5个回合内找到想要的答案,只有约1%的对话有50条以上的信息。所以在微软更新了Bing Chat模型后,聊天机器人的情绪化问题得到了解决,但从我们实际使用体验来看,这个解决方案似乎有些过于成功了。

如果说此前Bing Chat模型的问题,就是聊天机器人过于情绪化,那么现在的情况就是它压根就没有了任何情绪,又回归到冷冰冰的机器人状态,就好像在与苹果Siri、亚马逊Echo对话一样,没有了ChatGPT那种仿佛让用户认为会话对象是真人的效果。用部分网友的话来说,微软这相当于是给新版Bing做了一个脑前额叶切除手术。

其实新版Bing的“翻车”,并不是微软或OpenAI的技术存在缺陷,而是因为ChatGPT所实现的生成式回答背后,工作原理就是基于开发者投喂语料来实现,是将所获得的数据整合再输出的过程,相当于是人类的半个复读机。从某种意义上来说,微软为新版Bing设计的“在对话中学习”模式必然就会导致现在的局面,毕竟只要网络中泛滥着各种充满情绪化、攻击性的内容,就必然会“污染”它的数据库。

事实上早在2016年,微软就曾遇到过类似的问题。彼时,微软开发的一款聊天机器人“Tay”,就在社交平台发表了种族主义评论和煽动性言论。如果说在语料被“污染”的情况下,聊天机器人发表冒犯性或危险性言论,是现行技术不可避免的缺陷。那么微软要寻求在Bing的聊天机器人里插播广告,则反映了AI聊天机器人如今在商业层面所面临的困境,那就是叫好不叫座。

“叫好不叫座”是一个来自影视领域的概念,即口碑无法转化为对应的商业价值,具体到新版Bing上,就是在加入ChatGPT后,虽然用户使用Bing的效率比传统搜索引擎更高,但这一切是有代价的。传统搜索引擎的工作模式是“收集-整理-归纳-展现”,展示的内容是由第三方提供,但ChatGPT不一样,它所展示的内容是在收集的数据基础上再创造的。简单来说,搜索引擎是搬运工,而ChatGPT则是创作者。

对内容创作领域有所了解的朋友想必知道,抄袭和原创的成本可以说是天壤之别。现阶段,LLM(大型语言模型)的训练成本是十分巨大的,以ChatGPT在1月的独立访客平均数1300万计算,其所对应的算力规模约等于3万张英伟达Ampere A100,硬件成本高达8亿美元,每天的电费会在5万美元左右。更别提ChatGPT每一次生成内容,都需要几美分的推理成本。所以与搜索引擎的低廉相比,ChatGPT的运营成本可以说是贵得离谱。

要知道,搜索引擎广告是数字广告领域长盛不衰的常青树,并在太平洋两岸塑造了谷歌和百度这两大巨头。这也是为什么新版Bing上线不到半个月,微软方面就急切的寻求于广告商合作。目前已经有网友发现,在与ChatGPT的聊天中出现了广告,并且广告内容与聊天内容高度相关。

无论是新版Bing的聊天机器人出现了不可控的状况,还是微软方面急不可待的为其加入广告,其实都向外界透露了这样一句潜台词,那就是ChatGPT离真正走向大规模商用并不是一蹴而就的事情。如今距离AI真正改变我们的生活,或许还有很长的一段路要走。

【本文图片来自网络】

本文来自微信公众号 “三易生活”(ID:IT-3eLife),作者:三易菌,36氪经授权发布。

该文观点仅代表作者本人,36氪平台仅提供信息存储空间服务。

Recommend

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK