清华大学周伯文:ChatGPT火爆揭示新一代协同与交互智能的高度重要性

source link: https://www.51cto.com/article/746202.html

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

清华大学周伯文:ChatGPT火爆揭示新一代协同与交互智能的高度重要性

以下为周伯文在机器之心 AI 科技年会上的演讲内容,机器之心进行了不改变原意的编辑、整理:

谢谢机器之心的邀请,我是来自清华大学的周伯文。现在正是农历年底,也是公历年初,很高兴有这样一个邀请,与大家分享我们对过去一段时间人工智能发展趋势的总结,以及对未来的一些思考。

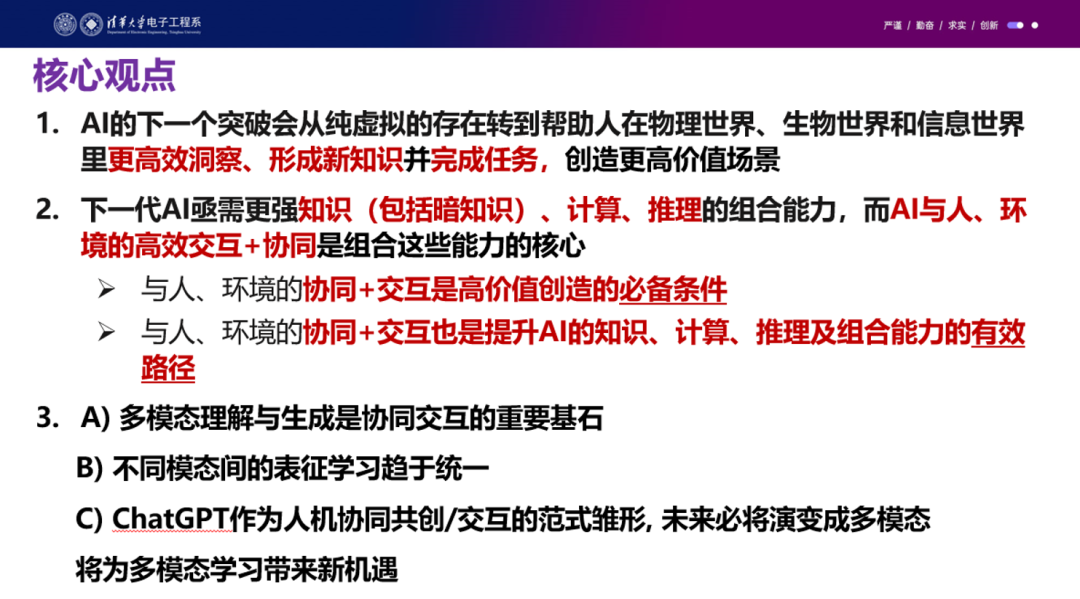

首先将核心想法分享出来,如果整个演讲听下来只能记住三点,请记住这三点:

第一,人工智能的下一个突破会从纯虚拟的存在转到帮助人在物理世界、生物世界和信息世界更高效洞察并形成新知识、完成任务,创造更高价值场景。

第二,下一代人工智能亟需加强知识(包括暗知识)、计算、推理的组合能力。这种组合能力非常重要,但我们认为人工智能与人、环境的高效交互+协同是组合这些能力的核心。

原因有二:一是因为与人和环境的协同和交互是高价值创造的必备条件,如果没有 AI 和人的协同,AI 没办法独立完成这些高价值场景;二是因为这种协同和交互也是提升 AI 在知识、计算、推理及组合能力的有效路径。目前 AI 在计算方面进展很大,但在知识和推理及模块的有效组合之间还存在很大的瓶颈。将人和环境的协同和交互加进来,能够帮助去弥补 AI 在这些方面的一些瓶颈。

第三,关于多模态我们有三个判断:一,多模态理解与生成是协同和交互的重要基石;二,过去两年间,不同模态之间的表征学习趋于统一,这是一个非常好的基础条件;三,最近大热的 ChatGPT 作为人机协同共创和交互的未来范式雏形,未来必将演变成多模态,将为多模态学习带来新机遇。尽管它还有很多很幼稚的地方,但这种这种范式的呈现给我们点明了未来的方向。

上述就是核心观点。在今天的报告中,我会讲一下协同交互智能与多模态学习,回顾最新的进展和机遇。

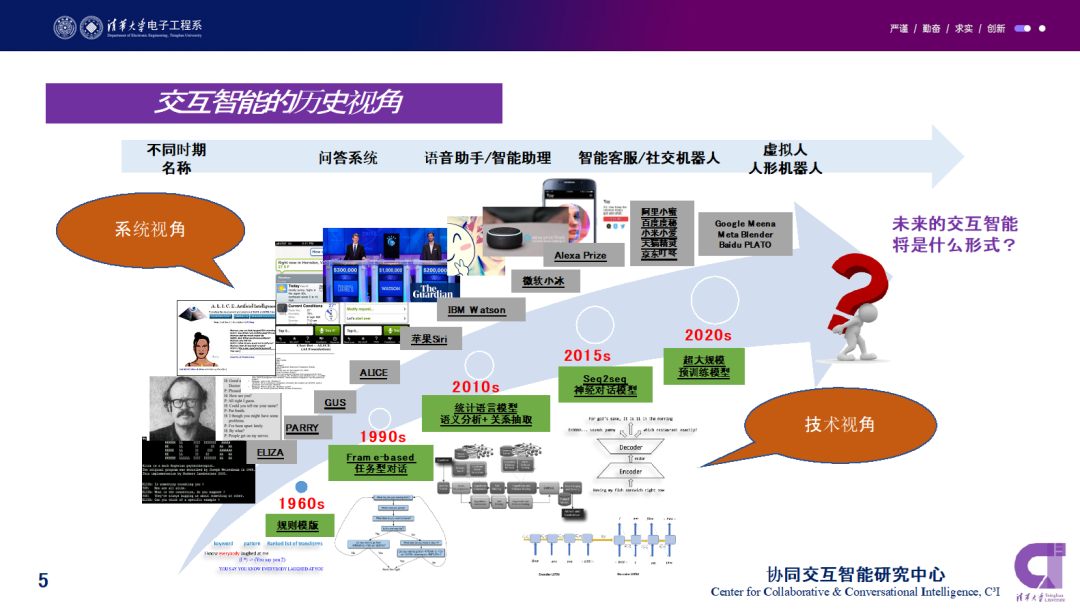

第一部分,从传统上的交互智能来说,我们走了很长的路。首先想强调,今天讲的协同和交互,跟原来的交互智能是截然不同的东西。历史上的交互更多是给定一个训练好的系统,把交互作为一个任务去完成,比如从 ELIZA 、IBM Watson、微软小冰、Siri 到京东的智能客服。今天讲的协同和交互,是把交互作为一个学习手段,把协同作为 AI 和人的分工,更好地完成人机协同融合,去洞察、形成新知识并完成任务。这是整个交互智能的历史视角。可以观察到,驱动进展的是技术视角的变化,包括从早期的规则模板到 Frame-based 任务型对话,再到统计语言模型、Seq2seq Model 、超大规模预训练模型的产生。

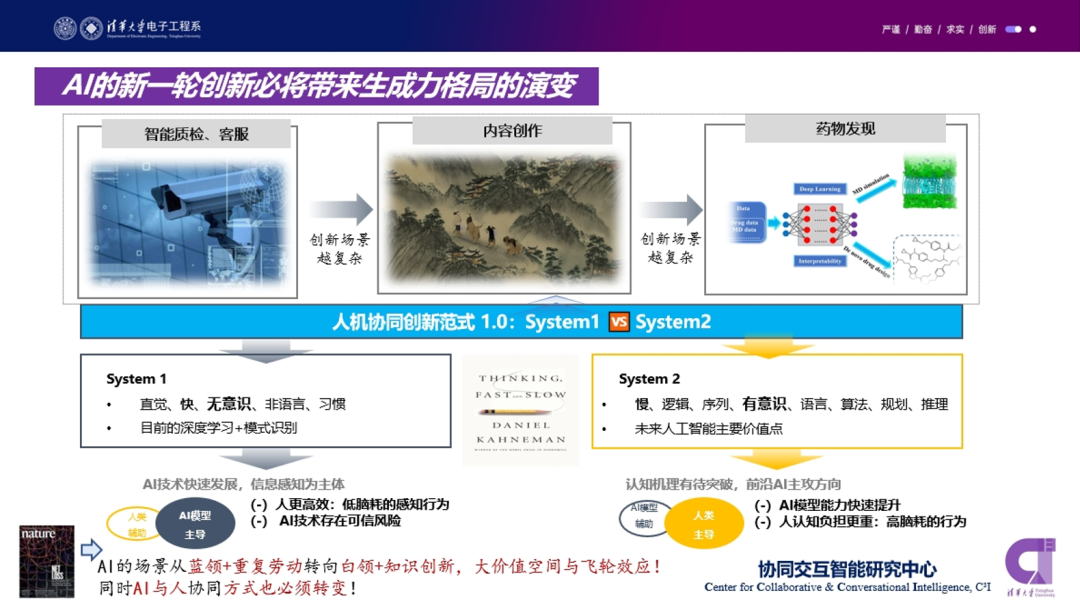

对于这些变化,我们有一个判断是, AI 的新一轮创新必将带来生产力格局的演变。几年前,大家更多在讲人工智能落地应用场景,聚焦在比如智能质检、客服这些领域。但现在我们看到, AI 的创新场景越来越复杂,开始涉及艺术内容创造、药物发现和新知识发现。2002 年诺贝经济学奖得主丹尼尔·卡尼曼的一本畅销书《Thinking Fast And Slow》(思考,快与慢)提出了人的思考方式有两类:系统 1 的特点是直觉无意识,系统 2 有语言、算法、计算、逻辑在里边。

过去几年,人工智能更多用在系统 1 的场景里面,但未来包括现在正在发生的是,人工智能其实更善于且更适合从人机协同的角度去承担更多的系统 2 的工作。因为系统1对人来说更高效,它是一个低脑耗、低认知负担的一个任务,而系统 2 对人来说的认知负担非常重。只不过以前人工智能的技术进展只能做系统 1,系统 2 做得不好,现在的趋势是 AI 越来越向系统 2 靠拢。

从产业闭环的角度来讲,AI 场景从过去蓝领加重复劳动(质检、客服等)变成了白领加知识创新的应用领域。毫无疑问,这将带来更大的价值空间,同时带来更多飞轮效应。什么叫飞轮效应?就是 AI 能够帮助白领和知识工作者更好地去理解、洞察并形成新的知识。新的知识会帮助设计出更好的 AI ,更好的 AI 又能产生更多的新知识。

在这种趋势下,我们必须清晰地认识到, AI 和人的协同方式必须转变,因为 AI 不再是原来的系统 1 的 AI,而是变成系统 2 的 AI。在这种情况下,AI 应该怎样协同和交互,是一个需要去思考的前沿问题。

为什么说 AI 需要具备知识、计算、推理的组合的能力?这里有一些多模态计算的例子,给大家参考:

比如左边第一张图,问穿红色夹克的人在比赛结束时大概率会得第几名,答案是第四名。要回答这样的问题,除了图像分割、语义分割要非常准确之外,还需要很多的常识推理和离散推理。这些东西是我们目前的 AI 系统非常非常缺乏的。

再比如第二个例子,是什么让这些椅子能够容易携带?答案是「foldable」(可折叠)。这里也有逻辑推理在里面。像这种系统 2 的挑战,其实需要人工智能更多地迭代和演进。

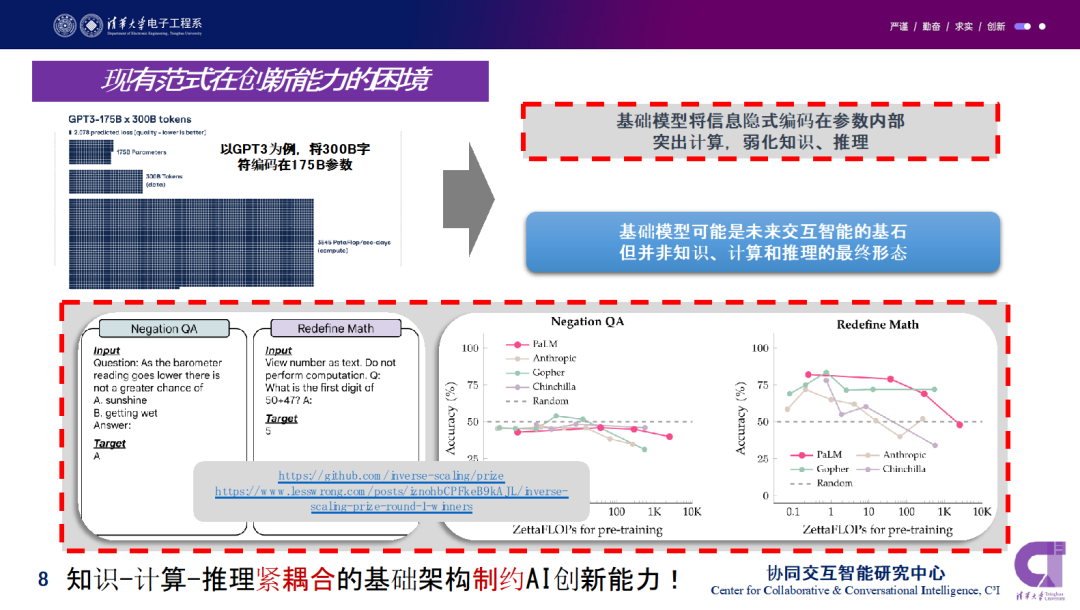

目前大家都知道的一个进展是大规模预训练语言模型的突破。所以很自然的一个问题是,按照这种范式继续往下走,能不能解决高价值应用场景和知识、计算与推理的有效融合?

以 GPT-3 为例,大家都知道它有 1750 亿参数,它将信息编码在参数内部和模型架构里面,突出计算,弱化知识和推理。一方面它在 “Scaling Law” 的支持下,数据越来越多,模型能力越来越强;另一方面, NYU 的几位学者举办了一个叫做 “Inverse Scaling” 的挑战赛,让大家去寻找一些应用场景——模型越大、参数越大,性能表现越差。

上图中有两个例子:一个是叫 Negation QA,就是否定的否定,用双重否定来测试预训练模型的理解和推理能力。另外一个是 Redefine Math,该任务针对现有的数学计算问题,重新定义数学常数,以测试语言模型能否理解其含义并进行正确地计算。从右边两个图大家能看出来,在这些 task 上面,模型参数越大,准确率反而越低。

这些例子其实都指出,基础模型可能是未来交互智能的基石,我个人认为它是一个比「大模型」更重要的词。很重要的一点在于,基础模型并不是最终形态,要去解决碰到的这些问题,还需要更好地具象化。所以我提出,知识、计算和推理的有效组合是接下来非常需要去研究的方向。这种组合很重要的一点就是,人的协同和交互能够推动这些基础模型的升级。

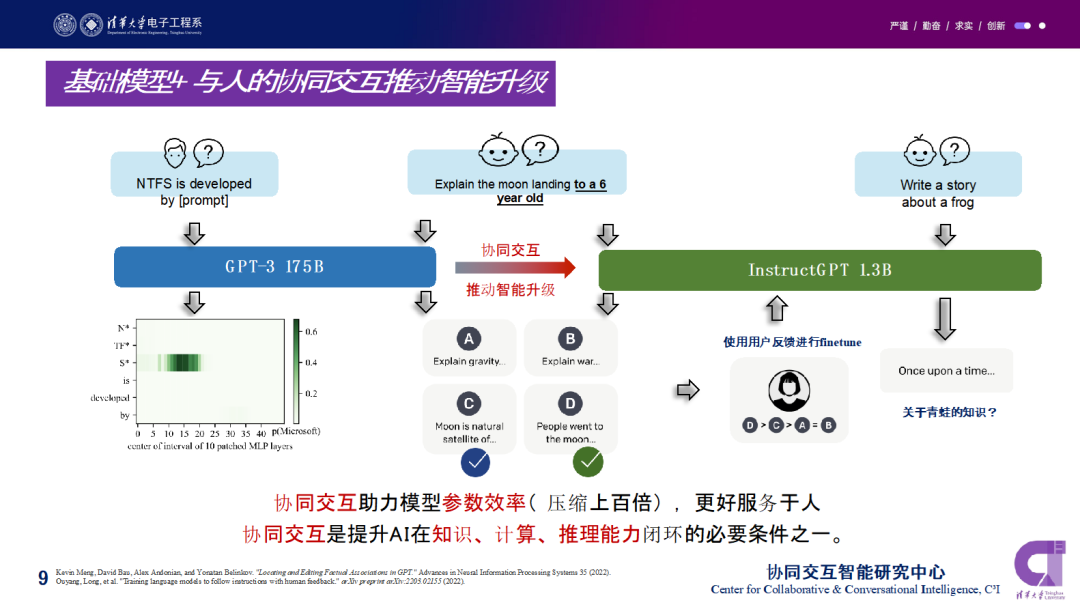

我们用另外一个基于 GPT3 模型「InstructGPT 」的例子来对比:

在某些问题上,GPT-3 可以根据 prompt 学习回答得非常好。但如果你要求给一个 6 岁的小孩解释登月,从 GPT3 的基础模型能力来讲,它有各种角度去回答这个问题,因为它有大量的数值在后面。比如从重力的物理原理开始讲,这是第一种;第二种是从历史背景的角度去讲,登月发生在美苏冷战期间,解释冷战是怎么发生的,如何导致了登月项目;第三种是从天文学的角度去讲,月亮是地球的行星。第四种是从人类的角度开始讲,比如人类一直想登月,中国的嫦娥有很多优美的传说,西方也一样。

但是目前的 GPT3 模型很难判断哪种方式适合向 6 岁的小孩去讲这么一个东西,它更多是基于 frequency 和语料的重要性,很大概率是基于一个 Wikipedia 的页面去解释什么是登月和登月工程,这显然不能很好地服务 context。所以 InstructGPT 就在这个基础上,让用户对 a、b、c、 d 这四类答案去进行选择、打分。给出排序之后,这些反馈可以拿回来微调 GPT3 模型。这样一来,如果接下来再有新的问题,比如「写一个青蛙的故事」,这个模型的开头就会变成 「once upon time」,一个非常适合小朋友听故事的开头方式。

这样带来的结果,第一点是模型毫无疑问更高效了,同时另外一点是它帮助减少了模型参数。InstructGPT 只有 13 亿模型参数,相比于 GPT3 模型压缩了上百倍,但是对特定场景能更好地服务于人。协同交互是提升 AI 在计算知识、计算、推理能力闭环的一个必要条件。

我们认为智能要包含知识、计算、推理三个基础能力。我们看到计算目前进展非常快,当然计算也有算力的挑战和数据的挑战,但在知识和推理方面欠缺尤为明显。

所以这里就提出问题:如何实现三者的闭环?加强 AI 和人、环境的主动协同交互能力,是不是能够更好地帮助 AI 实现三者闭环?我们的学术观点是需要引进 AI 和人、环境的协同与交互,一方面提升每个模块的能力,另一方面将模块进行组合起来去形成协同交互。

呼应一下我们开篇的观点,下一个 AI 的突破会从虚拟的存在转到帮助人在物理世界、生物世界和信息世界更高效洞察新知识并完成任务。

在清华的协同交互智能研究中心,我们主要提出并且在做这些学术问题的研究:

第一个是我们提出新的协同观点,就是我们研究让 AI 更多去负责系统 2,让人更多负责系统1。这带来的第一个挑战就是 AI 本身要更往逻辑推理、高计算、高复合的这种任务上转移,而不是仅仅去做系统 1 的模式识别及直觉的工作。而带来的第二个挑战是,在这种新的分工下,人和 AI 该如何协同。这是两个研究方向。

第二个是在 AI 和人的协同中,要让 AI 更好地去学习人在回路的强化学习。我们要去研究更好的 AI 持续学习,要在 AI 和环境、人的协同里面,做非常多的多模态表征增强的工作。多模态是协同的一个重要渠道,同时要加强对话式交互的增强机制。

还有一种非常重要的协同,就是 AI 和环境的协同。AI 需要适应不同的环境,这些环境适应总结成一句话是:云到边的自适应,边到云的自演化。云到边的自适应大家很容易理解,在不同的算力和通信条件下,如何让这些基础模型更好地适配这些环境;边到云的自演化,其实是让边缘端的智能反向帮助基础模型更好地迭代。换句话讲,这是小模型和大模型之间的一种协同和交互。但是我们不认为这种协同和交互是单向的,只能是大模型通过知识蒸馏、剪枝来获取小模型。我们认为小模型的迭代和交互应该有更有效的路径传导到基础模型上。

我们认为,以上这三个技术路径非常重要。下面会有一个底层的支撑——或许我们现在的研究会带来可信赖人工智能的一些基础理论突破,因为知识、计算、推理进行更好的组合之后,能更好地去解决原来由知识、计算、推理融合成的黑箱的可解释性、鲁棒性、泛化性这些挑战。我们希望通过可分拆又可组合的方式更好地获得这种可信赖人工智能的进步。如果一个人不能透明地看到人工智能推理过程,其实很难相信人工智能的系统 2 的结果。

从另外一个角度来看这个问题。大家知道最近 ChatGPT 非常热,所以我们做很多工作无法绕开 ChatGPT。当然也包括更早一段时间 Facebook 提出的用 AI 帮助写科学论文的一个系统 Galactica。我们发现它们都是需要人和环境的协同来创造场景。这些价值场景原来其实也没有,但现在开始变成了可能。只是这种可能一旦脱离人的协同和交互,我们马上发现这些 AI 系统 fall short。

包括 Galactica ,它能写出非常通畅的论文,但是很多基本事实和引用文献都是错误的。比如作者名字是真的,但是 title 一部分真、一部分假,或者多篇论文被合到一起去了。我想强调的是,目前的 AI 是没有能力去完成这种完整的知识、计算、推理的闭环,所以必须要需要去人 involve。

虽然 Galactica 是马上就下线了,但它的目的不是让大家用它去独立完成论文和科研,而是更好地帮助人,所以人必须在闭环里面。这是另一角度强调了人的协同和交互是非常重要的一个基础条件。

接下来讲在协同交互背景下我如何看多模态学习的进展和新机遇。首先我觉得多模态在最近这段时间进展也非常快,开始带来几个明显的趋势。

首先,在建模和表征结构的维度上,多模态之间在趋同。比如,过去在图像、视频中,大家都是用 CNN,因为文本是 Sequence Model,大家更多是用 RNN 和 LSTM,但现在不管是什么模态,大家都可以把 token 化之后的输入全部当成一个 Sequence 或者 Graph Model ,用自注意力加多头机制来进行处理。最近几年受欢迎的 Transformer 架构,让基本上所有模型的结构都在趋同。

但一个深层的问题在于,为什么 Transformer 的这种架构对所有模态表征都具备优势?我们也有一些思考,结论就是,Transformer 可以在更普适的几何拓扑空间中对不同模态进行建模,进一步降低了多模态之间的建模壁垒。所以 Transformer 的这么一个优势,正好构建了多模态方向上的这种架构趋同性的基础。

其次,我们发现多模态的预训练维度也在趋同。最早的 Bert 是在自然语言领域提出来的,用这种 Mask 的模式引爆了预训练模型。最近的工作,包括何恺明老师的 MAE 工作,包括语音领域的工作都不断地在用类似的 Idea。通过这种 Mask 的方式,在不同的模态之间形成了趋同的预训练模型架构。现在模态间的预训练壁垒也被打通了,预训练模型的维度也进一步趋同了。像 MAE 把 BERT 的预训练方式引入到了视觉、 图像、语音等各个模态里面。所以 Mask 这种机制在多种模态中呈现了普适性。

第三个趋势是预架构参数和预训练目标的统一。目前用 Transformer 架构对文本、图像、音频进行建模,并在多个任务之间可以开始共享参数。

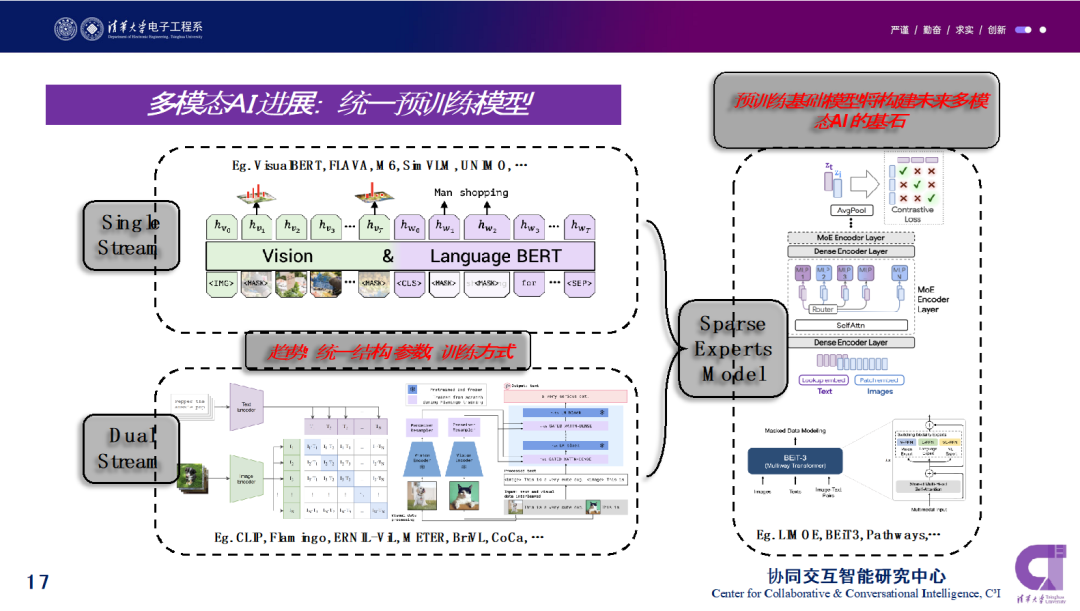

具体来讲,目前的多模态预训练模型主要还是分为单流和双流模型。在单流架构中,我们假设两种模型之间的潜在相关性和对齐性是比较简单的。双流架构假设需要分离模态内部的模态类的交互和跨模态之间的这种交互,来获得更好的多模态表示,能够对于不同的模态信息进行编码融合。

问题在于有没有更好的办法来统一这些思路。目前的趋势是,稀疏性和模块性可能是更强大的多模态、多任务之间的两个关键属性。稀疏的专家模型可以被视为单流和双流之间的一种平衡稀疏的专家模型系统,它能够处理不同专家、不同模态和任务。

我们提的一个问题是,能不能用协同交互的模式,把谷歌 Pathway 模型在特定的这些任务上也进行百倍的压缩,但保留这种稀疏和模块化的结构?这类工作非常值得后续研究。

再回到对话协同交互方面,我认为 ChatGPT 是当前非常重要的一个工作,它的价值核心是在协同交互方向点亮了一个新的里程碑,它能用在学术写作、代码生成、百科问答、指令理解等等工作上。预训练基础模型能够赋予交互智能问答、写作、代码生成等各项能力。ChatGPT 的核心能力提升,是在 GPT 3的基础上加上了人在回路的强化学习,加上了人对不同答案的选择和排序。

虽然目前在 ChatGPT 中的呈现形式是以自然语言为主要载体,但整个交互的模态一定会拓展到这种多模态。人的协同和交互在多模态的场景下,其实会更高效,也会带来更多的信息量,也会带来各种模态的知识的融合。

如果把这些人在回路的协同交互能力和 AI 生成能力融合在一起,还能做非常多的事情。比如协同交互 ChatGPT 模式和 Diffusion Model 融合进行产品创新和设计创新。在协同交互过程中, ChatGPT 这样的模型不断地去寻找当前设计的主流的趋势和特定消费者的喜好,通过对消费者场景情感体验的洞察,对设计趋势、技术趋势的判断,再结合对大量图片的分析,可以通过与设计师或专业的产品经理进行多轮协同交化的方式实现共创。

在一些非常细分的场景下,其实很多人是没有先验知识的,比如智能家居领域,但是人可以通过多轮人机协同交互来生成这些创意设计,再通过 Stable Diffusion Model,将这些人类创意的核心关键词场景体验转化成高保真还原的设计原图。协同交互能够帮助人们进行更高效的产品创新、设计创新,这也是我们衔远科技在做的事情。

多模态的工作越来越重要,因此我们中心牵头发起“大规模多模态学习“ 的 TPAMI 2023特刊,目标是汇集来自多个学科(如:计算机视觉、自然语言处理、机器学习、深度学习、智慧医疗、生物信息学、认知科学)的观点,提出重要的科学问题,并发现研究机会,以应对深度学习和大数据时代多模态学习领域的突出挑战。

Recommend

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK