Go pprof性能调优

source link: https://blog.mailjob.net/posts/603905715.html

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

在计算机性能调试领域里,profiling 是指对应用程序的画像,画像就是应用程序使用 CPU 和 内存 的情况。 Go语言是一个对性能特别看重的语言,因此语言中自带了 profiling 的库,这篇文章就要讲解怎么在 golang 中做 profiling。

PPROF介绍

pprof 可以做什么

- CPU 分析(profile): 你可以在 url 上用

seconds参数指定抽样持续时间(默认 30s),你获取到概览文件后可以用go tool pprof命令调查这个概览 - 内存分配(allocs): 所有内存分配的抽样

- 阻塞(block): 堆栈跟踪导致阻塞的同步原语

- 命令行调用(cmdline): 命令行调用的程序

- goroutine: 当前 goroutine 的堆栈信息

- 堆(heap): 当前活动对象内存分配的抽样,完全也可以指定

gc参数在对堆取样前执行 GC - 互斥锁(mutex): 堆栈跟踪竞争状态互斥锁的持有者

- 系统线程的创建(threadcreate): 堆栈跟踪系统新线程的创建

- trace: 追踪当前程序的执行状况. 你可以用

seconds参数指定抽样持续时间. 你获取到 trace 概览后可以用go tool pprof命令调查这个 trace

pprof的两个标准库

Go语言内置了获取程序的运行数据的工具,包括以下两个标准库:

runtime/pprof:采集工具型应用运行数据进行分析net/http/pprof:采集服务型应用运行时数据进行分析

pprof开启后,每隔一段时间(10ms)就会收集下当前的堆栈信息,获取各个函数占用的CPU以及内存资源;最后通过对这些采样数据进行分析,形成一个性能分析报告。

注意,我们只应该在性能测试的时候才在代码中引入pprof。

go tool pprof命令

不管是工具型应用还是服务型应用,我们使用相应的pprof库获取数据之后,下一步的都要对这些数据进行分析,我们可以使用go tool pprof命令行工具。

go tool pprof最简单的使用方式为:

go tool pprof [binary] [source]- binary 是应用的二进制文件,用来解析各种符号;

- source 表示 profile 数据的来源,可以是本地的文件,也可以是 http 地址。

注意事项: 获取的 Profiling 数据是动态的,要想获得有效的数据,请保证应用处于较大的负载(比如正在生成中运行的服务,或者通过其他工具模拟访问压力)。否则如果应用处于空闲状态,得到的结果可能没有任何意义。

工具型应用

如果你的应用程序是运行一段时间就结束退出类型。那么最好的办法是在应用退出的时候把 profiling 的报告保存到文件中,进行分析。对于这种情况,可以使用runtime/pprof库。 首先在代码中导入runtime/pprof工具:

import "runtime/pprof"CPU性能分析

开启CPU性能分析:

pprof.StartCPUProfile(w io.Writer)停止CPU性能分析:

pprof.StopCPUProfile()应用执行结束后,就会生成一个文件,保存了我们的 CPU profiling 数据。得到采样数据之后,使用go tool pprof工具进行CPU性能分析。

内存性能优化

记录程序的堆栈信息

pprof.WriteHeapProfile(w io.Writer)得到采样数据之后,使用go tool pprof工具进行内存性能分析。

go tool pprof默认是使用-inuse_space进行统计,还可以使用-inuse-objects查看分配对象的数量。

服务型应用

如果你的应用程序是一直运行的,比如 web 应用,那么可以使用net/http/pprof库,它能够在提供 HTTP 服务进行分析。

如果使用了默认的http.DefaultServeMux(通常是代码直接使用 http.ListenAndServe(“0.0.0.0:8000”, nil)),只需要在你的web server端代码中按如下方式导入net/http/pprof

import _ "net/http/pprof"如果你使用自定义的 Mux,则需要手动注册一些路由规则:

r.HandleFunc("/debug/pprof/", pprof.Index)

r.HandleFunc("/debug/pprof/cmdline", pprof.Cmdline)

r.HandleFunc("/debug/pprof/profile", pprof.Profile)

r.HandleFunc("/debug/pprof/symbol", pprof.Symbol)

r.HandleFunc("/debug/pprof/trace", pprof.Trace)如果你使用的是gin框架,那么推荐使用github.com/gin-contrib/pprof,在代码中通过以下命令注册pprof相关路由。

pprof.Register(router)不管哪种方式,你的 HTTP 服务都会多出/debug/pprof endpoint,访问它会得到类似下面的内容:

这个路径下还有几个子页面:

- /debug/pprof/profile:访问这个链接会自动进行 CPU profiling,持续 30s,并生成一个文件供下载

- /debug/pprof/heap: Memory Profiling 的路径,访问这个链接会得到一个内存 Profiling 结果的文件

- /debug/pprof/block:block Profiling 的路径

- /debug/pprof/goroutines:运行的 goroutines 列表,以及调用关系

测试代码如下:

func main() {

// CPU分析

fileC, errC := os.Create("./cpu.pprof")

if errC != nil {

fmt.Printf("create cpu pprof failed, err:%v\n", errC)

return

}

pprof.StartCPUProfile(fileC)

defer pprof.StopCPUProfile()

// 内存分析

fileM, errM := os.Create("./mem.pprof")

if errM != nil {

fmt.Printf("create mem pprof failed, err:%v\n", errM)

return

}

pprof.WriteHeapProfile(fileM)

fileM.Close()

// 业务程序执行

for i := 0; i < 8; i++ {

go chanSelect()

}

time.Sleep(10 * time.Second)

}

func chanSelect() []int {

var c chan int

for {

select {

case v := <-c:

fmt.Printf("recv from chan, value:%v\n", v)

default:

}

}

}等待10秒后会在当前目录下生成一个cpu.pprof 和 mem.pprof 文件。

命令行交互界面

我们使用go工具链里的pprof来分析一下。

go tool pprof cpu.pprof执行上面的代码会进入交互界面如下:

PS G:\go_study\21.pprof> go tool pprof cpu.pprof

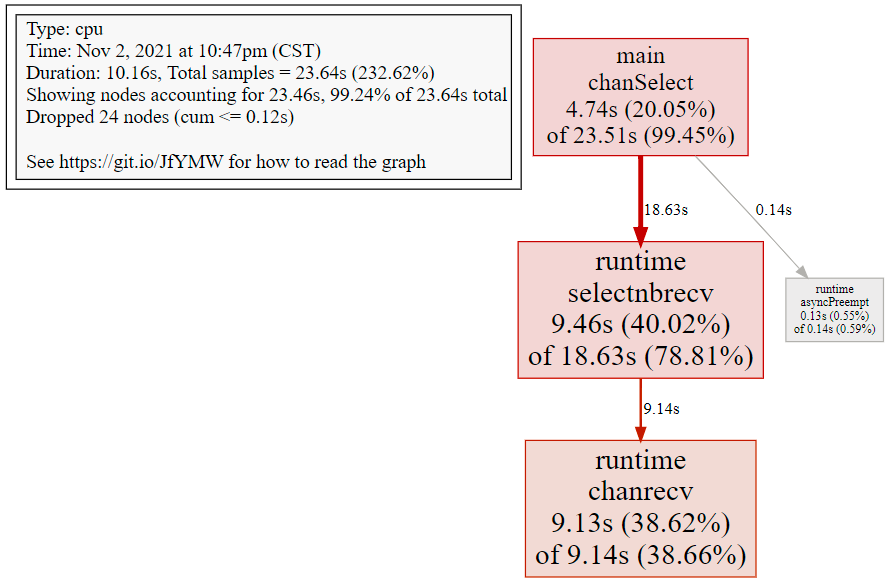

Type: cpu

Time: Nov 2, 2021 at 10:47pm (CST)

Duration: 10.16s, Total samples = 23.64s (232.62%)

Entering interactive mode (type "help" for commands, "o" for options)

(pprof)我们可以在交互界面输入top3来查看程序中占用CPU前3位的函数

我们还可以使用list 函数名命令查看具体的函数分析,例如执行list chanSelect查看我们编写的函数的详细分析。

(pprof) top 3

Showing nodes accounting for 23.33s, 98.69% of 23.64s total

Dropped 24 nodes (cum <= 0.12s)

Showing top 3 nodes out of 4

flat flat% sum% cum cum%

9.46s 40.02% 40.02% 18.63s 78.81% runtime.selectnbrecv

9.13s 38.62% 78.64% 9.14s 38.66% runtime.chanrecv

4.74s 20.05% 98.69% 23.51s 99.45% main.chanSelect

(pprof) list chanSelect

Total: 23.64s

ROUTINE ======================== main.chanSelect in G:\go_study\21.pprof\main.go

4.74s 23.51s (flat, cum) 99.45% of Total

. . 33: }

. . 34: time.Sleep(10 * time.Second)

. . 35:}

. . 36:

. . 37:// 测试代码

. 20ms 38:func chanSelect() []int {

. . 39: var c chan int

. . 40: for {

. . 41: select {

4.74s 23.49s 42: case v := <-c:

. . 43: fmt.Printf("recv from chan, value:%v\n", v)

. . 44: default:

. . 45: }

. . 46: }

. . 47:}名称说明:

- flat:当前函数占用CPU的耗时

- flat::当前函数占用CPU的耗时百分比

- sun%:函数占用CPU的耗时累计百分比

- cum:当前函数加上调用当前函数的函数占用CPU的总耗时

- cum%:当前函数加上调用当前函数的函数占用CPU的总耗时百分比

- 最后一列:函数名称

在大多数的情况下,我们可以通过分析这五列得出一个应用程序的运行情况,并对程序进行优化。

通过分析发现大部分CPU资源被 43 行占用,我们分析出select语句中的default没有内容会导致上面的case v:=<-c:一直执行。我们在default分支添加一行time.Sleep(time.Second)即可。

或者可以直接输入web,通过svg图的方式查看程序中详细的CPU占用情况。 想要查看图形化的界面首先需要安装graphviz图形化工具。

Mac:

brew install graphviz**Windows: **

下载graphviz 将graphviz安装目录下的bin文件夹添加到Path环境变量中。 在终端输入dot -version查看是否安装成功。

如何测试:

在命令行中,可以直接输入 web 或者 png 查看

PS G:\go_study\21.pprof> go tool pprof cpu.pprof

(pprof) web

关于图形的说明: 每个框代表一个函数,理论上框的越大表示占用的CPU资源越多。 方框之间的线条代表函数之间的调用关系。 线条上的数字表示函数调用的次数。 方框中的第一行数字表示当前函数占用CPU的百分比,第二行数字表示当前函数累计占用CPU的百分比。

除了分析CPU性能数据,pprof也支持分析内存性能数据。比如,使用下面的命令分析http服务的heap性能数据,查看当前程序的内存占用以及热点内存对象使用的情况。

# 查看内存占用数据

go tool pprof -inuse_space http://127.0.0.1:8080/debug/pprof/heap

go tool pprof -inuse_objects http://127.0.0.1:8080/debug/pprof/heap

# 查看临时内存分配数据

go tool pprof -alloc_space http://127.0.0.1:8080/debug/pprof/heap

go tool pprof -alloc_objects http://127.0.0.1:8080/debug/pprof/heapgo-torch和火焰图

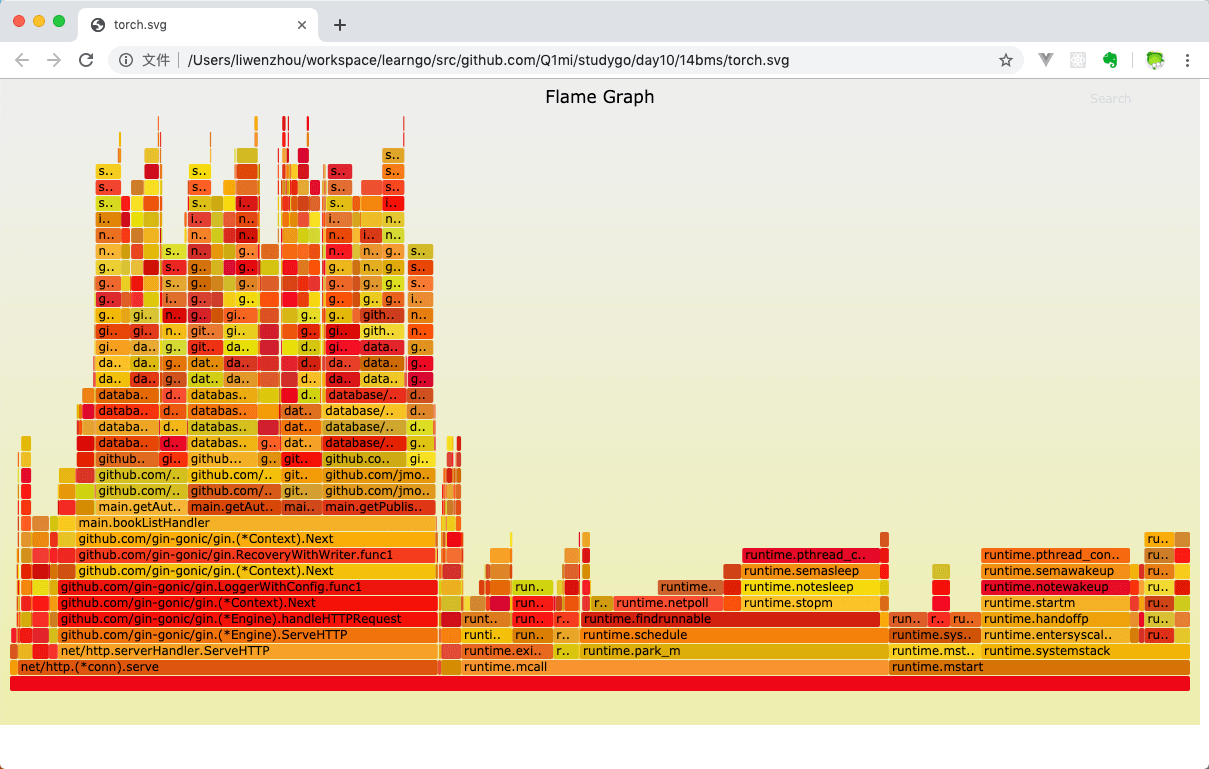

火焰图(Flame Graph)是 Bredan Gregg 创建的一种性能分析图表,因为它的样子近似 🔥而得名。上面的 profiling 结果也转换成火焰图,如果对火焰图比较了解可以手动来操作,不过这里我们要介绍一个工具:go-torch。这是 uber 开源的一个工具,可以直接读取 golang profiling 数据,并生成一个火焰图的 svg 文件。

安装go-torch

go get -v github.com/uber/go-torch火焰图 svg 文件可以通过浏览器打开,它对于调用图的最优点是它是动态的:可以通过点击每个方块来 zoom in 分析它上面的内容。

火焰图的调用顺序从下到上,每个方块代表一个函数,它上面一层表示这个函数会调用哪些函数,方块的大小代表了占用 CPU 使用的长短。火焰图的配色并没有特殊的意义,默认的红、黄配色是为了更像火焰而已。

go-torch 工具的使用非常简单,没有任何参数的话,它会尝试从http://localhost:8080/debug/pprof/profile获取 profiling 数据。它有三个常用的参数可以调整:

- -u –url:要访问的 URL,这里只是主机和端口部分

- -s –suffix:pprof profile 的路径,默认为 /debug/pprof/profile

- –seconds:要执行 profiling 的时间长度,默认为 30s

安装 FlameGraph

要生成火焰图,需要事先安装 FlameGraph工具,这个工具的安装很简单(需要perl环境支持),只要把对应的可执行文件加入到环境变量中即可。

- 下载安装perl:https://www.perl.org/get.html

- 下载FlameGraph:

git clone https://github.com/brendangregg/FlameGraph.git - 将

FlameGraph目录加入到操作系统的环境变量中。 - Windows平台的同学,需要把

go-torch/render/flamegraph.go文件中的GenerateFlameGraph按如下方式修改,然后在go-torch目录下执行go install即可。

// GenerateFlameGraph runs the flamegraph script to generate a flame graph SVG. func GenerateFlameGraph(graphInput []byte, args ...string) ([]byte, error) {

flameGraph := findInPath(flameGraphScripts)

if flameGraph == "" {

return nil, errNoPerlScript

}

if runtime.GOOS == "windows" {

return runScript("perl", append([]string{flameGraph}, args...), graphInput)

}

return runScript(flameGraph, args, graphInput)

}压测工具wrk

推荐使用https://github.com/wg/wrk 或 https://github.com/adjust/go-wrk

使用go-torch

使用wrk进行压测:

go-wrk -n 50000 http://127.0.0.1:8080/book/list在上面压测进行的同时,打开另一个终端执行:

go-torch -u http://127.0.0.1:8080 -t 3030秒之后终端会初夏如下提示:Writing svg to torch.svg

然后我们使用浏览器打开torch.svg就能看到如下火焰图了。

此外还可以借助火焰图分析内存性能数据:

go-torch -inuse_space http://127.0.0.1:8080/debug/pprof/heap

go-torch -inuse_objects http://127.0.0.1:8080/debug/pprof/heap

go-torch -alloc_space http://127.0.0.1:8080/debug/pprof/heap

go-torch -alloc_objects http://127.0.0.1:8080/debug/pprof/heappprof与性能测试结合

go test命令有两个参数和 pprof 相关,它们分别指定生成的 CPU 和 Memory profiling 保存的文件:

- -cpuprofile:cpu profiling 数据要保存的文件地址

- -memprofile:memory profiling 数据要报文的文件地址

我们还可以选择将pprof与性能测试相结合,比如:

比如下面执行测试的同时,也会执行 CPU profiling,并把结果保存在 cpu.prof 文件中:

go test -bench . -cpuprofile=cpu.prof比如下面执行测试的同时,也会执行 Mem profiling,并把结果保存在 cpu.prof 文件中:

go test -bench . -memprofile=./mem.prof需要注意的是,Profiling 一般和性能测试一起使用,这个原因在前文也提到过,只有应用在负载高的情况下 Profiling 才有意义。

Recommend

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK