一个案例,看懂如何分析活动

source link: https://www.yunyingpai.com/data/769283.html

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

无论是面试还是工作,做数据分析的同学都经常遇到“如何分析活动效果”的问题。本文基于某音乐类APP对新用户进行一个新注册即送7天会员权益活动的场景还原,对分析活动效果进行详尽的阐述。从常见错误、关键问题、评估模型的具体方法论三大方面与大家分享经验,推荐感兴趣的同学阅读学习。

一、活动评估常见错误

首先牢记,所有以评估评价判断作为动词的问题,答案只有一种:“好or坏”。

比如,如何评价该活动,可以回答:

- 这个活动很好,该继续做。

- 这个活动不好,不能做。

- 这个活动不好不坏,鸡肋。

- 这个活动没有任何改变,做了也白做。

这才是评估类分析的核心结论。

离开这四句话,其他的都是废话。比如:

- 活动期间有4万新人注册。

- 活动期间注册人数比活动前多1万。

- 活动期间新用户点击率是80%。

- 活动期间新用户使用权益率30%。

这些统统不是结论,只是分析过程而已。如果没有结论,直接甩这些过程指标,很容易遭遇业务方反问:“所以呢?所以呢?你分析了啥?结论呢!”最后被搞得灰头土脸。

二、活动评估关键问题

活动评估,首先要得出好/坏评价。如果评价是好,再看能不能继续做,还能做多少次;如果是评价是差,再看差在哪里,是差得不可救药,还是能拯救一下继续用。

数据+标注=判断。因此想得出好/坏判断,需要有2样东西:

- 明确考核指标。

- 明确目标数值。

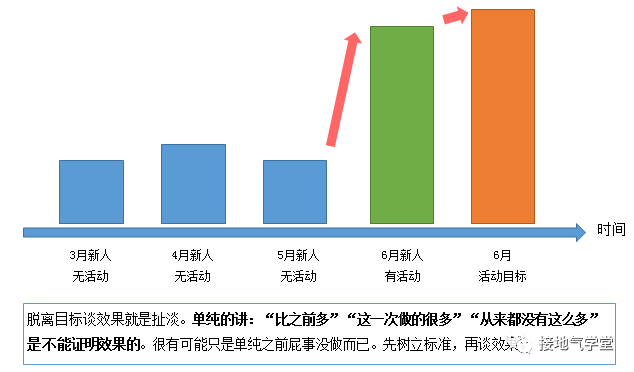

达标了,算好;不达标,不好。就这么简单(如下图)。

看似简单,实际上运营经常干的是:

- 稀里糊涂:老板让做我就做,至于为啥?咱也不知道,咱也不敢问。

- 呆头呆脑:我就是要做拉新人,拉就完了奥力给!

- 投机取巧:反正以前干过/别人也在干,干就完了。

- 浑水摸鱼:这是改变用户心智资源,数据岂能衡量!

总之,十个运营里最多只有俩,能准确说清楚现状和目标。这时候就需要数据分析师自己有独立判断能力。能分析业务逻辑、梳理业务过程,才能得出客观结论。这里我们拿完全稀里糊涂的场景举例,看如何帮运营理清目的。

三、从0建立评估模型的做法

1. 梳理活动流程

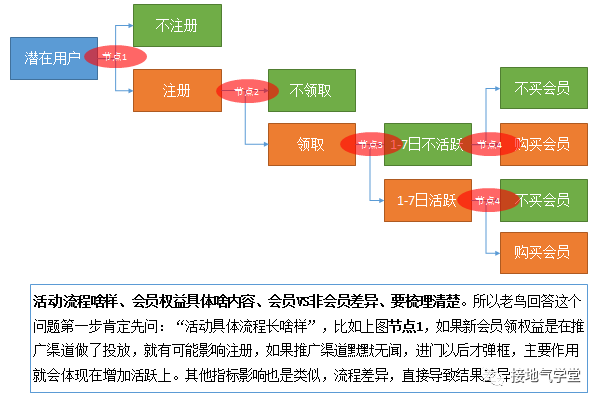

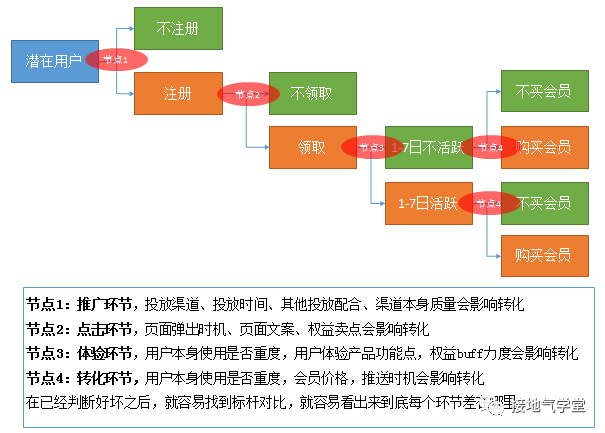

运营活动会改变用户的行为,进而体现为数据指标的变化。从0开始建立评估模型,第一步就是了解活动具体流程,了解活动可能导致的用户行为变化。比如问题里的新用户送权益,可以按如下梳理(如下图):

了解到行为变化以后,可以进一步看这些行为能用什么数据记录,能反映什么指标的变化。经过梳理,我们就能看清楚:衡量活动结果的指标。这些工作,应该是运营在策划阶段干的事,如果事前没做好,事后就要补课。

2. 筛选主指标

一个活动可能影响方方面面,比如上边的问题,有送东西,你说:

- 能增加新用户注册——没毛病。

- 能增加会员购买机会——似乎有机会。

- 能提升忠诚度减少流失——似乎也有道理。

- 能增加DAU——额,理论上新注册多了,DAU也增加。

如果不看数据,光听嘴巴讲,以上当然都有道理。但真要一锅炖,让你计算没有流失的用户,送会员占比百分之几,产品本身占比百分之几,歌曲数量占比百分之几,能算清楚就见鬼了。所以,评估指标要分主次,才容易说清楚问题。

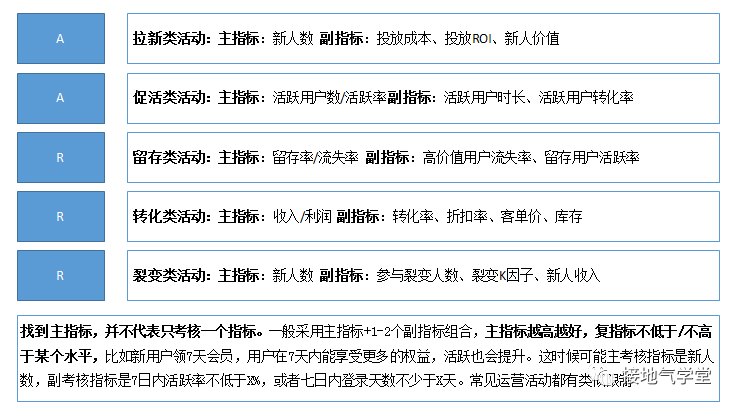

如果是事前定目标,那么活动的主指标应该与目标紧密结合,优选直接受影响的指标。比如活动是为了拉新,那主指标就是新注册用户数;如果活动是为了提高新用户留存率,那主要考虑的就是1-7日内留存情况。

这里看似简单,实则很容易被运营浑水摸鱼。运营经常喜欢扯一堆影响指标,甚至扯什么“我的活动从深层次改变了用户心智认知,从而达到了数据不可衡量的深远影响”,总之搞一堆指标进来,哪个好看说哪个,不好看的不说。做数据评估,最忌讳搞几百个指标然后做巨复杂的评估公式,混淆进来的的东西越多,就有越多搞文字游戏的空间,就越容易粉饰太平。越简单清晰的评估,才越容易看出问题。

3. 设定判断标准

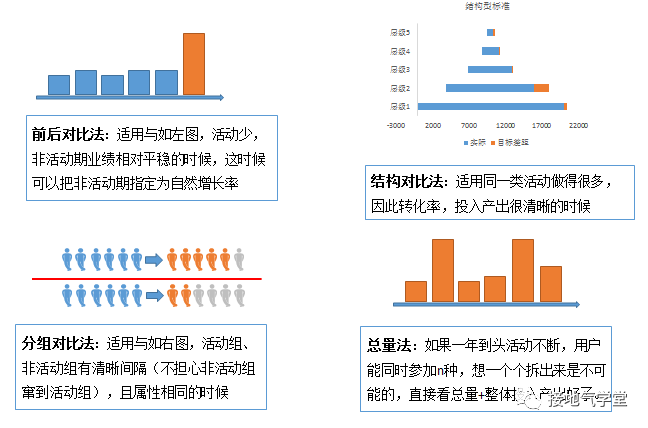

有了清晰的主指标,可以找判断标准。找标准有四个基本思路:

- 从整体结果出发,看总量。比如本月需要10万新用户,所以必须做到10万。

- 同无活动对比,看增量。比如无活动一个月5万,活动必须5+5万,多的5万作为标准。

- 同过往活动对比,看效率。比如拉新活动一般100块一个新人,所以这次不能超过。

- 同无参与的用户对比,看差异。比如分无参与组/参与组,对比参与组新注册数/留存率。

站在公司角度,肯定是第一种方法最实在。但站在组织活动的角度,都喜欢突出自己的贡献,因此倾向于用2、3、4种方法。运营最喜欢谈:自然增长率(没有活动情况下,自然增长是多少)。并且总是倾向于把自然增长率算得低低的,或者干脆弄成负数,这样才显得活动牛逼无比。

要注意的是:所谓自然增长率,只在活动不频繁的时候才能计算。很多业务(比如电商、O2O),根本就是活动不断,大活动套小活动,根本区分不出来,这时候就不适用。同理,设参照组的前提,是参照组根本没有活动提醒和活动参与功能,且参照组和活动组用户质量差不多。如果不满足这个限制条件就很难直接得出活动效益好的结论。这些方法都是看似科学,实则充满玩猫腻空间。想讨论清楚问题,就简单直接立标准。

4. 找影响结果的过程。

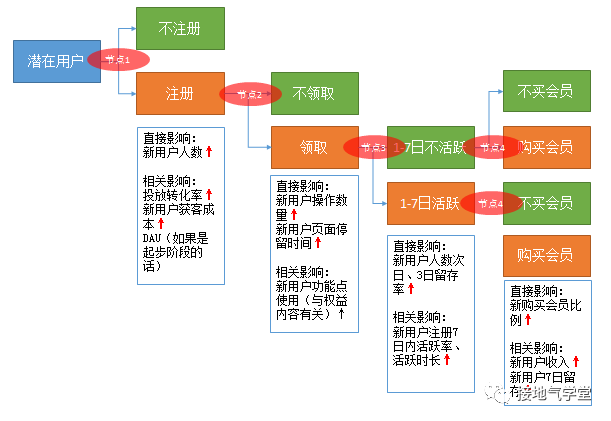

以上1、2、3步都是为了得出判断做铺垫。有了“好/坏”判断。就能进一步分析为啥好,为啥坏。这时候就需要细化梳理业务流程,找到能影响结果的关键点。比如拉新活动,广告投放渠道、广告文案、注册流程、进去以后提示权益方式、领取会员权益流程,都会有影响(如下图)。

在分析这些指标的时候,要注意先后顺序。比如有关新用户注册问题。要先看各个用户来源渠道的投放力度,活动是否及时上架,何时与投放结合。之后才是深入分析文案、活动礼品、领取后行为等等。

这个题目如果拿来面试,你能一眼看出来菜鸟、新手、老手的区别:

菜鸟:我认为应该从用户增长、产品体验、品牌影响、商业收入、四大方面考虑,blablabla。然后你就抓住品牌影响问他,到底怎么衡量,基本就能把他问死。没入门的菜鸟与新手之间最大差距,是他们根本不知道数据还需要做采集。菜鸟们最喜欢凭空讲一些很难收集,但听起来牛逼的指标。

新手:我认为应该考虑新人注册数、新人次日、3日、7日留存、新人会员领取率、新人留存市场、新人点击次数、新人购买会员数、新人使用权益频次……(此处省略100多个各色指标)。建立神经网络模型,综合评估。

是滴,新人第一喜欢堆砌指标,似乎指标越多越牛逼。第二喜欢扯模型,不管模型能不能用,自己用没用过,扯了就牛逼。唯独会忽视标准问题。想怼死新人,只要问“凭什么增长5万就是好,4万9千1百2十7就不好!”“你建神经网络评价模型,好/坏活动的标注谁来打,是对整个活动打标还是对某些指标打标,不同类型活动凭什么摆在一起打标”基本就把新人问蒙了。

说到底,活动评估这件事,又是一件思路清晰比技术高深重要,守住节操比思路清晰重要的事。只要对运营常见活动:拉新、促活、留存、转化、裂变等等玩法有基础了解。对常规运营数据有认识,对过往活动有了解跌,基本上都能答出正确答案。怕就怕对业务流程了解太少,连人家在干啥都不懂。

作者:接地气的陈老师,公众号:接地气学堂

本文由@接地气的陈老师 原创发布于运营派,未经许可,禁止转载。

题图来自Unsplash,基于CC0协议

Recommend

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK