8

kafka消费者内存一直上涨

source link: https://www.oschina.net/question/4175317_2324548

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

kafka消费者内存一直上涨

spring-kafka 版本:1.3.4.RELEASE

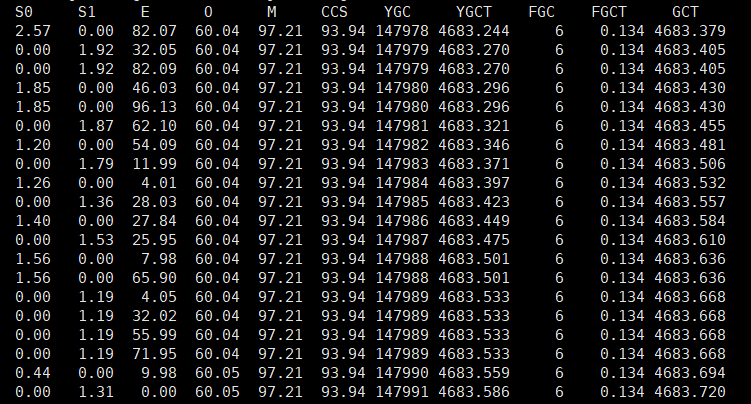

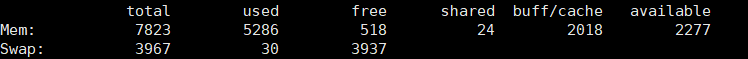

消费者三台机器(每台内存不到8G),消费10几个topic,每个topic 3个分区

为什么内存一直上升,不释放

以下是问题补充:

@Allen吴:消息大量堆积,消费者内存上升很快

(昨天 16:50)

yongk

今天 11:25

一些push类型的MQ,都有prefetch特性,就是broker会多push一些msg给consumer,来提高吞吐量,这些在consumer端还没来得及处理的msg就占用consumer的内存。

但Kafka是pull类型的MQ,你看看会不会是类似的问题,kakfa为了提高吞吐量有没有相关设置。

Recommend

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK