清华大学用6个无线传感器搞定全身动作捕捉,可跑可跳可打滚

source link: https://www.36kr.com/p/1258200300793348

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

编者按:本文来自微信公众号“量子位”(ID:QbitAI),作者:梦晨,36氪经授权发布。

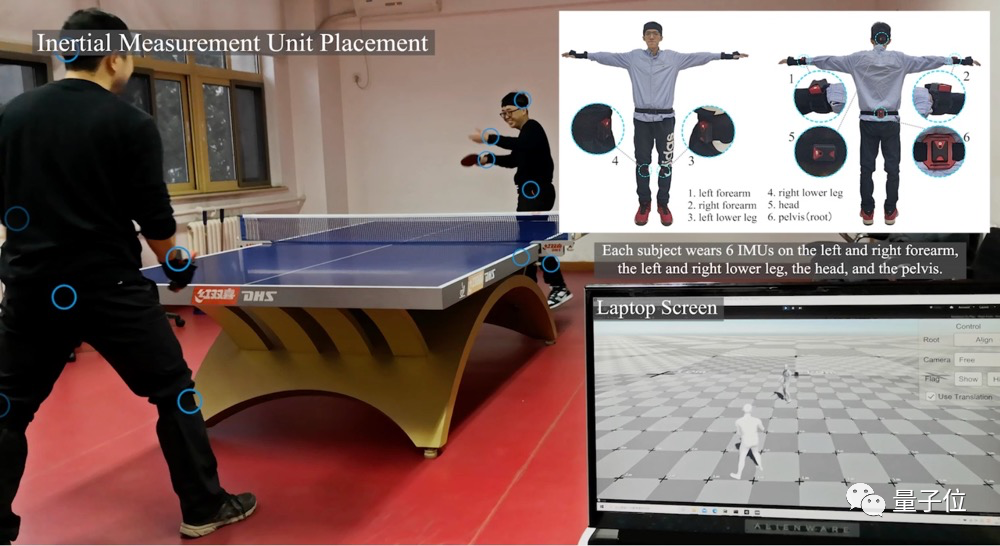

来自清华的研究团队发布了一段视频:

两人打球的动作精准又流畅地被右下角的笔记本电脑捕捉到。

但是房间里没看到摄像头,两人身上也好像没穿戴什么装备?

印象中的全身3D动捕的一套装备和场地布置,可是这样的:

△光学动捕,《最后生还者》拍摄现场

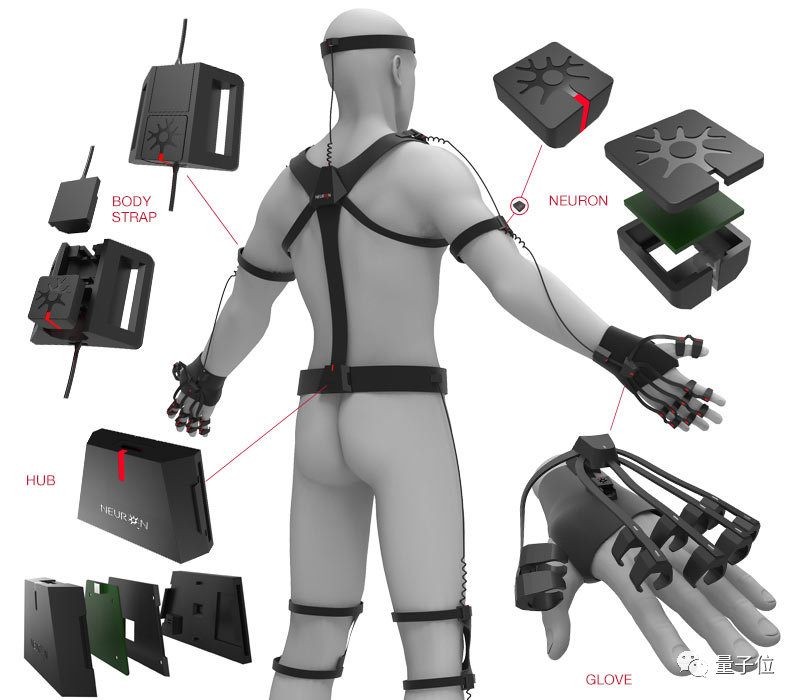

或是这样的:

△惯性动捕

最轻便的也得有5、6斤,价格便宜的就更重了能达到10几斤。穿在身上影响动作的灵活性,而且很快就会累了,基本无法日常使用。

视频中的装备,后面标记出来才看到,两人身上各自只戴了6个小型惯性传感器,还是无线的。

现在市面上的VR设备主要用的是光学动作捕捉。

要知道VR刚出来那会不管有线无线,最大的障碍是要在房间周围摆上3到6个柱子。

后来简化成了头戴设备上的摄像头向外扫描周围的环境实现定位,加上两个手柄上的惯性传感器,如PSVR。

但动作捕捉的范围就只能是以头部和手部为主,腿部动作一直是难题。移动只能在画面里前进,并不能将腿部的具体动作在游戏中表现出来。

△VR游戏《半条命:Alyx》中的移动方式之一

或者健身环,简单地检测到你在抬腿,再模拟成游戏中固定的腿部动画,或借用游戏中的交通工具。

而现在,清华大学的新方法,可以实时捕捉跳跃和蹲爬,帧数都是90fps:

跨越障碍,甚至是躺下打滚都没问题:

除了能跟踪人体的全身动作,还能实现在空间上的定位。由于不需要固定的传感器,长距离移动也没问题。

与光学动捕相比,惯性动捕还有两个好处。一个是不怕环境障碍物遮挡。

第二个是对照明环境没有要求,夜间也可以。

除了个人VR游戏外,新的惯性动捕技术还可能降低商业动作捕捉的成本,让小规模的制作团队也有机会用上。

在游戏和动画电影中,动作捕捉摄影棚是这样的:

这恐怕只有大公司才承担得起了。

除了娱乐外,动作捕捉技术在医疗领域也有应用,可以用数据指导伤者更好地进行康复训练。

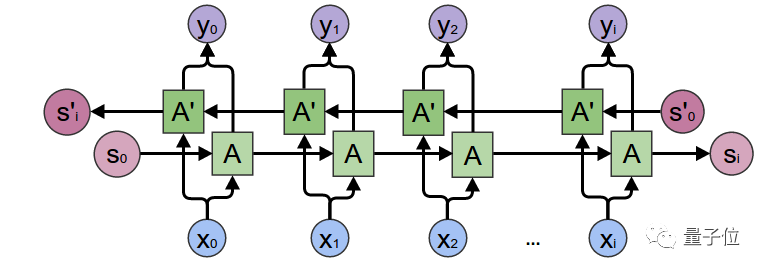

双向循环神经网络

这么好的方法是怎么实现的呢?原来是靠深度学习。

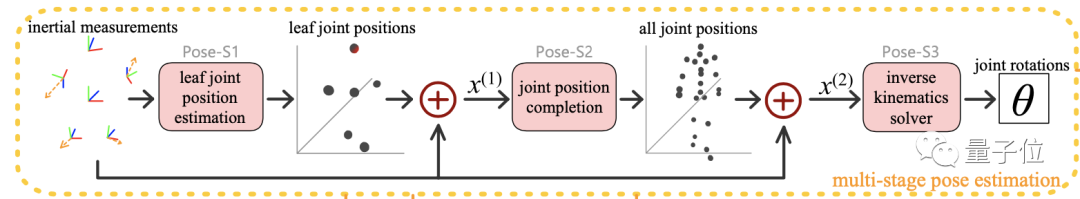

研究团队分阶段将动作捕捉拆成3个子任务。先从惯性数据算出5个主要节点头部和四肢的位置,再细化成全部23个节点的位置,最后通过反向动力学(IK)求解。

由于预测连续的动作不仅要依赖前面的计算结果,还要参考后面一层的结果。所以在这一步用到的是双向循环神经网络(biRNN)。

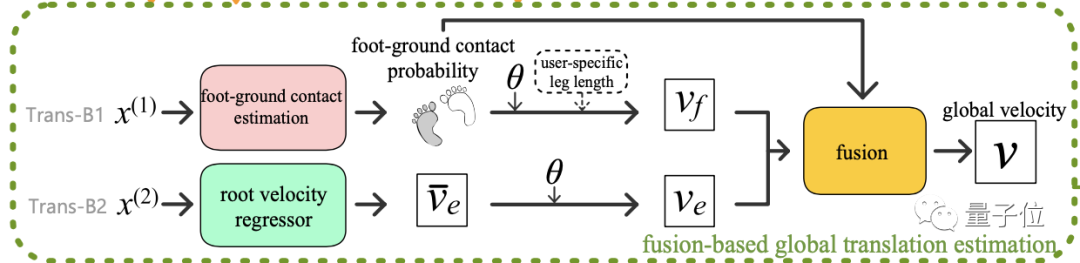

在空间定位问题也是拆成两部分。一个是脚与地面接触的概率分布,再结合根结点的速度,算出在世界坐标的速度,同样用到RNN与biRNN。

对于不同的任务使用不同的公开数据集进行训练,包含300名受试者超过40小时的姿势和空间位置参数。

与之前的研究相比,任务拆解的方法有助于用更少资源获得更高帧数,可以胜任高速运动的捕捉。

并且实现了动作捕捉的同时进行空间定位。

不过,还是有两点不足。一个是动作捕捉的效果依赖于训练数据集,对训练集中没有的动作效果就一般。

还有在计算脚与地面的接触概率分布时,假定了接触时脚是固定不动的,不能适用于滑板等运动。

本项目论文已被计算机图形顶会SIGGRAPH 2021接受。

研究团队来自清华大学北京信息科学与技术国家研究中心和软件学院。

徐枫团队副教授团队,第一作者伊昕宇。

项目地址:https://xinyu-yi.github.io/TransPose/

论文地址:https://arxiv.org/abs/2105.04605

Recommend

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK