利用 Python 爬取了 13966 条运维招聘信息,我得出了哪些结论?

source link: https://news.51cto.com/art/202007/620944.htm

Go to the source link to view the article. You can view the picture content, updated content and better typesetting reading experience. If the link is broken, please click the button below to view the snapshot at that time.

利用 Python 爬取了 13966 条运维招聘信息,我得出了哪些结论?

我经常会收到读者关于一系列咨询运维方面的事情,比如:杰哥,运维到底是做什么的呀?运维的薪资水平/ 待遇怎么样呢?杰哥帮忙看下这个岗位的招聘需要对于小白来说,能否胜任的了呢?等等。

作者:JackTian来源:高效运维|2020-07-14 10:19大家好,我是 JackTian。

我经常会收到读者关于一系列咨询运维方面的事情,比如:杰哥,运维到底是做什么的呀?运维的薪资水平/ 待遇怎么样呢?杰哥帮忙看下这个岗位的招聘需要对于小白来说,能否胜任的了呢?等等。

这里,我把之前写的《一篇文章带你解读从初级运维工程师到资深运维专家的学习路线》,本文从初级 / 中级 / 高级运维工程师以及到资深方向逐步展开给大家汇总了一些各阶段所具备的技能,仅供学习路线参考,如有补充,可通过本文进行留言参与互动。

这次呢,杰哥带着一种好奇心的想法,结合自身的工作经验与业界全国关于招聘运维工程师的岗位做一个初步型的分析,我的一位好朋友 —— 黄伟呢,帮我爬取了 13966 条关于运维的招聘信息,看看有哪些数据存在相关差异化。主要包括内容:

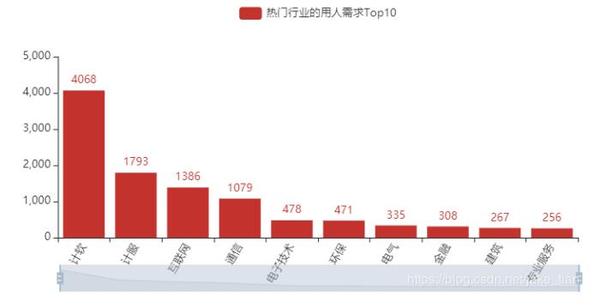

- 热门行业的用人需求 Top10

- 热门城市的岗位数量 Top10

- 岗位的省份分布

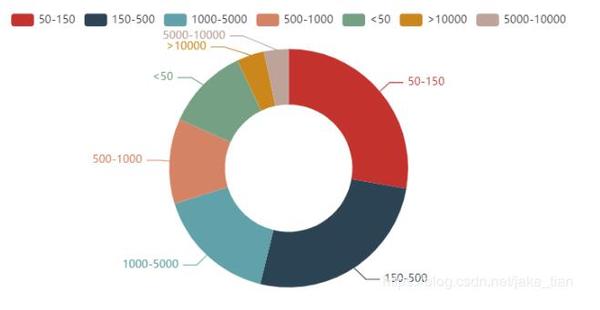

- 不同公司规模的用人情况

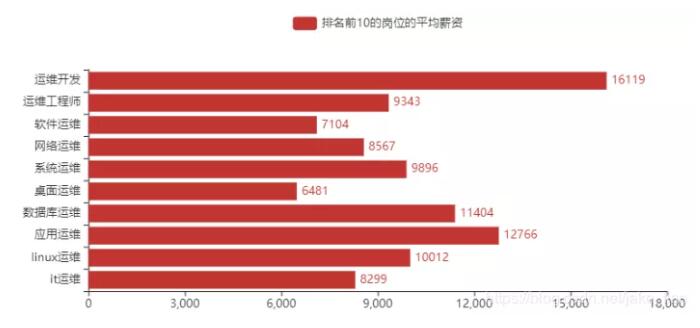

- 排名前 10 的岗位的平均薪资

- 岗位对学历的要求

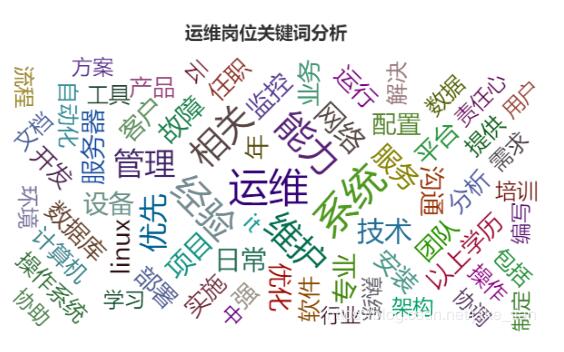

- 运维岗位需求的词云图分布

对于本文的叙述,我们分以下三步为大家讲解。

- 数据可视化及分析

1、爬虫部分

本文主要爬取的是 51job 上面,关于运维相关岗位的数据,网站解析主要使用的是Xpath,数据清洗用的是 Pandas 库,而可视化主要使用的是 Pyecharts 库。

相关注释均已在代码中注明,为方便阅读,这里只展示部分代码,完整代码可查看文末部分进行获取。

- # 1、岗位名称

- job_name = dom.xpath('//div[@class="dw_table"]/div[@class="el"]//p/span/a[@target="_blank"]/@title')

- # 2、公司名称

- company_name = dom.xpath('//div[@class="dw_table"]/div[@class="el"]/span[@class="t2"]/a[@target="_blank"]/@title')

- # 3、工作地点

- address = dom.xpath('//div[@class="dw_table"]/div[@class="el"]/span[@class="t3"]/text()')

- # 4、工资

- salary_mid = dom.xpath('//div[@class="dw_table"]/div[@class="el"]/span[@class="t4"]')

- salary = [i.text for i in salary_mid]

- # 5、发布日期

- release_time = dom.xpath('//div[@class="dw_table"]/div[@class="el"]/span[@class="t5"]/text()')

- # 6、获取二级网址url

- deep_url = dom.xpath('//div[@class="dw_table"]/div[@class="el"]//p/span/a[@target="_blank"]/@href')

- # 7、爬取经验、学历信息,先合在一个字段里面,以后再做数据清洗。命名为random_all

- random_all = dom_test.xpath('//div[@class="tHeader tHjob"]//div[@class="cn"]/p[@class="msg ltype"]/text()')

- # 8、岗位描述信息

- job_describe = dom_test.xpath('//div[@class="tBorderTop_box"]//div[@class="bmsg job_msg inbox"]/p/text()')

- # 9、公司类型

- company_type = dom_test.xpath('//div[@class="tCompany_sidebar"]//div[@class="com_tag"]/p[1]/@title')

- # 10、公司规模(人数)

- company_size = dom_test.xpath('//div[@class="tCompany_sidebar"]//div[@class="com_tag"]/p[2]/@title')

- # 11、所属行业(公司)

- industry = dom_test.xpath('//div[@class="tCompany_sidebar"]//div[@class="com_tag"]/p[3]/@title')

2、数据清洗

1)读取数据

- # 下面使用到的相关库,在这里展示一下

- import pandas as pd

- import numpy as np

- import re

- import jieba

- df = pd.read_csv("only_yun_wei.csv",encoding="gbk",header=None)

- df.head()

2)为数据设置新的行、列索引

- # 为数据框指定行索引

- df.index = range(len(df))

- # 为数据框指定列索引

- df.columns = ["岗位名","公司名","工作地点","工资","发布日期","经验与学历","公司类型","公司规模","行业","工作描述"]

- df.head()

3)去重处理

- # 去重之前的记录数

- print("去重之前的记录数",df.shape)

- # 记录去重

- df.drop_duplicates(subset=["公司名","岗位名","工作地点"],inplace=True)

- # 去重之后的记录数

- print("去重之后的记录数",df.shape)

4)对岗位名字段的处理

- # ① 岗位字段名的探索

- df["岗位名"].value_counts()

- df["岗位名"] = df["岗位名"].apply(lambda x:x.lower())

- # ② 构造想要分析的目标岗位,做一个数据筛选

- df.shape

- target_job = ['运维','Linux运维','运维开发','devOps','应用运维','系统运维','数据库运维','运维安全','网络运维','桌面运维']

- index = [df["岗位名"].str.count(i) for i in target_job]

- index = np.array(index).sum(axis=0) > 0

- job_info = df[index]

- job_info.shape

- job_list = ['linux运维','运维开发','devOps','应用运维','系统运维','数据库运维'

- ,'运维安全','网络运维','桌面运维','it运维','软件运维','运维工程师']

- job_list = np.array(job_list)

- def rename(x=None,job_list=job_list):

- index = [i in x for i in job_list]

- if sum(index) > 0:

- return job_list[index][0]

- else:

- return x

- job_info["岗位名"] = job_info["岗位名"].apply(rename)

- job_info["岗位名"].value_counts()[:10]

5)工资字段的处理

- job_info["工资"].str[-1].value_counts()

- job_info["工资"].str[-3].value_counts()

- index1 = job_info["工资"].str[-1].isin(["年","月"])

- index2 = job_info["工资"].str[-3].isin(["万","千"])

- job_info = job_info[index1 & index2]

- job_info["工资"].str[-3:].value_counts()

- def get_money_max_min(x):

- if x[-3] == "万":

- z = [float(i)*10000 for i in re.findall("[0-9]+\.?[0-9]*",x)]

- elif x[-3] == "千":

- z = [float(i) * 1000 for i in re.findall("[0-9]+\.?[0-9]*", x)]

- if x[-1] == "年":

- z = [i/12 for i in z]

- return z

- except:

- return x

- salary = job_info["工资"].apply(get_money_max_min)

- job_info["最低工资"] = salary.str[0]

- job_info["最高工资"] = salary.str[1]

- job_info["工资水平"] = job_info[["最低工资","最高工资"]].mean(axis=1)

6)工作地点字段的处理

- address_list = ['北京', '上海', '广州', '深圳', '杭州', '苏州', '长沙',

- '武汉', '天津', '成都', '西安', '东莞', '合肥', '佛山',

- '宁波', '南京', '重庆', '长春', '郑州', '常州', '福州',

- '沈阳', '济南', '宁波', '厦门', '贵州', '珠海', '青岛',

- '中山', '大连','昆山',"惠州","哈尔滨","昆明","南昌","无锡"]

- address_list = np.array(address_list)

- def rename(x=None,address_list=address_list):

- index = [i in x for i in address_list]

- if sum(index) > 0:

- return address_list[index][0]

- else:

- return x

- job_info["工作地点"] = job_info["工作地点"].apply(rename)

- job_info["工作地点"].value_counts()

7)公司类型字段的处理

- job_info.loc[job_info["公司类型"].apply(lambda x:len(x)<6),"公司类型"] = np.nan

- job_info["公司类型"] = job_info["公司类型"].str[2:-2]

- job_info["公司类型"].value_counts()

8)行业字段的处理

- job_info["行业"] = job_info["行业"].apply(lambda x:re.sub(",","/",x))

- job_info.loc[job_info["行业"].apply(lambda x:len(x)<6),"行业"] = np.nan

- job_info["行业"] = job_info["行业"].str[2:-2].str.split("/").str[0]

- job_info["行业"].value_counts()

9)经验与学历字段的处理

- job_info[“学历”] = job_info[“经验与学历”].apply(lambda x:re.findall(“本科|大专|应届生|在校生|硕士|博士”,x))

- def func(x):

- if len(x) == 0:

- return np.nan

- elif len(x) == 1 or len(x) == 2:

- return x[0]

- else:

- return x[2]

- job_info[“学历”] = job_info[“学历”].apply(func)

- job_info[“学历”].value_counts()

10)公司规模字段的处理

- def func(x):

- if x == “[‘少于50人’]”:

- return “<50"

- elif x == "['50-150人']":

- return "50-150"

- elif x == "['150-500人']":

- return '150-500'

- elif x == "['500-1000人']":

- return '500-1000'

- elif x == "['1000-5000人']":

- return '1000-5000'

- elif x == "['5000-10000人']":

- return '5000-10000'

- elif x == "['10000人以上']":

- return ">10000”

- else:

- return np.nan

- job_info[“公司规模”] = job_info[“公司规模”].apply(func)

11)将处理好的数据,构造新数据,导出为新的 excel

- feature = [“公司名”,”岗位名”,”工作地点”,”工资水平”,”发布日期”,”学历”,”公司类型”,”公司规模”,”行业”,”工作描述”]

- final_df = job_info[feature]

- final_df.to_excel(r”可视化.xlsx”,encoding=”gbk”,index=None)

3、数据可视化

1)可视化大屏效果

2)热门行业的用人需求 Top10

从招聘行业的数据来看,计算机软件,计算机服务,互联网,通信行业用人需求相比其他行业占比会高。

3)热门城市的岗位数量 Top10

从热门城市来看,北上广深的一线城市,用人岗位数占比较大,不过这里的异地招聘数据及结合过往经验,偏外包性质的企业。

4)岗位的省份分布

岗位分布省份,通过最左侧的颜色棒,我们可以看出颜色最深的地区岗位招聘数越集中,相反之下,最浅的也就是岗位招聘数越少的省份。从下图来看,广东省、江苏省、上海及北京颜色相比其他省份占据分布会比较集中些。

5)不同公司规模的用人情况

行业的不同,公司规模肯定是存在有差异的。公司规模是指按有关标准和规定划分的公司规模,一般分为特大型、大型、中型、小型、微型。如下图,公司规模人数在 50-500 范围内占据 50% 以上,用人需求最高,1000-10000 范围占据不到 50 %,不过这样的公司规模已经是比较大的了。

6)排名前 10 的岗位的平均薪资

根据我的了解,比如:系统工程师、软件 / 实施工程师、运维专员 等一系列的岗位其实也是可以划分在运维领域范畴之内的,每家公司对运维工作者的岗位名称定义有所不同,为了能够更精准的筛选分析,把那些岗位占时去掉了。留下了以下 10 个岗位名称(运维开发、运维工程师、软件运维、网络运维、系统运维、桌面运维、数据库运维、应用运维、Linux 运维、IT 运维)这些岗位名称基本是我见过招聘信息内最多的。

排名前 10 的岗位平均薪资,运维开发、应用运维、数据库运维、Linux 运维均在 1W 以上。因此,也可以看出运维开发在运维领域的优势,是占据前沿位置。

7)运维岗位的学历要求分布

从学历要求方面来看,大专及本科学历占比居多。在校生、硕士、博士基本太少了,因此会有一些我的学生群体读者会问我,对于一个应届毕业生,找运维工作好找吗?站在我个人的角度,我是不建议你毕业后去做运维的。因为运维对你个人的技术水平及工作经验有些非常高的要求,而对于一个刚毕业的学生来说,没有过多的实践经验,也不会有很大的优势,除非是这个岗位对你有极大的兴趣爱好,但凡你也可以尝试下。

8)运维岗位需求的词云图分布

从运维岗位招聘需求词云图来看,词频最多的主要包括:运维、能力、系统、维护、经验等等,因此也可以看出运维岗位对个人技术能力以及过往工作经验是要求非常高的。当然了还有很多其他相关的词频,可通过下图查看详情。

介绍了这么多,相信你也对运维工程师有了初步的认识与了解,通过本篇文章你可以了解到哪些行业的对运维的用人需求是比较高的?最为招聘运维热门的城市有哪些?运维岗位的分布、不同公司规模对运维工程师的用人情况占比、关于运维相关岗位的平均薪资、招聘运维岗位对学历的要求以及运维岗位需求词云图包括哪些词频最多,通过这一数据的分析,相信能对你在今后的运维求职方向、行业、城市以及公司规模有所初步的判断及选择,希望对你有所帮助。

【编辑推荐】

Recommend

About Joyk

Aggregate valuable and interesting links.

Joyk means Joy of geeK